Извлечение предпочтений пользователя на основе методов автоматического порождения текстовых описаний изображений фотоальбома

Автор: Харчевникова Ангелина Сергеевна, Савченко Андрей Владимирович

Журнал: Компьютерная оптика @computer-optics

Рубрика: Обработка изображений, распознавание образов

Статья в выпуске: 4 т.44, 2020 года.

Бесплатный доступ

В работе рассматривается задача извлечения предпочтений пользователя по его фотоальбому. Предложен новый подход на основе автоматического порождения текстовых описаний фотографий и последующей классификации таких описаний. Проведен анализ известных методов создания аннотаций по изображению на основе свёрточных и рекуррентных (Long short-term memory) нейронных сетей. С использованием набора данных Google’s Conceptual Captions обучены новые модели, в которых объединяются характерные признаки фотографии и выходы блока рекуррентной нейронной сети. Исследовано применение алгоритмов обработки текстов для преобразования полученных аннотаций в пользовательские предпочтения. Проведены экспериментальные исследования с помощью наборов данных Microsoft COCO Captions, Flickr8k и специально собранного набора данных, отражающего интересы пользователя. Показано, что наилучшее качество определения предпочтений достигается с помощью методов поиска ключевых слов и суммаризации текстов из Watson API, которые оказываются на 8 % точнее по сравнению с традиционным латентным размещением Дирихле. При этом описания, порожденные с помощью обученных моделей, классифицируются на 1 - 7 % точнее известных аналогов.

Анализ предпочтений пользователя, обработка изображений, текстовое описание изображений, сверточные нейронные сети

Короткий адрес: https://sciup.org/140250030

IDR: 140250030 | DOI: 10.18287/2412-6179-CO-678

Текст научной статьи Извлечение предпочтений пользователя на основе методов автоматического порождения текстовых описаний изображений фотоальбома

Задачи, связанные с построением рекомендательных систем или сервисов контекстной рекламы, в настоящий момент являются одними из наиболее актуальных приложений технологий искусственного интеллекта [1 –3]. При этом чаще всего в качестве исходных данных для таких систем используется структурированная или текстовая информация, содержащая, например, отзывы пользователя о некоторых продуктах [2, 4, 5]. К сожалению, во многих случаях в таких системах возникает проблема «холодного старта»: имеющихся данных об отзывах или покупках, сделанных конкретным пользователем, может быть недостаточно для выдачи надежных рекомендаций. Поэтому в настоящей работе предлагается для извлечения первоначальной информации о предпочтениях пользователя воспользоваться галереей его фотографий. Действительно, в современном мире одними из самых достоверных источников данных о пользователе являются его мобильные устройства. Гигабайты информации, хранящиеся в фотоальбомах пользователей, могут послужить основой для постро- ения профиля интересов. Например, если в галерее пользователя преобладают фотографии, связанные со спортом или здоровым образом жизни, то в путешествии ему будут предложены спортивные товары и места для посещения. Рассматриваемая задача определения предпочтений пользователя по его фотоальбому представляет несомненную практическую значимость, но все ещё недостаточно исследована.

Стоит отметить, что изображения в фотоальбоме зачастую содержат персональную информацию, поэтому накладываются существенные ограничения на прямую передачу данных на сервер и последующую обработку с помощью современных высокоточных методов глубокого обучения [6]. К сожалению, вычислительная эффективность и сложность по затратам памяти таких методов является недостаточной для их реализации даже на современных мобильных устройствах. В связи с этим в настоящее время наблюдается заметная тенденция к разработке эффективных архитектур свёрточных нейронных сетей (англ. convolutional neural network, CNN), которые могут быть использованы непосредственно на мобильном устройстве [7]. Однако их точность в ряде приложений может быть значительно ниже точности CNN с большим числом скрытых слоев.

В настоящей работе предлагается воспользоваться альтернативным подходом, в котором вначале автоматически получается текстовое описание фотографии, а далее полученные описания преобразуются в пользовательские предпочтения. Словарь для получаемых текстовых описаний может быть выбран так, что получаемые аннотации изображений не содержат персональной информации. Поэтому при таком подходе описания фотографий могут обрабатываться и на удаленном вычислительном сервере для повышения надежности решения. Исследованию в этом актуальном направлении и посвящена предлагаемая статья.

1. Постановка задачи

Задача извлечения предпочтений пользователя по его фотоальбому состоит в том, чтобы поступившему на вход фотоальбому (галереи) – множеству фотографий – выделить наиболее интересные для пользователя из некоторого множества номеров категорий {1, 2,…, L }, где L – общее число категорий. Такими категориями могут являться искусство, спорт, высокие технологии, еда, музыка и другие возможные увлечения и предпочтения пользователя. В общем случае множество категорий, интересных пользователю, является подмножеством множества всех категорий {1, 2,…, L }.

Предполагается, что для обучения системы для каждой категории задано множество соответствующих ей изображений сцен и событий. Например, для категории «спорт» собирается множество фотографий разнообразных спортивных сцен. Задача анализа предпочтений тогда сводится к известной задаче мультиклассовой (multi-label) классификации набора изображений [2, 8].

Для решения задачи каждое изображение из фотоальбома можно обрабатывать изолированно с использованием известных методов распознавания сцен [9]. При этом для настройки классификатора может применяться собранное обучающее множество. Здесь может использоваться как традиционное дообучение CNN, так и предварительное детектирование объектов (примитивов), из которых состоят сцены [10]. В последнем случае необходимо сформировать алфавит признаков, на основе которых изображения следует относить к той или иной категории [11]. В обоих вариантах результатом анализа предпочтений можно считать частоты встречаемости распознанных сцен, соответствующих каждой категории на всех фотографиях из галереи.

2. Предлагаемый подход

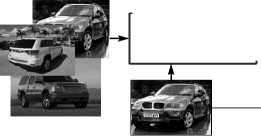

Рассмотрим функциональную схему (рис. 1) предлагаемой системы извлечения предпочтений пользователя по его фотоальбому на основе методов автоматического порождений описаний изображений.

Здесь решение поставленной задачи выявления предпочтений пользователя состоит из двух основных этапов. На первом этапе получается текстовое представление каждой из анализируемых фотографий: автоматически формируется некоторое сочетание слов или целое предложение в зависимости от качества снимка, количества изображенных объектов, их взаимодействия, а также наличия всевозможных деталей фона, к примеру зрители матча на стадионе. Полученные текстовые описания характеризуют представленные на изображении объекты и связи между ними, например, взаимное расположение этих объектов. Для этого каждая фотография из фотоальбома поочередно подается на вход блока обработки изображения, где производится изменение масштаба и нормировка. После чего преобразованные фотографии попадают на вход CNN. Выходом блока являются векторы характерных признаков, полученные с предпоследнего слоя. Далее на основе извлеченного вектора признаков выполняется порождение текста. В зависимости от выбранной архитектуры сети выполняется предсказание слова по текущей текстовой последовательности – аннотации каждого изображения. Полученные текстовые описания объединяются в общий текст, описывающий весь фотоальбом.

Обработка изображения

Рис. 1. Функциональная схема предлагаемой системы извлечения интересов пользователя

На втором этапе в заключительном блоке, в котором полученные текстовые аннотации классифицируются и принимается итоговое решение о потенциальной сфере предпочтений пользователя. Рассмотрим три альтернативных способа преобразования полученных аннотаций в пользовательские предпочте- ния. Наиболее интуитивным способом является подсчет ключевых слов в сформированных текстах. Будем полагать, что слова, встречающиеся в тексте максимальное количество раз, и отвечают за целевое предпочтение для текущего пользователя:

K l * = arg max £ I[ ik = l ], (1) i=1,...,L k=1

где k – номер слова в последовательности, l – индекс слова-предпочтения в заданном словаре, I – функция-индикатор. Такой подход является реализацией рассмотренного в предыдущем параграфе варианта решения задачи, в котором детектирование объектов заменяется на порождение текстовых описаний. Алфавит признаков, использующийся для описания каждой категории предпочтений, состоит из ключевых слов, предварительно выбранных для каждой темы экспертом вручную с учётом, например, распределения терминов в теме. В результате этот подход не использует семантическое значение входных слов, а также не выявляет значимые для результата устойчивые словосочетания, что накладывает существенные ограничения на формирование общей темы для группы фотографий.

Как известно, в задачах обработки естественного языка особое место занимают алгоритмы тематического моделирования, которые для заданной коллекции текстов автоматически формируют степень принадлежности всех документов к каждой из тем [12, 13]. Для обучения подобных моделей требуется большая выборка текстов с тематическими метками. В данной работе будет использоваться латентное размещение Дирихле (англ. Latent Dirichlet Allocation, LDA) [14], которое автоматически выделяет различные темы в текстах и слова, наиболее характерные для каждой темы.

Наконец, ещё один способ формирования предпочтений пользователя состоит в автоматической сум-маризации текстов с использованием API коммерческой когнитивной системы Watson компании IBM для выделения ключевых фраз в тексте [15, 16, 17]. В частности, использовались сервисы «Natural Language Classifier» и «Natural Language Understanding», которые позволяют выявлять тематическую принадлежность для неструктурированных текстов.

Заметим, что предложенный подход может как полностью выполняться на мобильном устройстве, так и реализовываться с помощью технологии клиент-сервер, в которой характерные признаки каждой фотографии извлекаются непосредственно на устройстве, а порождение текстовых описаний и их преобразование в предпочтения пользователя осуществляется с помощью высокоточных нейросетевых архитектур на вычислительном сервере. Рассмотрим подробнее основной компонент предлагаемого подхода – нейросетевые модели автоматического порождения описаний изображений.

3. Порождение текстовых описаний изображения

Задача автоматического порождения описаний изображений состоит в том, чтобы вновь поступающее на вход изображение X представить как некоторую последовательность слов определенной длины W = { w i 1 ,.., w ik }, i k e {1,^, N}. Здесь w ik - векторное представление слова c уникальным идентификатором i k в заранее выбранном словаре, N – общее количество слов в словаре, k – номер слова в последовательности.

Для решения задачи на предварительном этапе для каждого доступного изображения осуществляется извлечение характерных признаков [18]. В настоящий момент наиболее часто для настройки классификатора применяется не доступное обучающее множество, а сверхбольшая коллекция дополнительно собранных изображений. Такая коллекция используется для обучения глубокой CNN [19], состоящей из нескольких чередующихся слоев свертки и подвыборки, выход которых поступает на вход последовательно соединенных полносвязных слоев [6]. Подавая на вход сети изображение X , извлекают его D -мерный вектор характерных признаков x на выходе из D >> 1 значений предпоследнего слоя.

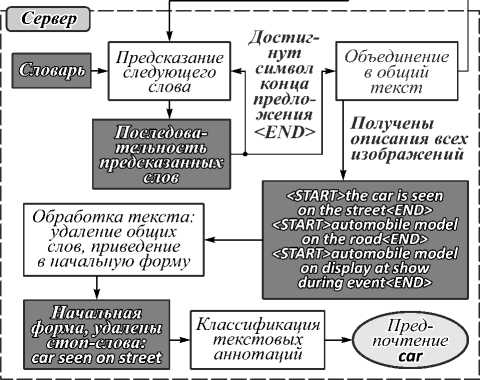

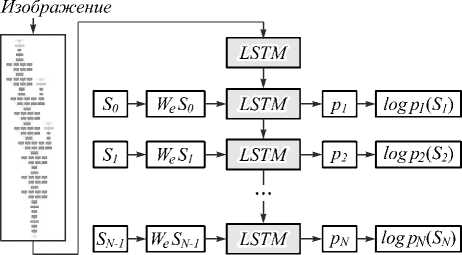

Одним из главных вопросов, возникающих при создании модели для порождения текстовых аннотаций, является выбор нейролингвистической архитектуры, в которой вектор признаков x преобразуется в текстовое описание W. В современной литературе определяют два основных вида таких сетей, которые по своей структуре отличаются только тем, как CNN соединяется с рекуррентной сетью типа Long-Short Term Memory (LSTM) [20]. С одной стороны, вектор признаков изображения может быть подан на вход рекуррентной нейронной сети совместно с последовательностью слов в процессе обучения модели. Такой тип архитектур называется «injecting» (рис. 2) [20, 21]. В качестве примера такой архитектуры можно привести модель im2txt , которая победила на первом соревновании по порождению аннотаций изображений «MS COCO Captions Image Captioning Chal-lenge» в 2015 году [22]. Модель представляет собой пример процесса кодирования-декодирования. Она сначала преобразует входное изображение в векторное представление, а далее переводит результат в текстовое представление.

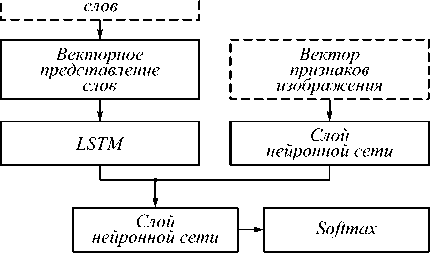

Другим типом нейролингвистических архитектур являются модели, выполняющие объединение («merge», рис. 3) вектора признаков изображения с выходом рекуррентной сети (LSTM) для генерации текстовых описаний. В отличие от первой группы здесь CNN не является частью рекуррентной нейронной сети, так что последняя обрабатывает исключительно лингвистическую информацию [20, 23]. При этом предполагается, что объёма обучающей выборки текстовых описания достаточно для автоматического извлечения рекуррентной сетью грамматических и семантических связей, поэтому для работы системы (рис. 1) необходимо указать только словарь.

I Последовательность I

Рис. 2. Архитектура порождения описаний изображений: «injecting»

Рис. 3. Архитектура порождения описаний изображений:

«merge»

В любой такой архитектуре для порождения текстового описания на вход модели подается вектор признаков

x

, а также последовательность уже предсказанных ранее слов {

w

i

1

,…,

w

ik

}. В самом начале эта последовательность состоит из одного элемента – векторного представления специального символа начала последовательности

P ( w n | X ; W i i ,..., W i k — ) = softmax zn ( X ) = = exp( z n ( X ))/ £ exp( z , ( X )).

j = 1

Здесь z n ( X ) – выход предпоследнего слоя нейронной сети. Обычно решение принимается с помощью «жадного алгоритма» в пользу индекса слова с максимальной апостериорной вероятностью (2):

ik = argmax P ( w JX ; W i i ,..., W i k - i ) . (3)

n = 1,2,..., N

Так как на каждом шаге могут быть порождены сразу несколько подходящих по смыслу слов, «жадный» выбор только одного из них не всегда приводит к выбору наиболее вероятной последовательности слов. В таком случае к лучшим результатам обычно приводит применение алгоритма Beam Search, определяющего стратегию поиска для выбора нескольких лучших результатов из всех возможных кандидатов [24]. На каждом шаге выделяется фиксированное число B (параметр алгоритма) наиболее вероятных следующих слов для B выбранных последовательностей длины k –1, после чего среди получаемых новых B2 последовательностей выбирается B лучших, соответствующих наибольшим значениям оценок апостериорной вероятности (2).

Процесс рекуррентного порождения текстовых описаний повторяется до тех пор, пока в порожденной последовательности не появится специальный символ окончания описания

4. Результаты экспериментальных исследований моделей порождения текстовых описаний

Для тестирования качества порождения текстовых описаний изображений использовались следующие наборы данных, специально разработанные для решения подобных задач:

-

1. Flickr8k предоставляет коллекцию 8000 эталонных изображений, для каждого из которых доступно пять различных текстовых описаний [25].

-

2. MS COCO Captions – набор данных от компании Microsoft [26, 27], состоящий из более 500000 размеченных изображений.

В экспериментальном исследовании использовались несколько нейросетевых архитектур порождения текстовых описаний изображений. В качестве базовой применялась предварительно обученная модель im2txt (рис. 2) [22], доступная в официальном репозитории TensorFlow.

Кроме того, было обучено несколько архитектур вида (рис. 3). Модель Flickr8k , состоящая из CNN VGG16 [19] и LSTM, была обучена на наборе данных Flickr8k . Кроме того, для обучения применялся набор данных Google’s Conceptual Captions (CC) [28], состоящий из трех миллионов ссылок на картинки совместно с их текстовыми аннотациями, автоматически собранных из разных источников в Интернете, а не размеченных вручную. В настоящей работе с использованием этого набора данных было обучено две модели ( CC MobileNet и CC Inception ), отличающиеся видом CNN, использовавшейся для извлечения характерных признаков изображения: MobileNet v1 [7] и InceptionV3 [6] соответственно.

Все модели были реализованы средствами языка Python и библиотек Keras и TensorFlow. Их обучение проходило в течение 30 эпох на сервере 64-bit CPU AMD Ryzen Threadripper 1920X 12-Core, 64GB RAM, оснащенном тремя GPU GeForce GTX 1080Ti.

В табл. 1 указаны среднее время преобразования одного изображения в текст на ноутбуке Lenovo T480 Core i5-8350 CPU, 64-разрядной операционной системе Windows 10, 16GB RAM. Кроме того, в этой же таблице приведен размер моделей CNN и LSTM. Здесь и далее лучшие результаты выделены полужирным шрифтом.

Табл. 1. Среднее время создания аннотаций

|

Модель |

Время, с |

Размер CNN, Мбайт |

Размер остальной части модели, Мбайт |

|

Flickr8k |

6,03 |

528 |

166 |

|

Im2txt |

1,19 |

90 |

142 |

|

CC MobileNet |

1,67 |

53 |

257 |

|

CC Inception |

3,09 |

90 |

259 |

Наиболее быстрыми архитектурами оказались CC MobileNet и Im2txt. В основу CC MobileNet заложена легковесная и вычислительно эффективная сверточная сеть MobileNet. Размер модели и скорость выполнения операций накладывает существенное ограничение на внедрение архитектуры Flickr8k из-за существенных затрат, связанных с использованием сети VGG16.

Табл. 2. Оценки качества «жадного» алгоритма порождения текстовых описаний для тестового набора Flickr8k

|

Метрика |

Flickr 8k |

im2txt |

CC MobileNet |

CC Inception |

|

BLEU-1 |

0,548 |

0,433 |

0,334 |

0,348 |

|

BLEU-2 |

0,294 |

0,187 |

0,110 |

0,118 |

|

BLEU-3 |

0,197 |

0,118 |

0,041 |

0,039 |

|

METEOR |

0,233 |

0,201 |

0,197 |

0,199 |

|

ROUGE-L |

0,358 |

0,327 |

0,302 |

0,305 |

|

CIDEr |

0,721 |

0,682 |

0,653 |

0,662 |

Оценка качества работы моделей выполнялась с помощью метрик Corpus BLEU-n [29], METEOR [30], ROUNGE-L [30] и CIDEr [31]. В табл. 2 представлены результаты оценки точности порождения описаний на основе «жадного» алгоритма (3) для тестовой выборки набора данных Flickr8k. Результаты метода Beam Search приведены в табл. 3.

Здесь модель Flickr8k продемонстрировала наилучшие результаты по каждой из метрик. Эта сеть была обучена на тренировочной выборке Flickr8k, поэтому словарь модели содержит слова, близкие к размеченным описаниям в тестовом наборе данных. Обученные на других наборах данных модели также показали достаточно высокую точность. Например, разница между CC MobileNet и CC Inception по метрике BLEU-1 составила всего 1 %, но первая архитектура показала лучшие результаты по скорости генерирования текста (табл. 1).

В табл. 4 и 5 приведены результаты генерирования аннотаций для тестового набора данных MS COCO Captions с использованием «жадного» алгоритма (3) и алгоритмом Beam Search соответственно.

Табл. 3. Оценки качества алгоритма Beam Search порождения текстовых описаний для тестового набора Flickr8k

|

Метрика |

Flickr 8k |

im2t xt |

CC MobileNet |

CC Inception |

|

B = |

3 |

|||

|

BLEU-1 |

0,542 |

0,442 |

0,338 |

0,33 |

|

BLEU-2 |

0,268 |

0,189 |

0,116 |

0,122 |

|

BLEU-3 |

0,183 |

0,120 |

0,139 |

0,038 |

|

METEOR |

0,145 |

0,192 |

0,132 |

0,139 |

|

ROUGE-L |

0,354 |

0,321 |

0,317 |

0,303 |

|

CIDEr |

0,695 |

0,591 |

0,584 |

0,592 |

|

B =5 |

||||

|

BLEU-1 |

0,531 |

0,343 |

0,296 |

0,315 |

|

BLEU-2 |

0,252 |

0,147 |

0,102 |

0,119 |

|

BLEU-3 |

0,171 |

0,058 |

0,036 |

0,04 |

|

METEOR |

0,137 |

0,132 |

0,129 |

0,135 |

|

ROUGE-L |

0,308 |

0,107 |

0,199 |

0,201 |

|

CIDEr |

0,644 |

0,479 |

0,481 |

0,484 |

Здесь метод Beam Search продемонстрировал небольшое увеличение точности для моделей CC MobileNet и CC Inception. Например, поиск трех наиболее вероятных предложений на 0,2% точнее, чем поиск по максимальной вероятности.

Табл. 4. Оценки качества «жадного» алгоритма порождения текстовых описаний для тестового набора MS COCO Captions

|

Метрика |

Flickr 8k |

im2txt |

CC MobileNet |

CC Inception |

|

BLEU-1 |

0,39 |

0,724 |

0,37 |

0,383 |

|

BLEU-2 |

0,117 |

0,557 |

0,214 |

0,229 |

|

BLEU-3 |

0,01 |

0,413 |

0,148 |

0,159 |

|

METEOR |

0,165 |

0,252 |

0,185 |

0,19 |

|

ROUGE-L |

0,258 |

0,535 |

0,312 |

0,32 |

|

CIDEr |

0,314 |

0,513 |

0,347 |

0,377 |

Табл. 5. Оценка качества алгоритма Beam Search порождения текстовых описаний для тестового набора MS COCO Captions

|

Метрика |

Flick r 8k |

im2txt |

CC MobileNet |

CC Inception |

|

B =3 |

||||

|

BLEU-1 |

0,315 |

0,708 |

0,37 |

0,388 |

|

BLEU-2 |

0,215 |

0,541 |

0,214 |

0,229 |

|

BLEU-3 |

0,116 |

0,405 |

0,293 |

0,257 |

|

METEOR |

0,309 |

0,253 |

0,384 |

0,391 |

|

ROUGE-L |

0,25 |

0,527 |

0,3 |

0,313 |

|

CIDEr |

0,214 |

0,523 |

0,244 |

0,271 |

|

B =5 |

||||

|

BLEU-1 |

0,287 |

0,701 |

0,375 |

0,392 |

|

BLEU-2 |

0,116 |

0,536 |

0,218 |

0,23 |

|

BLEU-3 |

0,01 |

0,39 |

0,152 |

0,158 |

|

METEOR |

0,15 |

0,251 |

0,186 |

0,192 |

|

ROUGE-L |

0,236 |

0,514 |

0,301 |

0,316 |

|

CIDEr |

0,312 |

0,517 |

0,345 |

0,371 |

Худшее качество порождения текстовых описаний соответствует модели Flickr8k. Также заметно увеличение точности по каждой из метрик для модели im2txt, которая была обучена на подмножестве MS

COCO Captions. Разница в 3 % по метрике BLEU-1 с результатами из табл. 3 говорит о том, что эта модель хорошо обучена на словаре из своего набора данных, но значительно хуже работает с изображениями из других предметных областей. Наконец, модели CC MobileNet и CC Inception показали стабильные результаты, поэтому их применение на практике может считаться наиболее приемлемым. Более глубокая сеть Inception ожидаемо оказалась лучше на 0,5– 1 % большинства моделей по каждой из метрик качества.

5. Результаты тестирования алгоритмов. Предпочтения пользователя

Для тестирования качества оценивания пользовательских предпочтений был собран собственный набор данных User Preferences Dataset (User Dataset) , состоящий из десяти категорий интересов некоторых пользователей, а именно: природа, спорт, музыка, театр, мода, собаки, кошки, путешествия, еда. Для каждой категории интереса более 1000 изображений были загружены вручную или взяты из известных наборов данных, принадлежащих целевой тематике. С помощью этого набора данных проводилось сравнение описанных ранее алгоритмов поиска ключевых слов (1), LDA и API Watson. На вход алгоритмов поиска ключевых слов (1) и LDA подаются векторные представления всех слов в текстовых описаниях, для которых удалены стоп-слова и выполнен стемминг [33]. На вход Watson API подавался обычный текст, использовался метод NaturalLanguageUn-derstandingV1, который возвращает ответ на запрос и сохраняет полученные оценки в формате JSON. Алгоритм LDA возвращает вероятности близких слов, принадлежащих потенциальной теме. Он был обучен на 80% сформированных описаний для набора данных User Dataset по каждой из моделей, поэтому для LDA далее представлены результаты обработки аннотаций из оставшейся выборки.

Использовались описания, сформированные с помощью «жадного» алгоритма, максимизирующего оценки апостериорных вероятностей слова в последовательности (3), который, как показано в предыдущем параграфе, практически не уступает по точности методу Beam Search, но при этом получает текстовое описание намного быстрее. В табл. 6 приведены примеры текстовых описаний, порожденных использовавшимися в эксперименте моделями, на вход которых поступило изображение на рис. 4.

Табл. 7 и 8 отражают предпочтения по нескольким категориям, выявленные моделями im2txt и CC Mo-bileNet соответственно.

Согласно приведенным табл. 7 и 8, лучшим из рассматриваемых методов определения предпочтений оказался сторонний функционал, предоставленный Watson API. Алгоритм поиска ключевых слов также достаточно точно определил интересы пользователей для текстов, сформированных сетями обеими моде- лями. Наиболее достоверные результаты получаются с использованием модели, обученной на большом наборе данных Google’s Conceptional Captions (CC MobileNet). В то же время качество извлекаемых с помощью LDA тем-предпочтений оказалось не удовлетворительным.

Рис. 4. Примеры изображений с пользовательскими предпочтениями

Табл. 6. Аннотации, полученные для изображения (рис. 4)

|

Модель |

Порожденный текст |

|

Flickr8k |

a dog is on the street |

|

Im2txt |

a dog on a leash standing next to a bicycle |

|

CC MobileNet |

dog on the street in the city |

|

CC Inception |

person and his dog on the street |

Табл. 7. Примеры предпочтений, извлеченных для модели im2txt

|

Пред-почтение |

Ключевые слова |

LDA |

Watson API |

|

nature |

• Mountain • Background |

• Mountain • Background • Forest • Cloud • person |

/sports/boat racing (score: 0.99) |

|

sport |

• play • tennis |

|

/sports/tennis (score: 0.99) /sports/skateboard ing (score: 0.96) |

|

food |

• plate • food |

• food • cake • cook • tabl • view |

|

Для того, чтобы количественно оценить точность работы предлагаемых алгоритмов, было решено обучить классификатор ближайшего соседа. Для простоты предполагалось, что рассматриваемый пользова- тель интересуется только одной конкретной областью, поэтому в качестве решения выбирался только один класс. Общая выборка набора данных User Dataset была разбита на обучающее и тестовое множества в соотношении 90 / 10% для каждого класса предпочтений. Далее согласно предлагаемому подходу (рис. 1) каждая фотография преобразовывалась в текст. Все слова в получившихся аннотациях кодировались с помощью Word2vec [32] и подавались на вход методу ближайшего соседа. Оценки точности классификации предпочтений представлены в табл. 9.

Табл. 8. Примеры предпочтений, извлеченных для модели CC MobileNet

|

Пред-почтение |

Ключевые слова |

LDA |

Watson API |

|

travel |

• View • Beach |

|

s/air trav-el/airplanes (score: 0.73)

|

|

food |

• Food • Recipe |

|

(score: 0.94) |

|

car |

• Automobi le • Model |

|

(score: 0.99)

|

Табл. 9. Точность (%) классификации предпочтений

|

Модель |

Ключевые слова |

LDA |

Watson API |

|

Flickr8k |

81,032 |

77,963 |

83,902 |

|

Im2txt |

87,941 |

78,177 |

89,001 |

|

CC MobileNet |

88,435 |

79,362 |

89,723 |

|

CC Inception |

88,501 |

79,668 |

89,754 |

Здесь наилучшее качество определения предпочтений достигается с помощью суммаризации текстов из Watson API, который оказался на 1– 2% точнее остальных алгоритмов. Худшие результаты показал алгоритм LDA, который в среднем оказался на 8% менее точным, чем другие методы. Описания, сгенерированные с помощью CC MobileNet и CC Inception, классифицируются на 1– 7% точнее по сравнению с остальными нейролингвистическими моделями.

Заключение

В настоящей работе предложен новый подход (рис. 1) к решению задачи определения предпочтений пользователя по его фотоальбому, основанный на применении методов автоматического порождения текстовых описаний изображений. Проведено экспериментальное исследование нескольких нейросетевых методов автоматического порождения текстовых описаний, результаты которого показали преимущества модели (рис. 3), обученной на основе набора данных Google’s Conceptional Captions. По результатам исследования методов классификации предпочтений на основе полученных текстовых описаний, наилучшие методы поиска ключевых слов (1) и сервис IBM Watson оказались намного точнее традиционного для подобных задач метода LDA (табл. 9).

В то же время следует отметить необходимость проведения ряда дополнительных исследований. В частности, получаемые текстовые аннотации (табл. 6) существенно обедняют представления изображений по сравнению с традиционными характерными признаками, извлекаемыми с помощью глубокой CNN. Поэтому в будущем целесообразно исследовать применение ансамблей моделей, состоящих из традиционных классификаторов и предлагаемого подхода (рис. 1). Кроме того, необходимо исследовать более сложные методы обработки текстов для достижения точности классификации предпочтений, сравнимой с точностью коммерческого сервиса IBM Watson API. Наконец, необходимо рассмотреть альтернативы реализованному в статье простейшему способу агрегации всех описаний, объединяемых в единый текст для последующего извлечения предпочтений.

Статья подготовлена в результате проведения исследования (№ 19-04-004) в рамках Программы «Научный фонд Национального исследовательского университета «Высшая школа экономики» (НИУ ВШЭ)» в 2019 г. и в рамках государственной поддержки ведущих университетов Российской Федерации "5-100".

Список литературы Извлечение предпочтений пользователя на основе методов автоматического порождения текстовых описаний изображений фотоальбома

- Singhal, A. Use of deep learning in modern recommendation system: A summary of recent works [Electronical Resource] / A. Singhal, P. Sinha, R. Pant // arXiv preprint arXiv:1712.07525. - 2017. - URL: https://arxiv.org/abs/1712.07525 (request date 4.12.2019).

- Demochkin, K.V. Visual product recommendation using neural aggregation network and context gating / K.V. Demochkin, A.V. Savchenko // Journal of Physics: Conference Series. - 2019. - Vol. 1368, Issue 3. - 032016.

- Kharchevnikova, A.S. Neural networks in video-based age and gender recognition on mobile platforms / A.S. Kharchevnikova, A.V. Savchenko // Optical Memory and Neural Networks (Information Optics). - 2018. - Vol. 27, Issue 4. - P. 246-259.

- Grechikhin, I. User modeling on mobile device based on facial clustering and object detection in photos and videos / I. Grechikhin, A.V. Savchenko. - In: Proceedings of the iberian conference on pattern recognition and image analysis (IbPRIA) / ed. by A. Morales, J. Fierrez, J. Sánchez, B. Ribeiro. - Cham: Springer, 2019. - P. 429-440.

- Rassadin, A.G. Scene recognition in user preference prediction based on classification of deep embeddings and object detection / A.G. Rassadin, A.V. Savchenko. - In: Proceedings of international symposium on neural networks (ISNN) / ed. by H. Lu, [et al.]. - Springer Nature Switzerland AG, 2019. - P. 422-430.

- Szegedy, C. Going deeper with convolutions / C. Szegedy // Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). - 2015. - P. 1-9.

- Howard, A.G. MobileNets: Efficient convolutional neural networks for mobile vision applications [Electronical Resource] / A.G. Howard, M. Zhu, B Chen, D. Kalenichenko, W. Wang, T. Weyand, M. Andreetto, H. Adam. - arXiv preprint arXiv:1704.04861. - 2017. - URL: https://arxiv.org/abs/1704.04861 (request date 4.12.2019).

- Wang, R. Covariance discriminative learning: A natural and efficient approach to image set classification / R. Wang, H. Guo, L.S. Davis, Q. Dai // IEEE Conference on Computer Vision and Pattern Recognition. - 2012. - P. 2496-2503.

- Wang, L. Transferring deep object and scene representations for event recognition in still images / L. Wang, Z. Wang, Y. Qiao, L. Van Gool // International Journal of Computer Vision. - 2018. - Vol. 126, Issues 2-4. - P. 390-409.

- Xiong, Y. Recognize complex events from static images by fusing deep channels / Y. Xiong, K. Zhu, D. Lin, X. Tang // Proceedings of the International Conference on Computer Vision and Pattern Recognition (CVPR). - 2015. - P. 1600-1609.

- Фурман, Я.А. Точечные поля и групповые объекты / Я.А. Фурман, А.А. Роженцов, Р.Г. Хафизов, Д.Г. Хафизов, А.В. Кревецкий, Р.В. Ерусланов; под ред. Я.А. Фурмана. - М: Физматлит, 2014. - 440 с. - 978-5-9221-1604-6.

- ISBN: 9785922116046

- Vorontsov, K. Additive regularization of topic models / K. Vorontsov, A. Potapenko // Machine Learning. - 2015. - Vol. 101. - P. 303-323.

- Rosen-Zvi, M. The author-topic model for authors and documents / M. Rosen-Zvi // Proceedings of the 20th Conference on Uncertainty in Artificial Intelligence. - 2004. - P. 487-494.

- Blei, D.M. Latent Dirichlet allocation / D.M. Blei, A.Y. Ng, M.I. Jordan // Journal of Machine Learning Research. - 2003. - Vol. 3. - P. 993-1022.

- Ferrucci, D.A. Introduction to "this is Watson" / D.A. Ferrucci // IBM Journal of Research and Development. - 2012. - Vol. 56, Issue 3.4. - P. 1:1-1:15.

- Lally, A. Question analysis: How Watson reads a clue / A. Lally, J. Prager, M. McCord, B. Boguraev, S. Patwardhan, J. Chu-Carroll // IBM Journal of Research and Development. - 2012. - Vol. 56, Issue 3.4. - P. 2:1-2:14.

- Fan, J. Automatic knowledge extraction from documents / J. Fan, A. Kalyanpur, D. Gondek, D. Ferrucci // IBM Journal of Research and Development. - 2012. - Vol. 56, Issue 3.4. - P. 5:1-5:10.

- Савченко, А.В. Тригонометрическая система функций в проекционных оценках плотности вероятности нейросетевых признаков изображений / А.В. Савченко // Компьютерная оптика. - 2018. - Т. 42, № 1. - С. 149-158. -

- DOI: 10.18287/2412-6179-2018-42-1-149-158

- Simonyan, K. Very deep convolutional networks for large-scale image recognition [Electronical Resource] / K. Simonyan, A. Zisserman. - arXiv preprint arXiv:1409.1556. - 2014. - URL: https://arxiv.org/abs/1409.1556 (request date 4.12.2019).

- Tanti, M. Where to put the image in an image caption generator / M. Tanti, A. Gatt, K.P. Camilleri // Natural Language Engineering. - 2018. - Vol. 24, Issue 3. - P. 467-489.

- Wang, M. A parallel-fusion RNN-LSTM architecture for image caption generation / M. Wang, L. Song, X. Yang, C. Luo // Proceedings of the IEEE International Conference on Image Processing (ICIP). - 2016. - P. 4448-4452.

- Vinyals, O. Show and tell: A neural image caption generator / O. Vinyals, A. Toshev, S. Bengio, D. Erhan // Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). - 2015. - P. 3156-3164.

- Kiros, R. Multimodal neural language models / R. Kiros, R. Salakhutdinov, R. Zemel // Proceedings of the International Conference on Machine Learning (ICML). - 2014. - P. 595-603.

- Vijayakumar, A.K. Diverse beam search: Decoding diverse solutions from neural sequence models [Electronical Resource] / A.K. Vijayakumar, M. Cogswell, R. Selvaraju, Q. Sun, S. Lee, D. Crandall, D. Batra. - arXiv preprint arXiv:1610.02424. - 2016. - URL: https://arxiv.org/abs/1610.02424 (request date 4.12.2019).

- Bernardi, R. Automatic description generation from images: A survey of models, datasets, and evaluation measures / R. Bernardi, R. Cakici, D. Elliott, A. Erdem, E. Erdem, N. Ikizler-Cinbis, B. Plank // Journal of Artificial Intelligence Research. - 2016. - Vol. 55. - P. 409-442.

- Lin, T.Y. Microsoft COCO: Common objects in context / T.Y. Lin, M. Maire, S. Belongie, J. Hays, P. Perona, D. Ramanan, C. Zitnick // Proceedings of the European conference on computer vision (ECCV). - 2014. - P. 740-755.

- Chen, X. Microsoft COCO captions: Data collection and evaluation server [Electronical Resource] / X. Chen, H. Fang, T. Lin, R. Vedantam, S. Gupta, P. Dollar. - arXiv preprint arXiv:1504.00325. - 2015. - URL: https://arxiv.org/abs/1504.00325 (request date 4.12.2019).

- Sharma, P. Conceptual captions: A cleaned, hypernymed, image alt-text dataset for automatic image captioning / P. Sharma, N. Ding, S. Goodman, R. Soricut // Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (ACL). - 2018. - Vol. 1. - P. 2556-2565.

- Papineni, K. BLEU: a method for automatic evaluation of machine translation / K. Papineni, S. Roukos, T. Ward, W.J. Zhu // Proceedings of the 40th annual meeting on association for computational linguistics (ACL). - 2002. - P. 311-318.

- Denkowski, M. Meteor universal: Language specific translation evaluation for any target language / M. Denkowski, A. Lavie // Proceedings of the Ninth Workshop on Statistical Machine Translation. - 2014. - P. 376-380.

- Vedantam, R. CIDEr: Consensus-based image description evaluation / R. Vedantam, C.L. Zitnick, D. Parikh // Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). - 2015. - P. 4566-4575.

- Goldberg, Y. Word2Vec explained: Deriving Mikolov et al.'s negative-sampling word-embedding method [Electronical Resource] / Y. Goldberg, O. Levy. - arXiv preprint arXiv:1402.3722. - 2014. - URL: https://arxiv.org/abs/1402.3722 (request date 4.12.2019).

- Manning, C.D. Foundations of statistical natural language processing / C.D. Manning, H. Schütze. - MIT Press, 1999.

- Харчевникова, А.С. Свёрточные нейронные сети в задаче распознавания пола и возраста по видеоизображению / А.С. Харчевникова, А.В. Савченко. - В кн.: Сборник трудов IV Международной конференции и молодёжной школы "Информационные технологии и нанотехнологии" (ИТНТ 2018). - Самара: Предприятие "Новая техника", 2018. - С. 916-924.