Классификация исторических документов по политическому признаку с помощью BERT: взаимодействие LLM с историческим доменом

Автор: Галушко И.Н.

Журнал: Вестник Пермского университета. История @histvestnik

Рубрика: Digital humanities: сквозь алгоритмы к знаниям

Статья в выпуске: 2 (69), 2025 года.

Бесплатный доступ

На современном этапе изучения отечественной истории становятся особенно актуальны дискуссии о работе с большими массивами документов по истории конца XIX – начала XXI в. Сегодня активно идет процесс оцифровки архивных коллекций, но в большинстве случаев созданный корпус просто выставляется на сайт, и многие годы с ним никто не работает, так как нередко мы сталкиваемся с трудностями обработки всего массива материалов при обращении к фондам крупного социального института. Оцифрованные фонды могут содержать сотни тысяч листов делопроизводственной документации. Ограниченность временных возможностей одного человека не позволяет даже на уровне беглого чтения охватить все имеющиеся документы. Данную проблему хотя бы частично может решить применение LLM (large language models) для аннотирования или оптимизации текстового поиска. Однако на текущем этапе развития архивного дела специалисты только начинают работать с методами обработки естественного языка. И основной запрос профессионального сообщества состоит в изучении специфики работы моделей искусственного интеллекта и машинного обучения с текстами исторического домена. Данная работа представляет собой предварительное исследование взаимодействия современных LLM с историческими текстами. Для анализа были выбраны одна из наиболее популярных моделей – BERT – и одна из наиболее распространенных NLP-задач – классификация. Важной частью исследования стал анализ весов внимания модели при решении задачи классификации текстов и заполнения пропусков в предложениях. При таком подходе у нас появилась возможность проанализировать, как модель использует семантический контекст для принятия решения.

Классификация текстов, политическая история, искусственный интеллект, анализ механизмов внимания, машинное обучение, BERT, NLP

Короткий адрес: https://sciup.org/147250818

IDR: 147250818 | УДК: 930.23 | DOI: 10.17072/2219-3111-2025-2-147-158

Текст научной статьи Классификация исторических документов по политическому признаку с помощью BERT: взаимодействие LLM с историческим доменом

Сегодня в исследовательском сообществе активно развивается дискуссия о принципах работы с большими коллекциями документов по истории конца XIX – начала XXI в. [ Володин , 2020]. Активно идет процесс оцифровки имеющихся коллекций, но нередко созданный корпус оказывается просто выставленным на сайт, и многие годы с ним никто не работает. Дело в том, что, изучая один аспект (например, экономические отношения СССР со странами Восточного блока), историк сталкивается с трудностями при обращении к материалам крупного института общесоюзного значения (например, к многочисленным архивным фондам Госплана СССР в

Российском государственном архиве экономики (РГАЭ)). Материалы фондов могут содержать сотни тысяч листов делопроизводственной документации. Ограниченность времени одного исследователя не позволяет даже на уровне беглого чтения охватить все имеющиеся документы. Данную проблему хотя бы частично могло бы решить качественное аннотирование, но для этого требуются большие человеческие ресурсы десятков сотрудников архива, и на данный момент во многих архивах такая работа ведется ограниченно. Здесь естественно возникает идея об использовании генеративных нейронных сетей для автоматической генерации аннотаций к архивным коллекциям: к какому разделу истории относится данный материал? какие entities там упоминаются? к какому блоку современных проблематик можно отнести данный доку-мент/данную коллекцию? Однако на текущем этапе развития архивного дела специалисты только начинают работать с методами обработки естественного языка. Профессиональное сообщество проявляет повышенный интерес к исследованию особенностей обработки исторических текстов методами искусственного интеллекта [ Юмашева , 2022]. Настоящее исследование посвящено анализу взаимодействия крупных языковых моделей (LLM) с текстами исторического домена, что представляет особую сложность из-за отличий в речевой стилистике и специфического временного контекста. В качестве объекта исследования была выбрана популярная модель BERT, демонстрирующая высокие результаты в обработке естественного языка. Для тестирования ее возможностей была взята классическая NLP-задача – классификация текстов, позволяющая оценить способность модели использовать исторический контекст для оптимизации своего вывода.

На данный момент единственным апробированным в исторической науке NLP-методом для предварительной оценки информационного потенциала коллекции исторических источников является тематическое моделирование. Так, в работе Topic Modeling in Historical Newspapers [ Yang , Torget , Mihalcea , 2011] был предложен концепт использования LDA для первичной проверки, какой теме посвящены конкретные номера коллекции техасских газет за 1829–2008 гг. Все это было представлено в виде общей методики облегчения рутинного труда историка, который теперь мог не вчитываться в каждый номер, а отобрать лишь те документы, темы которых соответствуют его исследовательским задачам. Большие языковые модели в задачах исторического информационного поиска на данный момент не использовались.

Фокус данной работы сосредоточен на прикладном аспекте использования языковых моделей для информационного поиска в коллекции исторических документов. Классификация в данном исследовании рассматривается как потенциальное решение для оптимизации процесса отбора источников на этапе подготовки исторического исследования: вполне возможно, что обученные языковые модели смогут взять на себя черновую работу по поиску документов, относящихся к узкоспециализированной теме. Тогда историку будет оставлена содержательная работа, связанная с источниковедческой критикой и анализом текста в глобальном историческом контексте. Кроме того, само по себе обращение к исследованию специфики взаимодействия языковых моделей с текстами исторического домена представляется интересным и продуктивным: насколько модель, обученная на «Википедии», интернет-контенте и текстах СМИ, окажется способна решать задачи обработки естественного языка применительно к историческим текстам?

Для классификации были отобраны документы эпохи революции 1917 г. и Гражданской войны в России, так как по данному периоду, во-первых, существует большое количество распознанных публикаций, доступных на сайте «Электронной библиотеки исторических документов»; во-вторых, у такой коллекции есть очевидный содержательный критерий для классификации – политическая принадлежность документа, так как рассматриваемый период отличался существенной политической дифференциацией действующих в стране социальных сил. Мы разделили документы на классы (табл. 1).

Таблица 1

Распределение текстов по классам

|

Группа текстов |

Тэг класса |

Публикации |

|

Большевики |

Bolsheviki |

|

|

Меньшевики |

Mensheviki |

|

|

Левые эсеры |

Left_SRs |

Партия левых социалистов-революционеров. Документы и материалы. 1917‒1925 гг.: в 3 т. М.: РОССПЭН, 2000. |

|

Кадеты |

Kadets |

Съезды и конференции конституционно-демократической партии. 1905‒1920 гг.: в 3 т. М.: РОССПЭН, 2000. |

|

Монархисты |

Rights |

Правые партии. 1905‒1917 гг. Документы и материалы: в 2 т. Т. 2. 1911‒1917 гг. М.: РОССПЭН, 1998. 816 с. |

|

Белая армия |

White_army |

Журналы заседаний Особого совещания при Главнокомандующем Вооруженными Силами на Юге России А. И. Деникине. Сентябрь 1918-го ‒ декабрь 1919 года. М.: РОССПЭН, 2008. 1003 с. |

|

Рабочая оппозиция большевикам |

Work_oppose |

|

|

Дворянское собрание |

Nobles |

Объединенное дворянство. Съезды уполномоченных губернских дворянских обществ. 1906‒1916 гг.: в 3 т. М.: РОССПЭН, 2001. |

Данные

Как было сказано выше, в качестве основного источника данных были использованы материалы «Электронной библиотеки исторических документов» Российского исторического общества. Данная коллекция содержит распознанные версии документов, находящихся на хранении в 1592 архивах. Цифра масштабная, но важно уточнить, что многие из представленных архивов – это личные собрания или же небольшие подборки делопроизводственной документации отдельного предприятия (от 1 до 300 ед. хранения). Здесь также представлены и крупные государственные архивы, вроде РГАЭ (2664 ед. хранения). Для классификации нами были отобраны документы, тематически относящиеся к революционному 1917 г. и Гражданской войне. Всего – 2423 документа, распределенных на восемь классов. Из текстов были удалены номера, ссылки и указания на архивы, в которых хранятся распознанные документы.

Наиболее интересным представляется класс «Рабочая оппозиция большевикам». В эту группу вошли документы, отражающие позицию рабочих организаций, выступивших против политики большевиков в конце 1917–1918 гг. С точки зрения лексики у данной группы документов есть много пересечений как с самими большевиками, так и с меньшевиками и эсерами, так как авторами этих текстов зачастую выступали образованные рабочие, тяготевшие к социалистическим идеям, но при этом не принявшие последствия большевистских преобразований (жалобы на безработицу, насилие, цензуру). Мы предполагаем, что для этого класса мы должны получить сравнительно более низкое качество модели, так как отделить тексты рабочей оппозиции от меньшевиков гораздо сложнее, и это уже экспертная работа (если сравнивать с сопоставлением текстов белого движения и левых эсеров, тут проходит очевидный лексический водораздел).

Еще одной «подставной» для модели категорией выступает класс Noble (Дворянское собрание), в который были включены тексты дворянских собраний, относящиеся к периоду до 1914 г. Мы решили экспериментально добавить в модель тексты другого исторического периода, пересекающиеся по лексике с текстами монархических партий для проверки способности модели отличать их.

Перед тем как приступить к разбору процесса обучения и результатов классификации, предлагаем взглянуть на выгрузку предсказаний еще не обученной модели для анализа ее способности взаимодействовать с историческим контекстом. В одной из недавних статей [ Petroni , Rocktäschel , Lewis et al., 2019], посвященной изучению принципов работы больших языковых моделей, было выдвинуто предположение, что LLM можно сравнить с базами данных, поскольку пространство весов модели хранит информацию не только о структуре языка, но и о семантических связях между словами. Для характеристики «знаний» модели о рассматриваемом периоде мы используем метод Fill-mask. Поскольку одна из базовых задач обучения BERT-модели – это предсказание пропущенного в предложении слова [ Jacob , Chang , Lee , Toutanova , 2019], мы можем воспользоваться методом заполнения пропуска ([Mask]) для получения набора наиболее вероятных слов, которые могли бы заполнить эти пропуски в соответствии с семантическим контекстом. В качестве основной модели был выбран классический BERT, дообученный на русскоязычной части «Википедии». Для исследования классификационного потенциала LLM для исторических источников мы приняли решение взять одну из наиболее распространенных моделей. На вход подавались тексты лишь с одним пропуском, поэтому модель видела весь контекст.

Рассмотрим в деталях процесс восстановления предложений на основе контекста с помощью модели BERT (примеры 1-4; табл. 2-5).

Пример № 1

Таблица 2

Восстановление исторического текста с помощью модели BERT. Пример № 1

|

Номер пропуске в тексте |

Слово в оригинальном документе |

Предсказывания модели с весами вероятности |

|

[MASK1] |

национальных |

национальных (0.16) ; еврейских (0.11) ; народных (0.07) ; антисемитских (0.07) ; религиозных (0.04) |

|

[MASK2] |

советской |

советской (0.19) ; новой (0.14) ; царской (0.11) ; Советской (0.08) ; центральной (0.03) |

|

[MASK3] |

антиеврейских |

массовых (0.17) ; городских (0.12) ; революционных (0.07) ; национальных (0.02) ; политических (0.01) |

|

[MASK4] |

революции |

народа (0.28) ; прошлого (0.11) ; революция (0.05) ; СССР (0.04) ; России (0.03) |

|

[MASK5] |

большевистская |

коммунистическая (0.3) ; политическая (0.07) ; Коммунистическая (0.05) ; правящая (0.05) ; революционная (0.04) |

Пример № 2

Передайте VIII съезду уполномоченных [MASK1] обществ Мою сердечную благодарность за их молитвы, благопожелания и выраженные Государыням [MASK2] , Мне и Наследнику [MASK3] чувства; уверен, что верное заветам старины Русское дворянство и впредь всегда будет служить опорой Престола в деле мирного развития великой нашей России [Объединенное дворянство…, 2001, с. 301].

Таблица 3

Восстановление исторического текста с помощью модели BERT. Пример № 2

|

Номер пропуска в тексте |

Слово в оригинальном документе |

Предсказывания модели с весами вероятности |

|

[MASK1] |

дворянских |

дворянских (0.53) ; акционерных (0.10) ; сельских (0.05) ; русских (0.02) ; вольных (0.02) |

|

[MASK2] |

Императрицам |

Вам (0.34) ; Вас (0.07) ; Мне (0.03) ; Вы (0.03) ; Тебе (0.03) |

|

[MASK3] |

Цесаревичу |

государства (0.11) ; народа (0.09) ; России (0.06) ; общества (0.04) ; Церкви (0.02) |

Пример № 3

Петроградский [MASK1] послал в эти дни к вам, московским [MASK2] , своих делегатов для того, чтобы связать свое движение с вашим, для того чтобы рассказать вам о нуждах и планах петроградских пролетариев, и обратно привезти ваше сочувствие и вашу поддержку. Петроградский пролетариат оказался в чрезвычайно тяжелом положении. Испытавший на себе наиболее остро все последствия дикой [MASK3] политики, потерявший в результате этой политики силу и независимость своих организаций, он, фактически безоружный и беззащитный, столкнулся лицом к лицу с последними бедствиями, надвинувшимися на [MASK4] . Обреченный город начал эвакуироваться. Совет Народных [MASK5] покинул Петроград. Начались расчеты на заводах. Во всех вопросах — эвакуации, [MASK6] , [MASK7] , охраны безопасности населения — рабочий [MASK8] воочию увидел одну разруху, полную дезорганизацию. Перевыборы в [MASK9] фактически были запрещены и оторвавшись совершенно от рабочей массы, эти большевистские канцелярии бездействовали, или сами усиливали дезорганизацию. Деятельность профессиональных союзов, заводских [MASK10] , была извращена и разрушена, кооперативы — оттерты от широкой работы [Рабочее оппозиционное движение…, 2006, с. 54].

Таблица 4

Восстановление исторического текста с помощью модели BERT. Пример № 3

|

Номер пропуска в тексте |

Слово в оригинальном документе |

Предсказывания модели с весами вероятности |

|

[MASK1] |

пролетариат |

Совет (0.74) ; совет (0.16) ; ВРК (0.03) ; комитет (0.01) ; градоначальник (0.01) |

|

[MASK2] |

рабочим |

рабочим (0.20) ; властям (0.1) ; большевикам (0.10) ; людям (0.06) ; городам (0.02) |

|

[MASK3] |

большевистской |

большевистской (0.27) ; революционной (0.07); внутренней (0.04) ; внешней (0.04) ; буржуазной (0.03) |

|

[MASK4] |

Петроград |

Петроград (0.40) ; город (0.06) ; рабочих (0.06) ; Россию (0.06) ; большевиков (0.03) |

|

[MASK5] |

Комиссаров |

Комиссаров (0.97) ; комиссаров (0.02) ; рабочих (0.01) ; депутатов (0.01) ; представителей (0.01) |

|

[MASK6] |

безработицы |

транспорта (0.14) ; торговли (0.05) ; снабжения (0.04) ; труда (0.04) ; отопления (0.04) |

|

[MASK7] |

продовольствия |

труда (0.07) ; мобилизации (0.05) ; забастовки (0.03) ; питания (0.03) ; торговли (0.02) |

|

[MASK8] |

класс |

класс (0.44) ; Совет (0.07) ; народ (0.07) ; Петроград (0.04) ; совет (0.02) |

|

[MASK9] |

Совете |

городах (0.24) ; Петрограде (0.11) ; губернии (0.07) ; Советы (0.07) ; городе (0.05) |

|

[MASK10] |

комитетов |

рабочих (0.25) ; профсоюзов (0.09) ; организаций (0.07) ; комитетов (0.07) ; союзов (0.06) |

Пример № 4

В дополнение утвержденного Главнокомандующим 18 мая [MASK1] года постановления Особого [MASK2] о предоставлении учреждениям гражданского ведомства права [MASK3] по железным дорогам чинов, командируемых по службе, и грузов для надобностей Вооруженных Сил на [MASK4] России по воинским предложениям предоставить указанным учреждениям право [MASK3] по воинским предложениям тех чинов и грузов по водным путям с соблюдением правил, установленных означенным постановлением для перевозок по железным дорогам, с тем чтобы перевозки водой за счет казны по воинским предложениям производились лишь в тех случаях, когда эти перевозки будут обходиться дешевле, чем перевозки между теми же пунктами по железным дорогам, или когда между соответствующими пунктами вовсе нет железных дорог [Журналы заседаний Особого совещания…, 2008, с. 892].

Результаты выгрузки предсказаний модели показывают, что даже базовая модель, обученная на русскоязычных текстах (в первую очередь – на «Википедии») способна угадывать исторический контекст и подбирать оригинальные (пример 1, строка 1; пример 2, строка 1; пример 3, строка 3) или близкие к оригинальным слова (пример 4, строка 3). Также возможна ситуация, в которой модель в целом верно определяет исторический период, к которому относится текст, но ошибается с конкретным годом (пример 4, строка 1). В то же время следует отметить, что ряд достаточно очевидных позиций не был угадан моделью (пример 1, строка 4; пример 3, строка 10). Довольно любопытны случаи, в которых модель предлагает верный вариант, но ставит его не на первые места по вероятности (пример 4, строка 4).

Таблица 5

Восстановление исторического текста с помощью модели BERT. Пример № 4

|

Номер пропуска в тексте |

Слово в оригинальном документе |

Предсказывания модели с весами вероятности |

|

[MASK1] |

1919 |

1916 (0.08) , 1917 (0.07); 1912 (0.06); 1915 (0.05); 1918 (0.04) |

|

[MASK2] |

совещания |

совещания (0.72); отдела (0.04); Комитета (0.03); комитета (0.02); особ (0.01) |

|

[MASK3] |

перевозок |

перевозки (0.66), перевозок (0.25), перевозить (0.02), перевозку (0.01), перевозка (0.01) |

|

[MASK4] |

Юге |

территории (0.35); Юге (0.26); территорию (0.031); юге (0.03); границах (0.08) |

Подводя краткий итог сказанному, хочется отметить, что модель однозначно способна понимать семантику текста и угадывать по ней исторический контекст, однако делает это нестабильно. На фоне рассмотренной выгрузки представляется вполне допустимым, что, решая задачу классификации текстов, модель BERT в процессе обучения будет охватывать значительно больший информационный контекст; операция сравнения текстов будет носить куда более сложный характер, нежели простой подсчет ключевых слов, маркирующих принадлежность текста к каждому из классов. В этом контексте нам представляется интересным сравнить результаты работы модели с другими подходами, основанными на частотном анализе слов (наивный байесовский классификатор), линейной регрессии с использованием эмбеддингов и градиентном бустинге (gradient boosting) на основе деревьев решений.

Сравнение результатов предсказания модели с другими классификаторами

Нами был использован подход дообучения большой языковой модели (fine-tuning) на классификацию текстов доменного датасета. На тренировочную часть было выделено 80 % данных (1938 документов), на тестирование – 20 % (485 документов).

Результаты работы модели на тестовой выборке (документы, которые модель не видела в процессе обучения) представлены в табл. 6. Отдельно отметим, что качество классификации оказалось чуть ниже на группе документов «Рабочая оппозиция большевикам», а эти документы, как мы указывали, по содержанию и лексике очень похожи на документы эсеров и меньшевиков. Мы можем констатировать, что модель действует согласованно с гипотезой, сформулированной на общих знаниях об исторической эпохе.

Таблица 6

Сравнение результатов классификации BERT c альтернативными классификаторами.

F1-score

|

Название класса |

NB |

Logistic Regression |

XGBoost |

BERT-Classifier |

Количество текстов |

|

Bolsheviki |

0.68 |

0.77 |

0.82 |

0.99 |

52 |

|

Mensheviki |

0.76 |

0.67 |

0.73 |

0.94 |

62 |

|

Left_SRs |

0.84 |

0.78 |

0.80 |

0.99 |

70 |

|

Kadets |

0.79 |

0.83 |

0.85 |

0.99 |

37 |

|

Rights |

0.71 |

0.81 |

0.79 |

0.99 |

58 |

|

White_army |

0.83 |

0.86 |

0.86 |

0.96 |

56 |

|

Work_oppose |

0.42 |

0.64 |

0.81 |

0.95 |

42 |

|

Nobles |

0.69 |

0.82 |

0.88 |

0.98 |

108 |

Далее сравним результаты работы модели с альтернативными классификаторами, основанными на принципах классического машинного обучения. Хотя применяемые классификаторы показали в целом неплохую точность классификации, LLM значительно превосходит их. Это позволяет нам рекомендовать использовать именно LLM в задачах классификации текстов, так как современные пакеты для работы с языковыми моделями (например, Transformers [ Wolf , Debut , Sanh et al., 2020]) ориентированы на пользователей, обладающих базовым уровнем программирования, что дает возможность широким кругам исследователей обращаться к рассматриваемым методам. В целом сегодня использование LLM для прикладных задач не выглядит намного сложнее, чем запуск базовых моделей из пакетов для машинного обучения (Scikit-learn).

Анализ весов предсказаний классификатора

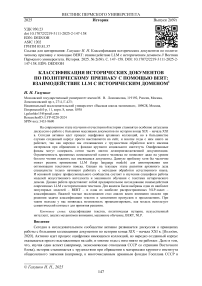

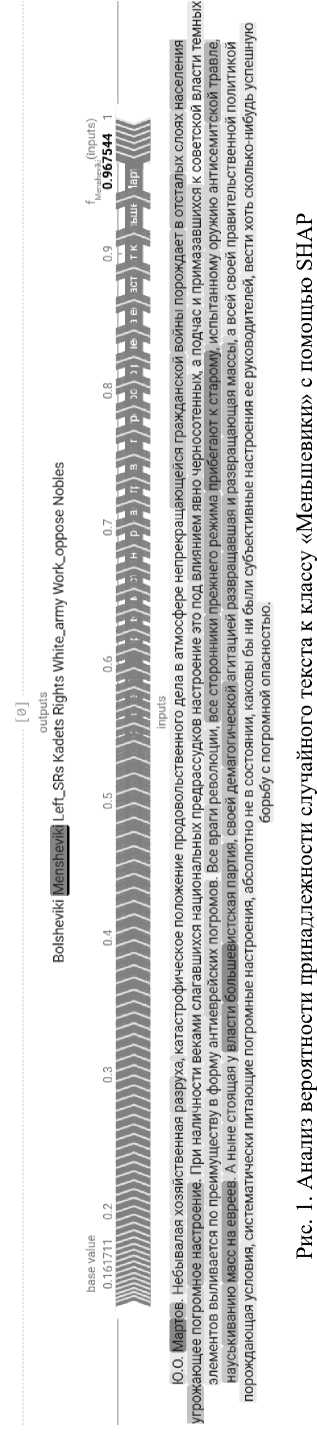

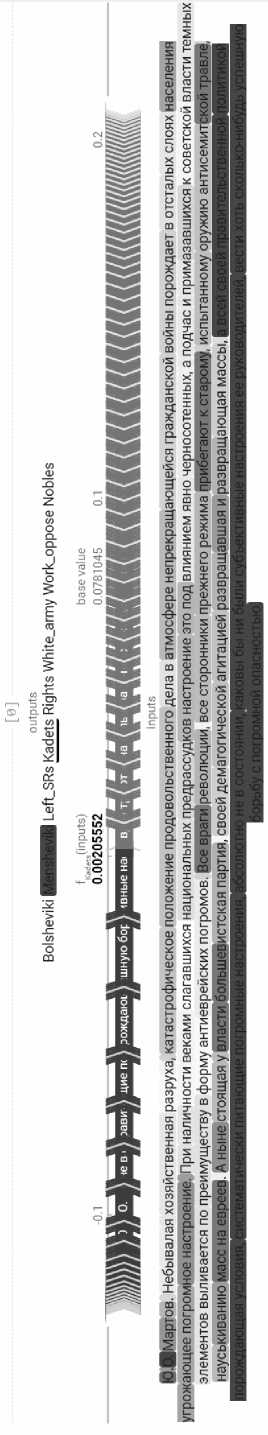

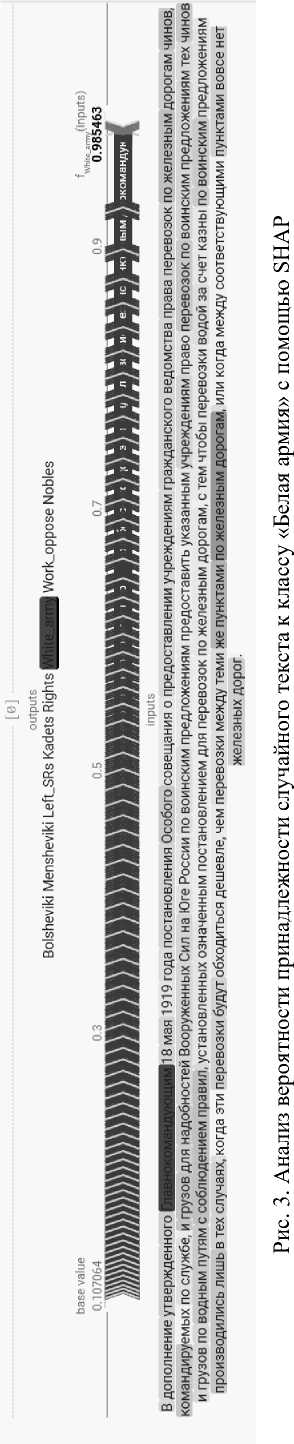

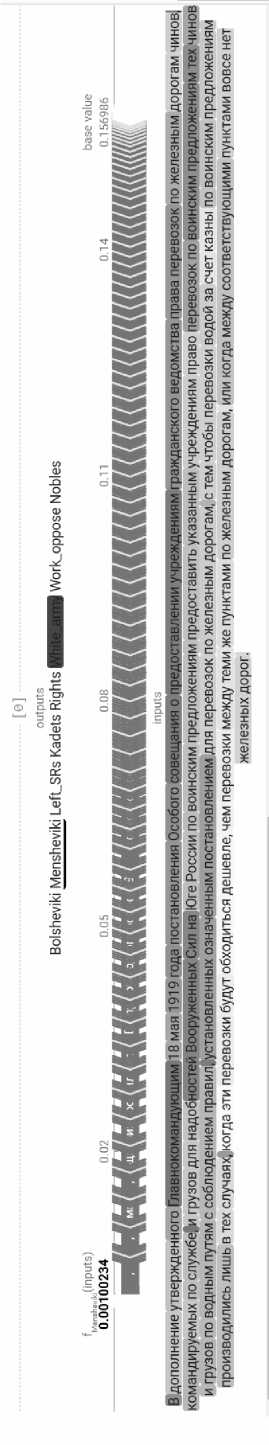

Нейросети давно перестали быть непроницаемым «черным ящиком», как о них периодически высказываются. В действительности исследователи обладают большим набором методов, позволяющих анализировать поведение моделей. Безусловно, часть процесса обучения и работы механизмов внимания все еще остается скрыта. Но сегодня мы можем проверять, насколько корректны зависимости, которые модели приписывают данным. В частности, для этого может использоваться библиотека SHAP [ Lundberg , Scott , Lee , 2017], оценивающая вклад каждого признака в итоговое предсказание модели. В случае с LLM мы можем получить подробную карту вкладов каждого из токенов (слов) в решении модели приписать тексту тот или иной класс. Причем SHAP также дает нам информацию о том, какие слова уменьшают вероятность принадлежности текста к одному из классов, показанных модели на этапе обучения. Так, если мы проанализируем два небольших отрывка из табл. 2 с помощью SHAP (рис. 1), то обнаружим, что наша модель явно согласуется с контекстом рассматриваемой эпохи. Например, предписывая первому тексту класс «Меньшевики», модель обращает особое внимание на сочетание токенов «Март», «ов» (см. рис. 1). Любопытно, что последнее предложение модель относит к классу «Кадеты» (рис. 2). Вероятно, в ходе обучения модель выявила особое значение риторики, связанной с погромами, в кадетских текстах. Слово «главнокомандующий» воспринимается ею как явный маркер класса «Белая армия» (рис. 3), и она занижает вероятность для всех других классов (как, например, для класса «Меньшевики» (рис. 4). Мы привели лишь несколько примеров. Сегодня любой LLM-классификатор может подвергнуться детальному анализу, проверяющему правильность изученных моделью зависимостей.

Выводы

В ходе нашего исследования были подтверждено, что LLM могут успешно использоваться для решения задач классификации исторических текстов по политическому признаку. Представляется, что стратегия информационного поиска, опирающаяся на дообучение языковой модели на небольшой выборке текстов (около 200‒250 единиц), может применяться для оптимизации отбора исторических документов, относящихся к определенной историографической проблеме (в нашем случае – к политической истории революционного 1917 г.). Другим важным результатом исследования мы считаем высокое качество классификации, полученное с помощью классического BERT. Нами были использованы токенайзер, обученный на современных текстах на русском языке, и только первые 512 слов наших текстов в качестве токенов. Вероятно, лексическая близость начала XX в. к современному русскому языку позволяет получать высокое качество классификации даже без специализированной доменной адаптации к историческому периоду на этапе первичного обучения (pre-train). Это может оказаться ценным результатом, поскольку коллекции распознанных исторических документов все еще очень далеки по объему от текстовых массивов, на которых обучаются современные LLM. Другим возможным объяснением высокого качества работы модели может быть изначальное обучение BERT на текстах русскоязычной «Википедии». Интернет-энциклопедия содержит очень подробные статьи по истории революций 1917 г. и Гражданской войны. Если это предположение правдиво, это открывает дальнейшие перспективы изучения специфики влияния источников обучения на качество работы больших языков моделей в рамках сложной доменной адаптации.

Рис. 2. Анализ вероятности принадлежности случайного текста к классу «Кадеты» с помощью SHAP

Рис. 4. Анализ вероятности принадлежности случайного текста к классу «Меньшевики» с помощью SHAP