Классификация образов и ее связь с топологией многообразий динамических систем

Автор: Юдашкин А.А.

Журнал: Известия Самарского научного центра Российской академии наук @izvestiya-ssc

Рубрика: Управление и моделирование в сложных системах

Статья в выпуске: 1 т.3, 2001 года.

Бесплатный доступ

Представлен новый метод построения классифицирующей динамической нейронной сети. Модель образована совокупностью переменных состояния, параметров порядка, каждая из которых отвечает отдельному запомненному прототипу. Переменные связаны посредством матрицы весов, определенной в соответствии с выбранным разбиением всег о множества прототипов на подмножества (классы). Классы могут иметь ненулевые пересечения в том случае, когда один или несколько прототипов одновременно принадлежат различным подмножествам. Классификация сводится к конкуренции во времени между параметрами порядка из разных классов. Процесс рассматривается в пространстве состояний, где каждому подмножеству отвечает притягивающее многообразие определенной топологии.

Короткий адрес: https://sciup.org/148197645

IDR: 148197645

Текст научной статьи Классификация образов и ее связь с топологией многообразий динамических систем

Следует отметить, что одной из наиболее общих и сложных функций интеллекта является возможность производить классификацию. Ни одно устройство или живой организм не может быть признан "думающим", если он не способен классифицировать образы. Под термином "классификация" здесь понимается процесс, приводящий к выбору известной группы образов (класса), к которой новый объект может быть отнесен в соответствии с некоторым набором критериев принадлежности, возможно, не допускающих формализацию. Эти критерии могут включать в себя не только (или вообще не включать) условие внешнего сходства между новым образом и прототипами в классе, но и различные семантические признаки, например, "назначение" (деньги и продукты), "принципы движения" (автомобили и самолеты) и т.п.. При этом не существует достаточно широкого разнообразия моделей искусственных нейронных сетей, способных выполнять классификацию такого типа. Подавляющее большинство подходов, известных как самоорганизующиеся карты Кохонена [1, 2] и их различные модификации [3], а также квантизация векторов при обучении [1, 4, 5], часто используются при классификации, основанной на сходстве образов. В то же время, очевидно, что проблема получения произвольного правила классификации может быть ре шена только посредством топологических изменений классифицирующей модели [6-8]. Для демонстрации возможностей топологического подхода к проблеме синтеза произвольных правил классификации в данной работе используется модель "синергетической нейронной сети" Хакена [9], которая производит распознавание предъявленного образа различной природы посредством конкуренции между скалярными функциями времени, называемыми параметрами порядка. Каждый параметр порядка соответствует одному запомненному образу, и конкуренция сводится к затуханию функций времени, соответствующих всем запомненным образам, кроме одного, наиболее похожего на предъявляемый. Может быть показано, что определенная модификация связей между параметрами порядка так изменяет топологию нейронной сети, что возникает новое устойчивое многообразие вследствие "объединения" отдельных аттракторов, соответствующих запомненным образам. Геометрическая размерность любого из таких многообразий может быть любой, хотя ранее существовавшие аттракторы являлись устойчивыми узлами и, следовательно, имели нулевую размерность. Соответственно, каждое новое многообразие отвечает отдельному подмножеству всего набора запомненных образов, а начальная точка в пространстве параметров порядка будет притянута к многообразию выбранно- го подмножества. Таким образом, можно говорить о классификации, выполняемой данной моделью. Принципиальным является то, что можно произвольно формировать многообразия в соответствии с набором правил классификации, причем необязательно использовать критерии сходства образов. Данная гибкая модель также позволяет включить один эталон в несколько различных классов, что практически невозможно в рамках альтернативных подходов.

Топология математической модели классификации

Для целей дальнейшего изложения кратко рассмотрим основы модели нейронной сети Хакена и ее развитие для реализации классификации. Каждый образ представлен N-мерным вектором с действительными компонентами; таким образом, v . (i=1,2,...,M) представляет запомненный образ (прототип), а предъявленный образ обозначен как q(0), где 0 выражает начальный момент времени в процедуре распознавания. С течением времени q(t) стремится к vk, где k - номер прототипа, наиболее похожего на предъявляемый вектор. В [9] показано, что q(t) может быть разложен в следующую линейную комбинацию:

M

q(t) = £ d i t)v i + ^ t) , i = 1

где d(t) - параметр порядка, а £ t) - дополнительная невязка, некоррелированная с каждым из v. Распознавание моделируется динамикой следующей системы связанных обыкновенных дифференциальных уравнений:

d d i =- d t

“ (1)

— Bd i £ d j £ g jk d k — Cd i ££ g jk d j d k j ^ i k = 1 j = 1 k = 1

с положительными константами В,С,Л . . Начальные условия определены следующим выражением:

di 0) = G —Vq (0), где G = v ‘V и V- матрица, состоящая из стол бцов v.. Результаты анализа устойчивости системы (1) демонстрируют зависимость существования и типов стационарных решений от соотношений между Л. [10], однако это не рассматривается в данной работе. Здесь полагается, что все Л. равны Л. При этом каждый запомненный образ v. обладает парой аттракторов в пространстве параметров порядка, определенной точками с координата- ми (0,...,0,d=±A\7c-n

‘ Cg ii ,0

,...,

Любая на- 0).

чальная точка будет притянута к одному из

указанных аттракторов, а распознавание таким образом заканчивается в тот момент, когда остается только один ненулевой параметр порядка. В подобной модели с конкуренцией не существует ложных устойчивых состояний, а максимальное количество запоминаемых и воспроизводимых образов равно N-1 , что существенно отличается от распространенных нейронных сетей Хопфилда.

Теперь вместо единственного параметра B в системе уравнений (1) рассмотрим случай, когда кроме связей, задаваемых матрицей G, имеется также новая матрица B с элементами:

b. =

*/

b

ji

=

B , ifi

e

J

Здесь J(n> - система индексов из подмножества натуральных чисел, и, кроме того, в предположении, что все множество запомненных образов Q разбито на P подмножеств (классов) Wn в соответствии с условиями

О= Ц> пи IW n = 0 , n =1 neJ полагаем z e j(n) ^ vi eW n . Тогда система (1) может быть записана в форме:

d o

---— Лd. — dt 1

“ (2)

— d i £ b ij d j £ g jk d k — Cd i ££ g jk d j d k j ^ i k = 1 j = 1k = 1

для всех t=1,2,...,M. Можно показать, что новая система (2) обладает стационарными решениями в форме эллиптических многообразий для любого класса W n :

[ S d k S g ki d i -Л /с = 0 k e J(n) i e J(n)

d j = 0,ifj J (n)

В случае пересекающихся классов существуют также дополнительные стационарные решения, соответствующие каждому пересечению. Рассмотрим множество из s пересекающихся классов W k , удовлетворяющее соотношению и s = I W k ^ 0 и набор L (s

L k e L(s)

индексов к в случае v k e U L (S> . Тогда стационарное решение системы (2), соответствующее U L (s) , определено посредством следующего выражения:

S d k S g ki d i -Л /с = 0 k e L(s) i e L(s)

d j = 0,ifj L(s)

Можно показать, что многообразия (3) состоят из непрерывно распределенных точек, обладающих устойчивостью типа "устойчивый узел" по отношению к фазовому пространству за вычетом касательной максимальной размерности к конкретной рассматриваемой точке многообразия (3). Каждая такая точка обладает нейтральной устойчивостью в линейном приближении в подпространстве, образованной касательной. Если рассматриваются пересекающиеся подмножества, то решение (4) образуется из точек, обладающих нейтральной устойчивостью в подпространстве, образованном объединением касательных ко всем пересекающимся в рассматриваемых точках многообразиям. Следовательно, в рассматриваемой модели с введенной матрицей B происходит конкуренция только между d i , соответствующими образам v, принадлежащим к различным подмножествам. Это приводит к динамическому затуханию значений всех параметров порядка, за исключением принадлежащих к выбранному классу W k (или нескольким, если они пересекаются), т.е. имеет место классификация предъявленного образа.

Случай трех образов

В данном разделе подробно рассматри вается случай M=3. Пусть три образа разбиты на два класса (P=2). Сначала остановимся на случае непересекающихся классов. Класс W1 состоит из одного образа v1, а класс W2 -из v2 и v3. Тогда матрица B задается следующим образом:

B = B

В В )

0 0

0 0 / где B - положительная константа. Система уравнений (2) принимает форму:

dd

—1 = Л d.

dt 1

- В Sdidj S gjkdk j=2k

- C S d i d j S g jk d k j = 1 k = 1

- -2-=m2-мдSgikdk-C Sd2djSgjkdk dt k=1 j=1k

—-3=Лd з- Bdadi S gikdk- C S d3dj S gjkdk dt k=1 j=1k

Следуя подходу, описанному в разделе 1, исследуем два стационарных решения системы (5):

D 1 = { d. 1 2 = Л /Cg11,d2 = 0,d3 = 0 } ,

D

d 1 = 0,d 2 , d3 : S dj S g jk d k -Л /с = 0 * j = 2 k = 2

где решение D 1 должно соответствовать аттрактору класса W 1 , а D 23 - аттрактору класса W 2 . Данное предположение может быть доказано после исследования собственных чисел матрицы линеаризации системы (5). Матрица линеаризации для решения D 1 имеет следующий вид:

L 1

- 2 Л - (В /с + 2 ) Л g12 / g 11 - (В /с + 2 ) Л g13 / g 11

0 -Л В /с 0

0 0 -Л В /с

V /

Очевидно, что все ее собственные значения отрицательны, поэтому D 1 - аттрактор класса W 1 (многообразие размерности 0). Аналогично для D 23 :

-Л В /с

X

0 0

L

-

- B + х )d s g 1k d k - ■ d S g 2k d k - ■ d S g 3k d k k = 2 k = 2 k = 2

-

- B + 2 с )d3 s g 1k d k - 2d3 S g 2k d k - 2d3 S g 3k d k

k = 2 k = 2 k = 2

Легко показать, что L 2 3 имеет собствен-

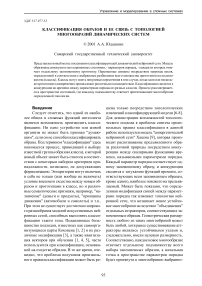

Рис. 1. Аттракторы двух классов для случая трех запомненных образов

ные значения { -Л в /С , - 2 Л ,0 } , что отвечает стационарному решению в виде многообразия размерности 1. Каждая точка на многообразии D 23 является аттрактором относительно дополнения D 2 3 до трехмерного евклидового пространства и обладает нейтральной устойчивостью по отношению к остальным точкам данного многообразия.

На рис.1 приведен случай M=3 запомненных образов, распределенных между P=2 классами. Здесь показано одно стационарное решение вида эллиптического многообразия (аттрактор класса W 2 ) и точка (аттрактор класса W 1 ).

Здесь аттракторы классов W 1 и W 2 обозначены соответственно как D 1 и D 23 для наборов индексов J(1)={1} и J(2)={2,3}. Фазовые траектории заканчиваются либо в устойчивом узле D 1 , либо в одной из точек многообразия D 23 . Таким образом, предъявленный образ либо идентифицируется как прототип v 1 , либо классифицируется в подмножество W 2 .

Иная ситуация имеет место, если W 1 и W 2 пересекаются. Пусть v2 принадлежит обоим классам, причем v 1 принадлежит только W 1 , а v3 принадлежит W2. Существуют два эллиптических многообразия, представляющих указанные классы:

D 12

2 2

’did :£dj£ gjkdk-Л/С = 0d = О- j=1 k=1

Они пересекаются в точке

{О/Г^/Л /Cg 22,0}, и матрица линеаризации, соответствующая пересечению, имеет два нулевых и одно отрицательное собственное значение. При этом классификация сводится к конкуренции между образами v1 и v3 в двумерном подпространстве.

Рассмотренные примеры хорошо иллюстрируют достоинства предложенной модели. Если классы не пересекаются, то начальная конфигурация считается принадлежащей к одному из них после завершения конкуренции между соответствующими группами параметров порядка. Каждый образ принадлежит своей категории, т.е. пространство образов точно разделено на области притяжения отдельных классов. Однако существует ряд реальных ситуаций, когда для нового образа невозможно указать только один класс. Например, если попытаться классифицировать велосипед с использованием категорий "машины", "игрушки" и "продукты", то следует отметить, что указанный объект может быть отнесен и к "машинам", и к "игрушкам" одновременно. Поэтому при запоминании образа велосипеда следует добавить его сразу в два класса. Предложенная модель позволяет это сделать. Тогда если затем будет предъявлен новый образ, похожий в том числе на велосипед, то сам прототип не будет участвовать в конкуренции между классами "игрушек" и "машин", соответственно, результат будет зависеть от остальных запомненных образов.

Матрица B может быть сформирована в соответствии с различными требованиями. Очевидно, что в данном случае совершенно необязательно объединять именно похожие образы в рамках одного класса, поскольку модель позволяет использовать любые формальные правила. Если предъявленный образ идентифицируется с одним из прототипов, выбирается весь соответствующий класс, т.е. для выполнения классификации достаточно того, чтобы новый образ был похож на хотя бы одного представителя класса.

D

23 =

з з di = 0,d2,d3 <£dj£gjkdk-Л/C = °!.

j = 2 k = 2

Численное моделирование

Численные эксперименты были прове-

дены для N=100, M=98 и состояли из последовательных предъявлений произвольно выбираемых из набора прототипов, к которым были добавлены искажения. Качество классификации рассчитывалось как отношение числа успешной работы модели к общему числу предъявлений. Искажения представляли собой вектор шума п с нормальным распределением. Дисперсия шума opn 2 изменя- 22

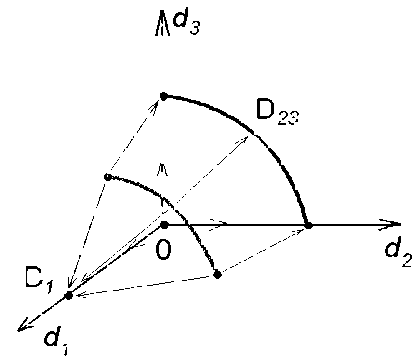

лась так, что уровень шума р = оп / о v , где o v 2 - дисперсия прототипа, рос от 0 до 1. Эксперименты продемонстрировали ряд интересных особенностей модели. Во-первых, качество классификации Q зависит от разбиения исходного набора образов - величина Q убывала от 100% до 0% с уменьшением мощности выбранного класса. Во-вторых, среднее качество классификации было всегда выше, чем качество распознавания (определения уникального прототипа, похожего на предъявляемый образ) с теми же параметрами модели (около 95%). В-третьих, обнаружен немонотонный характер зависимости качества классификации от уровня шума; более того, существует интервал повышения уровня шума, на котором Q также растет, что можно видеть из рис.2.

Причина последнего эффекта лежит в некоторых топологических особенностях распределения начального состояния системы (2) и имеет достаточное сходство с соответствующими биологическими процессами. В частности, рассмотрим среднеквадратическое отклонение S начального состояния d(0) от

Рис. 2. Изменение качества классификации в зависимости от уровня шума некоторого стационарного состояния d0={1,0,..,0} (Л=С=1), отвечающего выбору v0. Тогда q(0)= v0+n и S зависит от d(0) как:

S 2 = [d0 - d(0)]′ G [d0 -d(0)]=η′VG -1V ′η что может быть получено из определения нейронной сети Хакена [9]. Очевидно, что, если M Выводы Мы рассмотрели новую схему синтеза синергетической нейронной сети, которая способна классифицировать предъявляемый образ. Здесь классификация происходит вследствие разделения фазового пространства на области притяжения многообразий, отвечающих различным наборам запомненных образов (классам). Процедура заключается в выборе одного из классов, к которому предъявляемая конфигурация может быть отнесена в соответствии с некоторым правилом. В процессе классификации все классы конкурируют друг с другом, результатом чего является ситуация, когда параметры порядка всех классов, кроме одного выбранного, релаксируют к нулю. Данная нейронная сеть обладает высоким качеством классификации, что было установлено численными экспериментами на границе памяти. Прототипы могут быть разделены на классы в соответствии с произвольными правилами, а не только по признаку сходства. Более того, допустимо ассоциировать любой запоминаемый образ с более чем одним классом, т.е. задавать несколько семантических характеристик одному образу. Предложенный метод позволяет строить достаточно развитые нейронные сети с гибким обучением через построение матриц B и G и придавать им разнообразные свойства.