Метод выделения быстродвижущихся объектов при использовании цифрового оптического локатора следящего типа

Автор: Ваниев Александр Александрович, Емельянов Геннадий Мартинович

Журнал: Компьютерная оптика @computer-optics

Рубрика: Обработка изображений: Восстановление изображений, выявление признаков, распознавание образов

Статья в выпуске: 4 т.37, 2013 года.

Бесплатный доступ

В статье рассматриваются особенности задачи выделения быстродвижущихся объектов по изображениям, получаемым с подвижного фотоприёмного устройства. Предлагается алгоритм, основанный на вычислении межкадровой разности. Одновременно предложенный алгоритм устраняет недостаток известного метода, заключающийся в появлении инверсных изображений объекта.

Цифровой оптический локатор, выделение объектов, траекторные измерения

Короткий адрес: https://sciup.org/14059194

IDR: 14059194

Текст научной статьи Метод выделения быстродвижущихся объектов при использовании цифрового оптического локатора следящего типа

Переход от фотоплёночной технологии регистрации изображения в оптических средствах измерения угловых координат к цифровой, благодаря применению ПЗС-матриц, привёл к пересмотру технологии обработки измерительной информации. Появилась возможность обнаруживать и оценивать движение в реальном или близком к нему времени.

Отличительная особенность цифровых оптических локаторов следящего типа (ЦОЛС) состоит в том, что лоцируемый объект обнаруживается в небольшом поле обзора пространства [1]. Пространственные углы поля обзора обычно не превышают нескольких угловых градусов. В случае использования фотоприёмных устройств (ФПУ) высокого разрешения эта особенность позволяет определять координаты цели с высокой точностью. Однако эта же особенность приводит к необходимости решения задачи автоматического сопровождения движущихся объектов без привлечения информации из дополнительных источников, таких как РЛС.

Эту задачу можно разбить на ряд подзадач:

-

• выделение движущихся объектов на изображении, полученном с подвижного ФПУ;

-

• идентификация интересующего объекта (цели), который необходимо сопровождать;

-

• выработка управляющих воздействий для опорноповоротного устройства (ОПУ).

В рамках данной работы рассматривается подзадача 1 для случая быстродвижущихся объектов. Под быстродвижущимися объектами будем понимать объекты, угловое перемещение которых за время одного кадра превышает угловые размеры самого объекта при наблюдении с измерительного пункта.

Рассмотрим последовательность видеокадров, поступающих с ФПУ с частотой 25– 100 Гц.

В этой последовательности кадров появляются движущиеся объекты, количество которых изначально неизвестно. В одном и том же кадре в поле зрения могут присутствовать несколько объектов одновременно. Объекты могут отличаться яркостью, размером, формой и скоростью движения. В этих условиях необходимо выделить движущиеся объекты и получить информацию, достаточную для их идентификации и определения параметров движения.

Описание измерительного комплекса

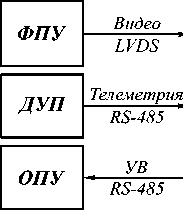

Упрощённая структура измерительной станции следящего типа представлена на рис. 1.

|

ЭВМ

|

- Мониторинг - Результаты измерения |

|

Ethernet |

Рис. 1. Структура измерительной станции следящего типа: ФПУ - фотоприёмное устройство; ДУП - датчики углового положения; ОПУ - опорно-поворотное устройство; УВ - управляющее воздействие

Фотоприёмное устройство размещается на подвижном опорно-поворотном устройстве. Функции регистрации информации, идентификации целей, а также управления движением ОПУ реализуются на специализированной ЭВМ.

В настоящее время существует ряд весьма эффективных алгоритмов, предназначенных для сравнения изображений или поиска объектов на изображениях. Примером такого алгоритма может выступать алгоритм SURF [2]. Этот и подобные ему алгоритмы основаны на идее определения сходства между изображениями по так называемым «особым точкам». Однако в рамках рассматриваемой задачи применение алгоритмов этого типа является неэффективным по ряду причин. Прежде всего , алгоритмы сопоставления по особым точкам наиболее эффективны для сравнения изображений достаточно крупных объектов, имеющих большое количество ярких и тёмных участков, углов, контуров сложной формы. В рамках рассматриваемой задачи нас интересуют малоразмерные быстродвижущиеся объекты, такие как артиллерийские снаряды. Их изображения достаточно малы и не обладают ярко выраженной текстурой. При этом фон, на котором движутся объекты, также является подвижным (по причине подвижности ФПУ).

Помимо этого, алгоритмы, подобные SURF, отличаются высокой ресурсоёмкостью, что затрудняет их применение в задачах реального времени.

Всё это вызывает необходимость разработки менее универсальных, но более эффективных в рассматриваемых условиях алгоритмов.

Алгоритм обнаружения быстродвижущихся объектов по данным оптического канала наблюдения

Обнаружение объектов предлагается осуществлять в два этапа:

-

1) Предварительная обработка изображения.

-

2) Выделение объектов; определение положений объектов в кадре, их размеров. Расчёт угловых координат.

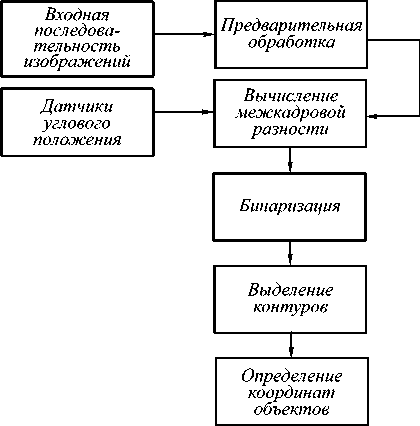

Таким образом, один из возможных алгоритмов показан на рис. 2.

Рис. 2. Структурная схема алгоритма выделения объектов

Съёмка должна производиться с как можно более короткой экспозицией, что позволит уменьшить смаз и повысить чёткость изображения наблюдаемого объекта.

В ситуации, когда экспозиция отличается от кадра к кадру, на этапе предварительной обработки может быть полезна операция выравнивания гистограммы яркости [3]. Практика показывает, что наиболее эффективным и в то же время простым методом является линейное контрастирование (рис. 3 а ). Если съёмка производилась с неизменным значением экспозиции, операция контрастирования, как правило, не требуется.

а)

б)

Рис. 3. Предварительная обработка слабоконтрастного изображения: исходное изображение (а); результат линейного контрастирования (б)

На этом этапе также может быть полезным использование медианного фильтра [3], что позволит уменьшить уровень шума.

Одним из классических способов выделения движущихся объектов является нахождение разностного изображения на основе соседних кадров видеопоследовательности (далее – « разностный метод»). Как показано в [4], этот метод устойчив к изменениям соответствующих компонентов естественного фона, скорость которых много меньше скорости съёмки (таким, как движение листвы деревьев, облаков и т.п.). При этом данный метод весьма прост в реализации и не требует больших вычислительных затрат, что позволяет применять его в системах с низкой производительностью, таких как мобильные устройства.

Таким образом, имеет смысл адаптировать разностный метод для использования в полигонных следящих станциях на более высоких кадровых частотах (50–100 Гц).

В силу подвижности ФПУ непосредственное вычитание кадров в рассматриваемой задаче неприменимо. Для успешного решения задачи необходимо учитывать движение ФПУ.

В настоящее время задача определения движения камеры обычно решается методами одометрии. Специфика рассматриваемого класса приборов такова, что вместе с видеоизображением регистрируется телеметрическая информация, содержащая угловые положения камеры в каждом кадре. Существуют технические решения, использующие эту особенность. Рассмотрим более подробно метод селекции движущихся целей, описанный в [5].

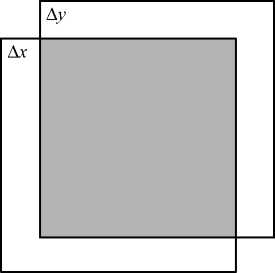

Рис. 4. Сдвиг изображения

Пусть текущее и предыдущее положения визирной оси прибора оцениваются парами показаний угловых датчиков ( α i , β i ) и ( α i - 1, β i - 1) соответственно.

Практика показывает, что поворот камеры по азимуту и углу места эквивалентен сдвигу фонового изображения на некоторый вектор ( ∆x , ∆y ). Его оце- нивают следующим образом:

∆β ∆α

∆x = ; ∆y = ;

β pv α ph

где ∆β , ∆α – разность измерений углового положения визирной линии объектива соответственно по вертикали и горизонтали; β pv , α ph – разрешающая способность матрицы фотодетекторов соответственно по вертикали и горизонтали.

β pv , α ph находятся из формул

LL

β pv = fpv ⋅ k и α ph = f ph ⋅ k , (2)

где Lpv и Lph – размеры по вертикали и горизонтали фоточувствительной поверхности фотодетекторов; f – фокусное расстояние объектива;

k – число угловых секунд в радиане k = 206265.

С учётом этого сдвига можно формировать разностное изображение ID :

ID ( x , y ) = Ii ( x , y ) - Ii - 1( x +∆ x , y +∆ y ) , (3)

где x , y – координаты пикселя; I i – изображение с текущего кадра; I i –1 – изображение с предыдущего кад-

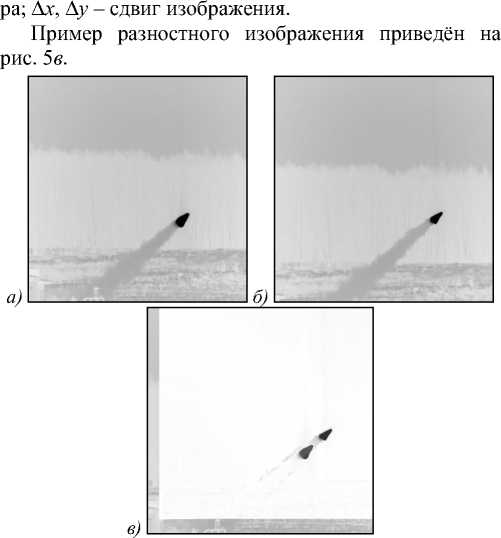

Рис. 5. Метод межкадровой разности по двум кадрам (изображения инвертированы): предыдущий кадр (а); текущий кадр (б); разностный кадр (в)

В [4], [5] показано, что в результате вычитания кадров происходит отсечение неподвижного фона.

Необходимо также отметить, что разностный метод позволяет выделять движущиеся объекты лишь в перекрывающейся части двух соседних кадров. Вблизи краёв образуются «слепые зоны», которые не участвуют в работе (рис. 4). Соответственно могут быть определены граничные условия применимости метода: пусть Rx (пикс.) – разрешение ПЗС-матрицы по одной из координат, w – угол обзора камеры, FT – частота кадров, с которой производится съёмка, ω max – максимальная угловая скорость, с которой способно двигаться ОПУ. Отсюда можно оценить максимальный размер слепой зоны вблизи края изображения по соответствующей координате:

ωR max x

F T w

.

Допустимое значение S выбирается исходя из минимальных размеров области изображения, в которой будет осуществляться обнаружение объектов (заштрихованная область на рис. 4). Например, в типичном случае с ПЗС-матрицей разрешением 1024×1024 пикс. при частоте кадров 25 герц, поле зрения 10 угл. град. и угловой скорости по азимуту 10 угл. град/с ширина слепой зоны составит 41 пиксель. Такое значение можно считать приемлемым для практических применений.

Авторы патента [5] отмечают, что разностный кадр содержит два изображения движущейся цели – прямое и инверсное, которое запаздывает относительно первого на время, равное периоду следования кадров.

Этот эффект некритичен для систем автосопровождения, работающих по одиночной цели, однако в контексте идентификации и оценивания координат групповых объектов может вызвать некоторые трудности. В частности, инверсное изображение может быть распознано как самостоятельный объект, что нежелательно.

Предлагается два варианта решения этой проблемы.

Первый способ заключается в формировании модели фона IG по одной из формул:

IG ( x , y ) = min( Ii ( x , y ); Ii - 1( x + ∆ x , y + ∆ y )) ; (5)

IG ( x , y ) = max( Ii ( x , y ); Ii - 1( x + ∆ x , y + ∆ y )) . (6)

Полученная модель фона I G состоит из минимальных (либо максимальных) значений соответствующих пикселей двух последовательных кадров. С учётом (5) или (6) формула (3) примет вид:

ID ( x , y ) = Ii ( x , y ) - IG ( x , y ) . (7)

Неудобство этого подхода заключается в том, что для объектов, которые светлее фона, нужно использовать формулу (5), а для объектов, которые темнее – формулу (6). В противном случае положение объекта на разностном изображении будет соответствовать моменту времени предыдущего кадра.

Второй предлагаемый способ основан на использовании трёх кадров для обнаружения объектов. Рассмотрим разностные изображения I1D и ID2 , получен- ные согласно (3) по трём последовательным кад-рамIi, Ii-1, Ii-2:

I 1 D ( x , y ) = Ii ( x , y ) - Ii - 1( x +∆ x 1, y +∆ y 1) ;

ID 2 ( x , y ) = Ii - 1( x +∆ x 1, y +∆ y 1) -

- Ii - 2( x + ∆ x 1 +∆ x 2, y +∆ y 1 +∆ y 2)I’

где ∆x1 , ∆y1 – сдвиг изображения между кадрами Ii и Ii-1 ; ∆x2 , ∆y2 – сдвиг изображения между кадрами Ii-1 и Ii-2 . Каждое из полученных разностных изображений будет содержать как прямые, так и инверсные изображения объектов для соответствующей пары кадров. Сформируем результирующее разностное изображение следующим образом:

ID ( x , y ) =

= ( I 1 D ( x , y ) - I D 2 ( x , y )) θ ( I D 1 ( x , y ) - I D 2 ( x , y ));

где 0 ( x ) - функция Хевисайда [6]:

f 0, x < 0;

0 ( x ) = I1 (11)

[ 1, x > 0.

Заданный таким образом кадр не будет содержать инверсных изображений объектов, при этом имеющиеся в нём изображения объектов будут соответствовать текущему кадру I i независимо от их яркости. Таким образом устраняются основные недостатки как метода [5], так и формулы (7), однако появляются другие ограничения:

-

1) для выдачи первого результата требуется дополнительный кадр;

-

2) уменьшается область кадра, в которой может быть выделен объект при движении ФПУ. Максимальную ширину «слепой зоны» в этом случае следует считать равной 2S пикселей.

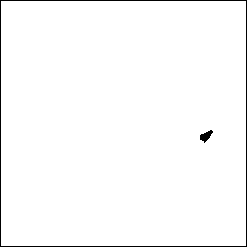

По полученному разностному изображению ID можно осуществлять собственно выделение движущихся объектов. Для этого предлагается подвергнуть разностное изображение бинаризации, в результате которой получается чёрно-белое изображение IB (рис. 7). Это позволит локализовать объекты и отсечь малозначимые колебания яркости, оставшиеся после вычитания кадров.

Рис. 6. Бинарное изображение (инвертировано)

Как известно, основной задачей измерительной станции следящего типа является определение угловых координат объектов, попадающих в её поле зрения [1]. Для расчёта угловых координат объекта наблюдения необходимо знать положение его центра в системе координат датчика изображения.

Вычисление координат центра объекта можно осуществлять двумя способами, каждый из которых обладает определёнными достоинствами и недостатками.

Координаты геометрического центра объекта можно вычислять непосредственно по бинарному изображению как среднее арифметическое координат точек, принадлежащих контуру объекта [7]. Это позволяет существенно сократить объём вычислений, что важно при работе в реальном масштабе времени.

В случае протяжённых объектов, обладающих неравномерным распределением яркости, имеет смысл вычислять координаты энергетических центров объектов. Такой способ более предпочтителен на этапе послесеансной обработки. Для этого требуются дополнительные шаги. Прежде всего, необходимо по изображению IB найти фрагмент изображения, в котором обнаруживается объект.

Затем координаты энергетических центров можно вычислить при помощи пространственного фильтра [1] по изображению текущего кадра Ii :

XX '

xy

M " XX b xy xy

V

, M

XX '

xy

XXbxy ’ xy

где xM , yM – оценки координат объекта в системе координат матрицы; bxy – значение яркости пикселя с координатами (x,y); x , y – координаты пикселя на

Эксперименты показали, что в большинстве случаев достаточно простой бинаризации с глобальным порогом, который рассчитывается по формуле:

P = (maxc i D C x ’ y )) - mind D C x i y )))

матрице.

Такой подход позволяет учитывать яркость всех пикселей, принадлежащих объекту, и определять координаты его центра с субпиксельной точностью.

Таким образом, на выходе алгоритма для каждого объекта формируется следующая структура данных:

O i = { x c , У с , k , Г i } ,

Если же разностное изображение зашумлено (такое возможно, например, при съёмке в сложных погодных условиях), имеет смысл проводить дополнительную обработку изображения и использовать адаптивные алгоритмы бинаризации с локальным порогом [3].

Разработка методов дополнительной обработки разностного изображения, полученного в сложных условиях, выходит за рамки данной статьи и представляет собой отдельную тему для исследования.

Одной из важных характеристик движущегося объекта является его форма. В качестве характеристики формы объекта предлагается использовать его контур [7], [8].

Для прослеживания контуров объектов по бинарному изображению можно рекомендовать алгоритм Розенфельда [7].

где i – порядковый номер объекта;

xc , yc – координаты центра объекта на матрице;

k – длина контура объекта;

Г i = ( Y o , Y i , Y k - i ) — вектор-контур объекта в комплекснозначном виде [7].

По полученным координатам геометрического либо энергетического центра объекта на матрице можно получить угловые координаты объекта по методике, описанной в [1].

В дальнейшем, на этапе межкадровой идентификации объектов, такая структура данных позволяет проводить селекцию целей как по форме и размеру, так и по угловой скорости [9], что существенно повышает достоверность получаемых результатов.

В качестве характеристики размера объекта можно использовать длину контура. Это позволит принимать решение о целесообразности анализа формы объекта. Селекцию целей по форме предлагается проводить методами контурного анализа [7].

Результаты экспериментов

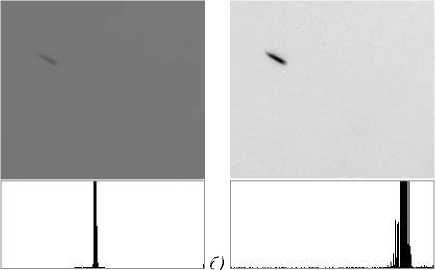

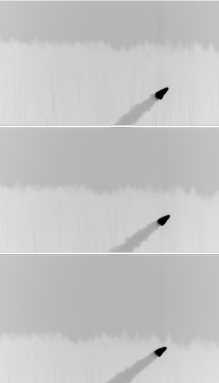

Эксперименты проводились на двух последовательностях кадров , отражающих следующие возможные случаи: светлый объект на тёмном фоне, тёмный объект на светлом фоне. Целью экспериментов являлось определение работоспособности предложенных методов вычисления разностного кадра. Фрагменты исходных кадров, содержащие выделяемый объект, приведены на рис. 7.

б)

Рис. 7. Исходные кадры: светящийся объёкт на тёмном фоне (а) (изображения инвертированы); тёмный объект на светлом фоне (б)

Результат выделения движущихся объектов по методу (7) с моделью фона, вычисленной по формуле (5), приведён на рис. 8.

Рис. 8. Результат применения метода (7) (изображения инвертированы): кадр из минимальных интенсивностей пикселей для случая «светлый объект на тёмном фоне» (а); разностный кадр для случая «светлый объект на тёмном фоне» (б); кадр из минимальных интенсивностей пикселей для случая «тёмный объект на светлом фоне» (в); разностный кадр для случая «тёмный объект на светлом фоне» (г)

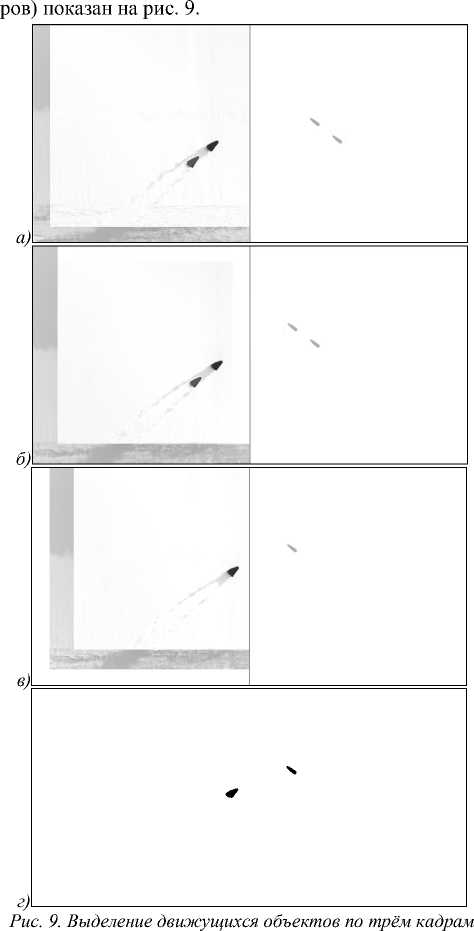

Результат выделения движущихся объектов по формуле (10) (на основе трёх последовательных кад-

(изображения инвертированы): первая межкадровая разность (а); вторая межкадровая разность (б); результат применения формулы (10) (в); бинарное изображение (г)

Как видно из рисунка, способ не даёт инверсного изображения, однако в случае «тёмный объект на светлом фоне» на разностном кадре появляется изображение объекта с предыдущего кадра. При использовании модели фона (6) аналогичный эффект возникает в случае «светлый объект на тёмном фоне». Это ограничивает область применения метода ситуациями, когда предполагаемая яркость объекта известна заранее.

Проведённые эксперименты показали, что наилучшие результаты получаются при вычислении межкадровой разности по формуле (10). Этот метод не даёт инверсного изображения и в то же время применим при произвольной яркости выделяемых объектов.

Тем не менее, для случаев, когда до проведения опыта известно, обладает ли выделяемый объект све- чением, может быть полезен и метод (7). Его достоинство заключается в меньшей площади «слепых зон», в которых невозможно обнаружить объект вычитанием кадров.

Заключение

Предложенный алгоритм позволяет обнаруживать движущиеся объекты по информации со следящих измерительных станций с учётом изменения положения ФПУ. При этом устраняется один из недостатков существующего способа, заключающийся в появлении инверсного изображения объекта, что могло приводить к ошибкам распознавания.

Алгоритм может быть использован как на этапе послесеансной обработки видеоинформации, так и на этапе сопровождения движущихся объектов в реальном масштабе времени.