Об ускоренных методах поиска канонического тензорного разложения

Автор: Меркулов Д.М., Тупица Н.К.

Журнал: Труды Московского физико-технического института @trudy-mipt

Рубрика: Информатика и управление

Статья в выпуске: 4 (48) т.12, 2020 года.

Бесплатный доступ

Рассматриваются методы на основе ускорения Нестерова для задачи альтернированных наименьших квадратов (ALS) для поиска канонического тензорного разложения. Для получения гарантий сходимости к стационарной точке в данной невыпуклой задаче используется модификация ускоренного градиентного метода с одномерным поиском для решения задач альтернированной минимизации. Изучается механизм рестартов, позволяющий преодолеть численную нестабильность процедуры линейного поиска и добиться более быстрой работы метода. Численные эксперименты показывают, что ускоренный метод альтернированных наименьших квадратов с рестартами может быть более эффективным, если задача плохо обусловлена. Существует потенциал развития описанного подхода для ускорения других невыпуклых задач оптимизации, например, таких как разложение Таккера.

Каноническое тензорное разложение, метод альтернированных наименьших квадратов, ускорение нестерова, невыпуклая оптимизация

Короткий адрес: https://sciup.org/142230095

IDR: 142230095 | УДК: 519.61

Текст научной статьи Об ускоренных методах поиска канонического тензорного разложения

Ускоренные методы Нестерова широко используются для получения более быстрой сходимости и достижения нижних оценок на классе выпуклых задач [8]. Недавние работы обобщают методы Нестерова для применения к задачам невыпуклой оптимизации [3,7] и задачам, которые не напрямую не решаются методами первого порядка, например такими, как Alternating Direction Method of Multipliers (ADMM) [4].

В данной работе нашей целью является обобщение ускоренных методов Нестерова на задачу альтернированных наименьших квадратов (ALS) для вычисления канонического тензорного разложения ранга г. А именно приближения исходного тензора суммой т тензоров ранга 1. В литературе описанная задача называется Canonical Polyadic (СР) decomposition of a tensor [6].

Представленный метод имеет теоретические гарантии сходимости для невыпуклых задач, какой и является задача канонического разложения, а также использует ускорения шагов альтернированной минимизации вместо традиционнных градиентных шагов, что является преимуществом данного метода. Но это же является и недостатком, так как при приближении к стационарной точке процедура линейного поиска становится нестабильной из-за нехватки машинной точности. Для разрешения этой проблемы предлагается рестар-товать метод при достижении нехватки точности.

Техника рестартов также рассматривалась в работах по ускорению методов решения нелинейных систем [9], выпуклых задач [4,10,11], а также нахождения неотрицательных матричных разложений [2].

Несмотря на отсутствие теоретических гарантий, в работе также проводится сравнение с ускоренным методом с адаптивным выбором весов. Метод не является монотонным и потому может не сходиться к стационарной точке, однако в среднем показывает хорошую сходимость.

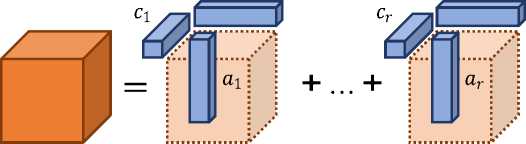

Каноническое разложение позволяет представить каждый элемент тензора следующим способом:

Т

Ti3k = ^AipB3 p Ckp.

p =i

На рис. 1 показано наглядное представление каконического разложения.

Более общим образом задачу можно сформулировать как задачу поиска приближенного канонического разложения, то есть поиска матриц A, B, C, которые минимизируют функцию f:

т тгзк - VA,pB3pCkp\ ^ r min . (1)

^ AeRIxr ,BeRJxx,ceRKxx p=1 / где ж = (A, B, C)T.

Метод альтернированных наименьших квадратов находит каноническое разложение итеративным образом. На каждой итерации метод последовательно обновляет одну из матриц A, B или C, минимизируя (1) при фиксированных остальных матрицах.

Выпишем частные производные функции f [1]:

bi Ьг

Рис. 1. Нахождение матриц А, В, С при заданыом тензоре T and СP-rank г

Формулы обновления матриц А, В, С выводятся путём приравнивания частных производных (2) - (4) к нулю и последующего решения системы линейных уравнений [1]:

ТДВ Ө С)= А ((ВтВ) * (СтС)) ,(5)

Т2(А Ө с) = В ((АтА) * (СтС)) ,(6)

Тз(А Ө В) = С ((АтА) * (ВтВ)) .(7)

На каждой итерации методом альтернированных наименьших квадратов решаются эти системы относительно матриц А, В и С и выписываются явные формулы решения для А, В и С при фиксированных двух других матрицах [1]. Алгоритм альтернированных наименьших квадратов (Algorithm 1) имеет следующий вид:

Algorithm 1 Alternating Least Squares for CP

Вход: Тензор T G R/xJ xK. ранг pa::іложеішя г.

Выход: Матрицы А G R/xr, В G RJ xr и С G RK xr.

Инициализируем А, В, С.

for к < N.

1. Ак+1 = argmin2 ||T(i) — А(Ск Ө Вк)т||р.

2. Вк + = argmin 1 ||T(2)— В(Ск Ө Ак)т||^. в

3. Сk+1 = argmin2 ||Т№— С(Вк Ө Ак)т|^,

3. Ускоренный метод альтернативных направлений

А

где Т (г) - раскрытие (шгfolding) матрицы T по iiii дексу г.

В данном разделе разберем вариацию Алгоритма 2 для задач, допускающих альтернированную минимизацию. В работе [5] рассмотрена такая вариация для функций с лип-шицевым градиентом. Далее приводится модификация алгоритма для решения сильно выпуклых задач, допускающих альтернативную минимиизацию (Algorithm 2).

Для удобства введем обозначения. Множество {1,...,N} векторов {e^J^i ортонор-мированного базиса разделено на п непересекающихся блоков Д, к G {1,...,п}. Пусть

S k (ж) = ж + span{e« : г Е I k } - подпространство, содержащее ж, построенное на базисных векторах к-то блока.

Algorithm 2 Accelerated Alternating Minimization

Вход: Начальная точка жд.

Выход: жк.

Полагаем Ад = 0, ж 0 = ж 0.

for к > 0.

-

1. Полагаем

-

2. Полагаем yk = жк + 3к(жк — жк).

-

3. Выбираем гк = argmaxiG{i,...,n}^Vi/ (yk )|2-

-

4. Полагаем жk +1 = argmin$G5.^ (^f (ж).

-

5. Если L известно, находим Qk+i из уравнения (АД+ДТ) = тй- Если L не известно, находим Qk+i из уравнения

-

6. Полагаем A k +1 = A k + Q k +1-

-

7. Полагаем vk+1 = argmin^GRv-^k+1(ж) .

3 k = arg;тіп/3е[д,1]/ ^k + 3 (vk — жк)}. (8)

a 2

О2,!

3 (У ) - 1 №f (yk )|Ц = f(жk +1 ). (9)

2(A k + Qk+i)

Адаптировав этот алгоритм к задаче канонического разложения, получим алгоритм с одномерным поиском следующего вида (Algorithm 3).

Algorithm 3 Accelerated ALS - Line Search (AALS - Line Search) / A0

Вход: Начальные точки ж0 = ж0 = I В д С д

Выход: ж^.

for к 6 N.

-

1. Полагаем yk = жk + 3 k (yk — жk) , { Наилучшая выпуклая комбинация} гДе 3k = argmin f (,,жk + 3(vk — жk)).

-

2. Полагаем жk+1 = argmin f (ж ) ,{ Шаг альтернативной минимизации} €

-

3. Полагаем -yk+1 = vk — Qk+iVf (yk). { Евклидов проксимальный шаг}

^G[0,1]

где ^ = argmax |V5f(yk)|2- € G{ A,B,C }

Также сравним представленный алгоритм с адаптивным выбором весов, с которыми добавляется моментное слагаемое (Algorithm 4).

Algorithm 4 Accelerated ALS - Adaptive (AALS - Adaptive)

/ Ао

Вход: Начальные точки v0 = ж0 = I Во С о

Выход: xN.

for k 6 N.

-

1. Полагаем yk = xk + 3 k (vk — $k ) , где Дщ = 2^^ + ^ 4^ + «kirtl •

-

2. Полагаем ж^1 = argminf(ж ), { Шаг альтернативной минимизации} £

-

3. Полагаем vk+1 = vk — « k +i Vf (yk ). { Евклидов проксимальный шаг}

где £ = argmax ||V5f (yk )|2.

Е.е{ А,в,С }

Далее приводится алгоритм с рестартами (Algorithm 5). Критерием выхода из процедуры одномерного поиска является выполнение двух условий f (yk) 6 f ^k) и (Vf (yk ),vk — yk ) > 0. Если процедура одномерного поиска достигает необходимости искать подходящую точку на отрезке длиной Ь і — « і > Emac hi ne, то следует рестартовать метод.

Algorithm 5 ALS - 5G

Вход: Starting point ж0.

Выход: yN.

for k 6 N.

-

1. while Ьі — a i > E machine'

1) Выполнять AALS - Line Search с начальной точкой жk и пол учить yk.

2. Выполнить 1 итерацию ALS с начальной точкой yk и получить ж&.

4. Эксперименты

Тензор T конструируется с помощью случайного выбора матриц А G R^ хт,В G R^ хтпС G R^xr из (лапдартпого норм;гтыюго распределения N (0,1). Каждый столбец нормируется, и целевой тензор имеет вид

T = (А, В, С) • I + д М^ВСМдN, llN 11г где N - трехмерный тензор нормального шума, д - отношение сигнал-шум.

Генерация плохо обусловленного случайного тензора. Здесь каждая из матриц А, В, С генерируется с помощью сингулярного разложения. Диагональная матрица в разложении выбирается плохо обусловленной, например для матрицы А G R^хг:

А = Ua^aVa, где Ua G R^хг и Va G Rrxr сгенерированы случайно с векторами-столбцами единичной длины, матрица У a G Rrxr диагональная, ее спектр разделен на 2 группы, в каждой группе элементы спектра распределены равномерно. Первая группа - на [IJK/2; I JK], вторая -на [0;1].

Для измерения качества используется стандартное относительное отклонение (RSE):

RSE =

Ц Т — TIf IITIf

Далее следует численное сравнение всех представленных алгоритмов.

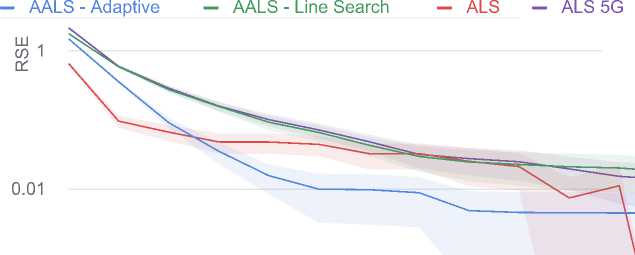

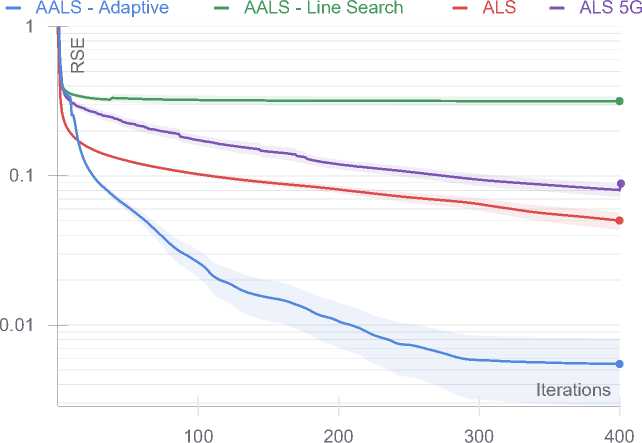

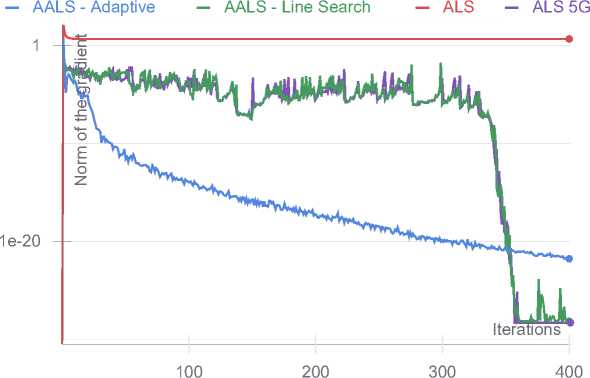

Random 30 x 30 x 30 tensor with CP rank 20. 20 runs

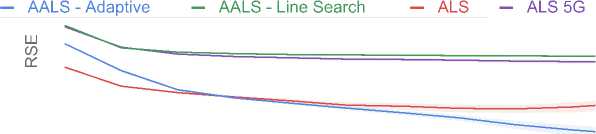

Random 30 х 30 х 30 tensor with СР rank 20. 20 runs

0.0001

Wall time

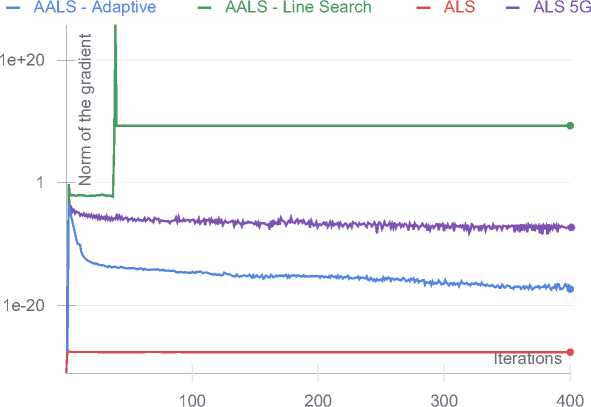

Random 30 х 30 х 30 tensor with СР rank 20. 20 runs. Grad norm

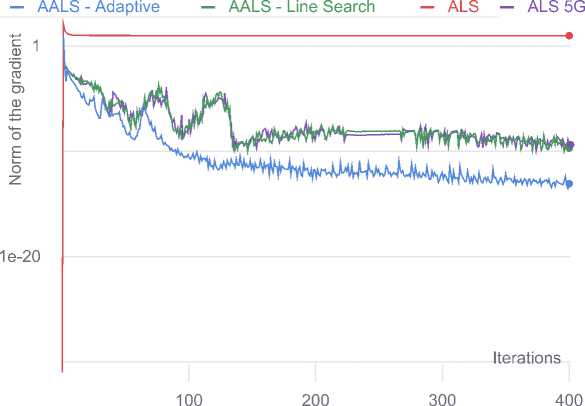

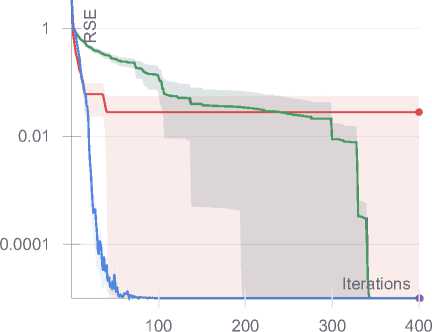

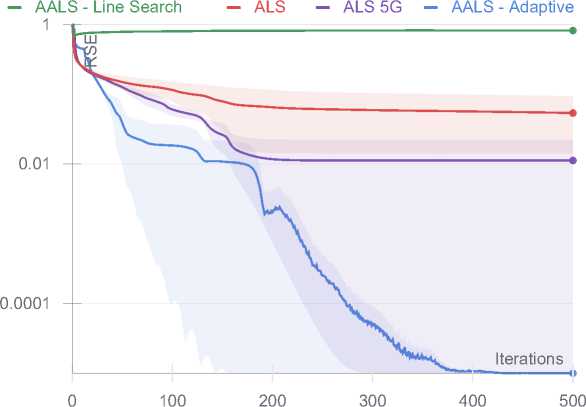

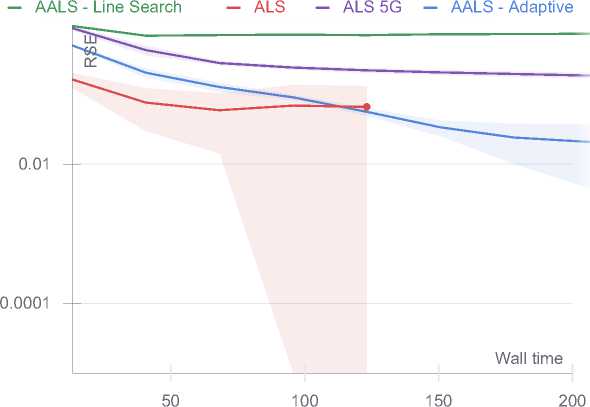

Ill-posed 30 x 30 x 30 tensor with CP rank 20. 20 runs

Ill-posed 30 x 30 x 30 tensor with CP rank 20. 20 runs

0.01

0.0001

Wall time

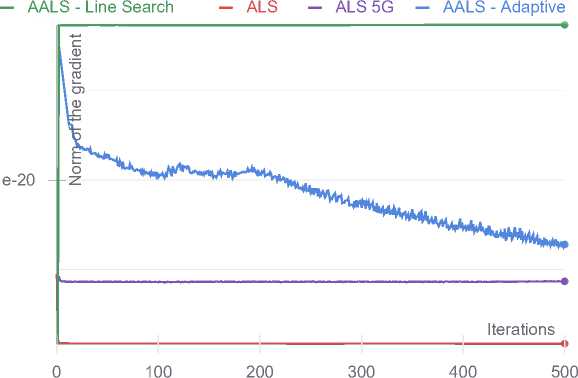

Ill-posed 30 x 30 x 30 tensor with CP rank 20. 20 runs. Grad norm

Random 100 x 100 x 100 tensor with CP rank 25. 5 runs

' AALS - Adaptive ^^е AALS - Line Search ALS ^^м ALS 5G

Random 100 x 100 x 100 tensor with CP rank 25. 5 runs

Random 100 x 100 x 100 tensor with CP rank 25. 5 runs. Grad norm

Ill-conditioned 100 x 100 x 100 tensor with CP rank 25. 3 runs

Ill-conditioned 100 x 100 x 100 tensor with CP rank 25. 3 runs

Ill-conditioned 100 x 100 x 100 tensor with CP rank 25. 3 runs. Grad norm

Рис. 2. Результаты численных экспериментов

5. Заключение

Для тензоров малого размера наблюдается более быстрая сходиомсть адаптивного метода (Algorithm 4) для случайной и плохо обусловленной задачи. При этом, как было сказано выше, метод не имеет гарантии сходимости для данной задачи. Также следует отметить более быструю сходимость неускоренного метода альтернированных наименьших квадратов по сравнению с остальными методами по норме градиента для задачи малого разме ра (30 х 30 х 30).

Для задач большого размера (100x100x100) адаптивный метод также демонстрирует более быструю сходимость, но есть и исключения, где Algorithm 5 в среднем опережает остальные алгоритмы по итерациям.

Плохо обусловленные задачи большого размера иллюстрируют различное поведение представленных алгоритмов. Адаптивный алгоритм (Algorithm 4) показывает себя наилучшим образом.

Для более правильного сравнения следует решать задачу одномерного поиска явно, а именно находить более точно (или явно) корни полинома третьей степени. Возможно, метод с одномерным поиском проигрывает в некоторых эксперинтах именно по причине нехватки машинной точности. Следует более детально исследовать этот вопрос.

Исследование выполнено при поддержке Министерства науки и высшего образования Российской Федерации (госзадание) №075-00337-20-03, номер проекта 0714-2020-0005. Работа была выполнена в рамках проектной смены в Сириусе 2-23 августа 2020 г. (рук. А. С. Ненашев).

Список литературы Об ускоренных методах поиска канонического тензорного разложения

- Acar Е., Dunlavy D.M., Kolda T.G. A scalable optimization approach for fitting canonical tensor decompositions .Journal of Chemometrics. 2011. 25(2). P. 67 86.

- Ang A.M.S., Gillis N. Accelerating nonnegative matrix factorization algorithms using extrapolation /7 Neural computation. 2019. 31(2). P. 417 439.

- Ghadimi S., ban G. Accelerated gradient methods for nonconvcx nonlinear and stochastic programming /7 Mathematical Programming. 2016. 156(1 2). P. 59 99.

- Goldstein T., О 'Donoghue. В., Se.tze.r S., Baraniuk R. Fast alternating direction optimization methods /7 SIAM .Journal on Imaging Sciences. 2014. 7(3). P. 1588 1623.

- Guminov S., Dvurechensky P., Tupitsa N., Gasnikov A. Accelerated Alternating Minimization, Accelerated Sinkhorn's Algorithm and Accelerated Iterative Bregman Projections // arXiv e-prints. page arXiv:1906.03622. June 2019.

- Kolda T.G., Bader B.W. Tensor decompositions and applications // SIAM review. 2009. 51(3). P. 455-500.

- Li H., Lin Zh. Accelerated proximal gradient methods for nonconvex programming // Advances in neural information processing systems. 2015. P. 379-387.

- Nesterov Yu. A method of solving a convex programming problem with convergence rate o(1/k2) 11 Soviet Mathematics Dokladv. 1983. V. 27. P. 372-376.

- Nguyen N.C., Fernandez P., Freund R.M., Peraire J. Accelerated residual methods for the iterative solution of systems of equations // SIAM Journal on Scientific Computing. 2018. 40(5). P. Л3157 Л3179.

- О 'donoghue В., Candes E. Adaptive restart for accelerated gradient schemes // Foundations of computational mathematics. 2015. 15(3). P. 715-732.

- Su W., Boyd S., Candes E.J. A differential equation for modeling nesterov's accelerated gradient method: theory and insights // Journal of Machine Learning Research. 2016. 17(153). P. 1-43.