Подходы к обнаружению и оценке параметров движущихся объектов на видеопоследовательности применительно к транспортной аналитике

Автор: Алпатов Борис Алексеевич, Бабаян Павел Вартанович, Ершов Максим Дмитриевич

Журнал: Компьютерная оптика @computer-optics

Рубрика: Обработка изображений, распознавание образов

Статья в выпуске: 5 т.44, 2020 года.

Бесплатный доступ

Рассмотрены различные подходы к обработке изображений и видео с целью решения задач обнаружения, слежения и оценки параметров движущихся объектов. Описаны разработанные алгоритмы решения обозначенных задач применительно к области транспортной аналитики. При разработке алгоритмов внимание было уделено решению задач на внутренней платформе камер видеонаблюдения, что накладывает ограничения на вычислительную сложность. Первый алгоритм (базовый) выполняет обнаружение и оценку параметров движущихся объектов и основан на обработке двух связанных зон изображения. Данный алгоритм включает вычислительно эффективную и адаптивную процедуру оценки и обновления фоновой составляющей изображения на основе физики процесса движения объекта интереса через зону обработки. Второй алгоритм выполняет слежение за объектом на основе метода оптического потока, инициализированного особыми точками. Третий алгоритм основан на прослеживании сегментов объекта, невысокая сложность алгоритма позволяет реализовать его на внутренней платформе интеллектуальных камер. Приведены результаты экспериментальных исследований предложенных алгоритмов, также проведено сравнение с некоторыми алгоритмами, представленными в литературе. Показано, что алгоритмы слежения позволяют повысить точность обнаружения и оценки параметров движущихся объектов, а также сократить вероятность ошибок классификации по сравнению с базовым подходом.

Обнаружение объектов, слежение, оценка параметров, обработка изображений, анализ видеопотоков, транспортная аналитика

Короткий адрес: https://sciup.org/140250046

IDR: 140250046 | DOI: 10.18287/2412-6179-CO-701

Текст научной статьи Подходы к обнаружению и оценке параметров движущихся объектов на видеопоследовательности применительно к транспортной аналитике

Задачи обнаружения и оценки параметров движущихся объектов являются актуальными в сфере транспортной аналитики, что связано с проблемой постоянно растущего числа автомобилей на дорогах, приводящей к значительному увеличению экономических и социальных издержек. Система видеоаналитики позволяет получать информацию, которая может включать количество объектов, движущихся по полосам; плотность потока автомобилей; параметры объектов: скорость, размеры, тип. Фактически без информации, получаемой от систем транспортной аналитики, невозможно обоснованное принятие решений в интеллектуальной транспортной системе (ИТС), разработка которых является актуальной задачей по всему миру [1]. При этом важную роль в таких системах играет техническое зрение и алгоритмы обработки данных [2].

На рынке представлены готовые к использованию технические средства, однако качество решения мно- гих типовых задач, не говоря уже о перспективных, остается недостаточно высоким. Большое число ложных срабатываний и пропусков объектов интереса приводит к необходимости обеспечения существенной степени вовлеченности человека-оператора в процесс функционирования системы видеоаналитики. Более глубокий анализ позволяет заключить, что основные причины, приводящие к получению неудовлетворительных результатов работы систем транспортной аналитики, заключаются в следующем:

-

- многие алгоритмы анализа видеосюжетов недостаточно универсальны или же ориентированы на решение задач в узком диапазоне сцен и при особых условиях наблюдения [3, 4];

-

- после первоначальной настройки система не всегда способна корректно адаптироваться к изменению условий наблюдения;

-

- многие современные алгоритмы анализа видеосюжетов и изображений требуют чрезмерно большого объема вычислений, поэтому зачастую

им на практике предпочитают более простые и менее эффективные алгоритмы [5].

Построение системы транспортной аналитики предлагается осуществлять с использованием интеллектуальных камер, которые устанавливаются на необходимых участках дорог и связываются с центром управления движением (ЦУД). В таком случае работникам ЦУД ставятся следующие задачи: выполнить установку и первичную настройку камер, отслеживать ситуации внештатного отключения или поломки камер, обрабатывать получаемые статистические данные, принимать решения по управлению и организации дорожного движения, выполнять контроль работы ИТС.

Проблемы обработки всего объема видеоданных перекладываются на платформу интеллектуальных камер. Таким образом, при разработке упор делается на вычислительную эффективность алгоритмов, что не мешает их использованию в системах офлайн-обработки видеопоследовательностей, т.к. исследуется качество работы алгоритмов.

В качестве примера достаточно актуальных на сегодняшний день задач видеоаналитики можно рассмотреть обнаружение людей и транспортных средств и слежение за ними. Следует отметить, что в научной литературе рассматриваются способы построения принципиально новых алгоритмов анализа видео, выдвигаются интересные идеи, связанные со спецификой той или иной проблемы. Однако большинство работ рассматривают задачи обнаружения и слежения по отдельности и решают какую-то одну из них. В работе [6] решается задача подсчета количества людей в видеопоследовательности на основе детектора головы человека в толпе. В работе [7] предлагается использовать дополнительный датчик, генерирующий карту глубины сцены. Обнаружению транспортных средств посвящены такие работы, как [8, 9]. В то же время существует ряд работ, где слежение за абстрактными объектами рассмотрено в отрыве от задач обнаружения. К их числу относится подход, основанный на использовании венгерского алгоритма [10]. Имеются работы, в которых задачи обнаружения и слежения неразрывно связаны [11, 12]. Зачастую задача оценки параметров движущихся объектов не рассматривается, при этом и вопросы обеспечения приемлемой вычислительной сложности остаются без должного внимания [13– 15].

1. Базовый алгоритм обнаружения и оценки параметров объектов

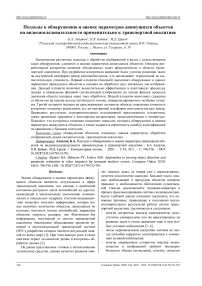

Решение задач обнаружения и оценки параметров объектов рассматривается для неподвижной камеры, установленной над дорогой. Разработанный алгоритм обнаружения и оценки параметров движущихся объектов (проезжающих автомобилей) предполагает задание контролируемой области на изображении (рис. 1).

На каждую полосу движения устанавливается своя контролируемая область. Каждая область делится на две зоны (зона въезда – Z1 и зона выезда – Z2).

Рис. 1. Пример установки контролируемой области

Подробно алгоритм был ранее представлен в работе [16]. Выделение транспортных средств (ТС) основано на методе вычитания из текущего изображения имеющейся оценки фона. При этом алгоритм должен обеспечивать приемлемую скорость обновления и адаптации оценки фона. Кратко рассмотрим основные идеи базового алгоритма.

Начальная оценка фона выполняется каждой зоной путем выделения точек движения на основе межкадровой разности. На данной стадии важно найти кадры, на которых отсутствует движение. Кроме того, работа зон синхронизируется с целью определения момента времени, когда автомобиль покинул зону въезда, а затем покинул зону выезда. Такая проверка необходима для исключения выбора опорного кадра во время остановки автомобиля.

Если в течение заданного малого промежутка времени в зоне нет движения, то выбирается опорный кадр для оценки фоновой составляющей. После нахождения опорного кадра на протяжении заданного интервала времени осуществляется проверка стабильности фона, для чего выполняется анализ разности опорного и текущего кадра.

Обновление оценки выполняется аналогично, но дополнительно учитывается получаемая при слежении информация об остановившемся ТС. Остановка ТС говорит об отсутствии необходимости вносить коррекцию в текущую оценку фона.

После первоначальной оценки фона контролируемая область переходит на этап основной работы, который также включает алгоритм выделения движущегося объекта на изображении, основанный на вычитании фона, пороговой обработке и последующем разбиении точек на 4 категории: объект, фон, тень, засветка. Точки последних двух категорий не рассматриваются. В итоге, исходя из числа точек объекта, фиксируются въезды/выезды ТС в / из зон.

Для избегания ложных обнаружений, во-первых, выполняется синхронизация работы двух зон, фактически проверяется, что основная часть точек, принадлежащих объекту, находилась в зоне выезда Z2 позже, чем в зоне въезда Z1. Соответствующие моменты времени фиксируются на этапе обновления фона. Во-вторых, подтверждением проезда ТС через контролируемую область может служить результат работы алгоритмов слежения, которые будут описаны ниже.

Количество ТС, проехавших через контролируемую область, увеличивается на основании решения алгоритма об обнаружении ТС. Скорость ТС v ТС вычисляется следующим образом:

v TC = d Z 1- Z 2 /( tt Z 2 in — tt Z 1in ) , (1)

где d Z 1- Z 2 – расстояние в метрах между зонами въезда Z1 и выезда Z2; tt Z 2 in – время въезда в зону Z2 в секундах; tt Z 1 in – время въезда в зону Z1 в секундах.

Длина ТС l ТС вычисляется следующим образом:

l TC = v TC ' ( tt Z 1 out — tt Z 1in ) , (2)

где tt Z 1 out – время выезда из зоны Z1 в секундах.

Классификация ТС производится по длине :

- ТС до 5 м (легковые);

- ТС от 5 до 7,5 м (грузовые и пассажирские средних габаритов);

- ТС длиннее 7,5 м (грузовые и пассажирские больших габаритов).

2. Алгоритм слежения на основе вычисления оптического потока2.1. Фильтрация отслеживаемых точек

Точность оценки параметров и, соответственно, классификации ухудшается из-за задержек в получении изображений с камеры, ошибок сегментации. С целью повышения точности предлагается использовать алгоритмы слежения, т.к. будет оцениваться межкадровое смещение точек или сегментов объекта.

Слежение начинается с кадра, на котором базовый алгоритм зафиксировал въезд объекта в зону Z1. Слежение выполняется в расширенной вдоль направления движения области, протяженность которой в 2– 3 раза больше, чем у контролируемой области.

Первым этапом алгоритма является инициализация, заключающаяся в формировании списка особых точек объекта. Использование особых точек обусловлено существенным уменьшением вычислительных затрат при вычислении оптического потока по срав- нению с использованием всех точек объекта. Для выделения особых точек можно воспользоваться одним из известных детекторов, при этом вычисление дескрипторов не требуется. При проведении исследований использовался детектор ORB [17].

Основной этап алгоритма слежения заключается в вычислении оптического потока для найденного набора точек объекта. На данном этапе применяется пирамидальный алгоритм Лукаса–Канаде [18]. В алгоритме выполняется последовательное уточнение оценок скорости оптического потока при переходе от самого высокого до самого низкого уровня представления изображения в многомасштабной пирамиде. Сначала рассматривают изображение с самым грубым разрешением. Максимальное движение на низком разрешении, как правило, происходит в пределах нескольких точек. При поиске на более детальном уровне учитывают полученную ранее оценку сдвига, корректируют положение окна и оценивают скорость оптического потока на более детальном изображении. Это позволяет постепенно получать более точную оценку сдвига изображения в пределах размеров окна. Процедуру выполняют до перехода к самому детальному представлению изображения. При невозможности получения решения системы уравнений увеличение детальности изображения может быть приостановлено. Данная ситуация происходит, если окрестность точки более не является уникальной либо становится заметным влияние шума.

Пирамидальный алгоритм Лукаса–Канаде позволяет получить хорошие оценки смещения точек при заметных межкадровых смещениях объекта. Однако необходима дополнительная процедура фильтрации точек, т.к. при изменении локальной освещенности и ракурса наблюдения объекта слежение может быть нестабильным, часть точек будет уходить с истинной траектории движения.

Фильтрация отслеживаемых точек производится после оценки их нового положения пирамидальным алгоритмом Лукаса–Канаде, при этом используется информация об изменении траекторных параметров точек и самого объекта.

Алгоритм фильтрации на текущ ем t -м кадре состоит из следующих этапов:

-

1) Проверка числа точек n kp , для которых алгоритм Лукаса–Канаде успешно выполнил оценк у смещения. Если n kp = 0, то алгоритм слежения прекращает свою работу (объект потерян).

-

2) Иначе ( n kp > 0) выполняется расчет для каждой точки следующих параметров:

-

2.1) Смещение в пространстве по двум координатам: Δ x ( t ) = x ( t ) – x ( t –1) и Δ y ( t ) = y ( t ) – y ( t –1).

-

2.2) Флаги δ x ( t ) и δ y ( t ) направления смещения точки. На примере координаты x :

-

0, если | А х ( t )| <А d pt ,

3 х ( t ) = ^

- 1, иначе, если А х ( t ) < 0,

1, иначе,

а ( t ) =

где Δ d pt – минимальное смещение отслеживаемой точки в пикселях для принятия решения о ее передвижении (иначе остановка).

-

2.3) Угол направления движения:

-

0, если 5 х ( t ) = 0 и 5 y ( t ) = 0,

-

2.4) Расстояние d ( t ) = ^А х 2 ( t ) + А у 2 ( t ).

-

2.5) Скорость в пикселях в секунду: v ( t ) = d ( t ) / Δ tt , Δ tt = tt ( t ) – tt ( t –1), где tt – время получения соответствующего кадра.

-

2.6) Обновление счетчика кадров слежения N tr и счетчика кадров после остановки ТС N st . Увеличение суммы скоростей при слежении S tr и суммы скоростей после остановки ТС S st на v ( t ).

t —А У ( t ) (4) arctg , иначе.

А х ( t )

-

3) Подсчет числа точек, остановившихся ( ns x и ns y ) и переместившихся вперед ( nf x и nf y ) или назад ( nb x и nb y ) по каждой координате путем проверки значений флагов δ x ( t ) и δ y ( t ): 0 – остановка, 1 – движение вперед, –1 – движение назад.

-

4) Расчет порогового значения для определения состояния объекта:

T o = k pt " n kp , (5)

где k pt – коэффициент для определения минимального числа отслеживаемых точек для принятия решения о направлении движения и отсеивании точек, сместившихся в другом направлении.

-

5) Если ns x > τ o и ns y > τ o , то выполняется «Алгоритм фильтрации точек остановившегося объекта» (представлен ниже).

-

6) Иначе (объект продолжает движение) выполняется «Алгоритм фильтрации точек движущегося объекта» (представлен ниже).

-

7) На первом кадре работы алгоритма слежения выполняется расчет минимального числа отслеживаемых точек для принятия решения о продолжении слежения:

T kp = k lost ' n kp , (6)

где k lost – коэффициент для определения минимального числа отслеживаемых точек для принятия решения о продолжении слежения (иначе принимается решении о потере объекта); n kp -оставшееся число отслеживаемых точек после работы того или иного алгоритма фильтрации.

Алгоритм фильтрации точек остановившегося объекта состоит из следующих этапов:

-

1) Если число кадров, на которых определено движение объекта, меньше 2, то алгоритм слежения прекращает свою работу (ложное обнаружение).

-

2) Иначе переменные N st и S st устанавливаются равными 0 для всех точек, и в дальнейшем слежение будет выполняться только за точками, которые удовлетворяют условию | А х | < 2 А dpt | и | А у | < 2 А d pt | .

Алгоритм фильтрации точек движущегося объекта состоит из следующих этапов:

-

1) Отбрасывание «остановившихся» точек, для которых δ x ( t ) = 0 и δ y ( t ) = 0.

-

2) Если установлен флаг наличия оцененного угла α et направления движения объектов через область, то выполняется фильтрация точек по значению угла α( t ) направления смещения точек. Остаются точки, удовлетворяющие условию а ( t )< а et + Аа et и а ( t )> а et - Аа et , где Аа et задает диапазон отклонения угла направления движения точек от эталонного направления.

-

3) Если флаг наличия оцененного угла α et не установлен, то выполняется фильтрация точек по значениям δ x ( t ) и δ y ( t ):

-

3.1) Фильтрация по δ x ( t ). Определение приоритетного направления δ xEt , принимающего одно из значений 0 – остановка, 1 – движение вперед, –1 – движение назад, исходя из n xEt = max{ ns x , nf x , nb x }. Если n xEt > τ o , то условием сохранения точки является δ x ( t ) = δ xEt .

-

3.2) Фильтрация по δ y ( t ) производится таким же образом, как и для δ x ( t ), но с учетом значений ns y , nf y , nb y .

-

-

4) Отбрасывание точек, межкадровое перемещение d ( t ) которых значительно отличается от перемещения большинства точек, путем решения задачи минимизации функции:

n kp

J = £ | d , .( t ) -ц ( d )^ (7)

i = 1

где i - номер точки; n' kp - текущее число точек; t – номер кадра; μ( d ) – среднее перемещение точек в пикселях.

Критерием останова является условие n'kp = 0 или σ( d ) < σ d 1 , где σ( d ) – СКО смещения точек в пикселях; σ d 1 – максимальное СКО смещения точек в пикселях для отсеивания отслеживаемых точек, смещение которых принимается аномальным.

Точки со сравнительно большим значением d ( t ) отбрасываются, и пересчитываются μ( d ) и σ( d ).

-

5) Если число кадров выполнения слежения больше 1, то:

-

5.1) Расчет угла направления движения объекта через область:

, 1 y i (0) - y i ( t )

a e, = ■ £ arctg

n kp I = 1 x i( t) - x i (0)

.

– если флаг наличия оцененного угла α et не установлен, то флаг устанавливается и a « =a' el ,

-

- иначе a et = ( a et + a'el ) /2.

6) Если n'kp > т kp (минимальное число отслеживаемых точек), то фиксируется движение объекта, и слежение буд ет продолжено на следующем кадре. Иначе алгоритм слежения прекращает свою работу (объект потерян).

-

6.1) Вычисление временной разницы между моментом выезда объекта из зоны Z1 и моментом потери объекта Δ tt = tt out 1 – tt t к .

-

6.2) Если объект останавливался в процессе движения, т.е. N st > 0, то

v ,= 1 ■^ n p S $t ( i )

n kp £ N st ( i ),

иначе v ' = v TC .

6.3) Пересчет длины объекта:

1 тс — 1 тс + ^ ■ A tt .

2.2. Оценка параметров объекта

Процесс слежения может быть завершен или потерей объекта (досрочно), или в момент выезда объекта из зоны Z1 контролируемой области. По окончании процесса слежения за объектом можно выполнить оценку его параметров:

1) Вычисление координат начального положения объекта ( x ц 0 , y ц 0 ):

( x ц 0 , y ц 0 )

^ n kp n kp ^

£ X i (0) £ y i (0) i = 1 i = 1 , n ‘n n ‘n

kp kp

2) Вычисление координат конечного положения объекта ( x ц , y ц ):

( x ц , y ц )

Z n kp n kp ^

£ x i ( t k ) £ y i( t k ) i = 1 i = 1

4 n kp n kp ?

где t к – номер последнего кадра, на котором выполнялось слежение.

-

3) Вычисление координат ( x out 1 , y out 1 ) точки пересечения линии выезда из зоны Z1 и прямой, проходящей через точки ( x ц 0 , y ц 0 ) и ( x ц , y ц ).

-

4) Оценка скорости объекта:

1 ■ £ S tr ( i ) n kp £ N r ( i ).

5) Оценка длины объекта:

1 n kp

1 тс = ■ £ V( X i ( t k ) - X out 1 )2 + ( y i ( t k ) - y out 1 )2. (12)

nkp I = 1

6) Если слежение было завершено потерей объекта, то выполняется уточнение длины объекта путем прогнозирования его положения.

3 . Алгоритм прослеживания сегментов объекта

Алгоритм прослеживания сегментов объекта является альтернативой алгоритму слежения на основе вычисления оптического потока, обладающей меньшей вычислительной сложностью. Данный алгоритм начинает работу также с кадра, на котором базовый алгоритм обнаружения объекта зафиксировал въезд в зону Z1. Слежение за объектом выполняется в контролируемой области. Входными данными являются бинарные изображения B Z 1 и B Z 2 для зон Z1 и Z2 соответственно, полученные на этапе сегментации в базовом алгоритме. С целью повышения качества сегментации предлагается обрабатывать цветное изображение.

Алгоритм прослеживания сегментов объекта можно разделить на следующие этапы:

-

- инициализация алгоритма в момент фиксации въезда в зону Z1 контролируемой области;

-

- слежение за сегментом объекта при передвижении через зону Z1;

-

- слежение за сегментом объекта при передвижении через зоны Z1 и Z2;

-

- оценка параметров объекта по окончании слежения.

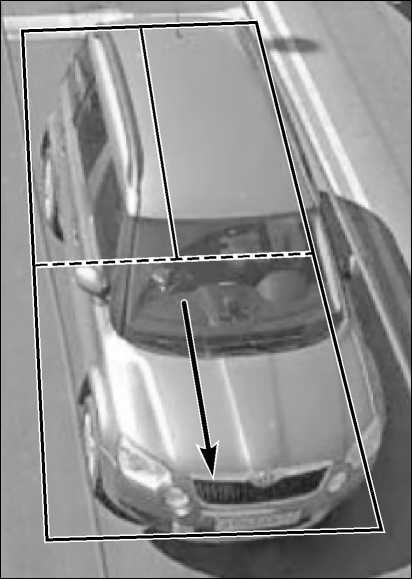

На рис. 2 представлен пример движения объекта (его сегментов) через контролируемую область.

Рис. 2. Движение объекта через контролируемую область

3.1. Повышение качества сегментации

На работу алгоритма влияет качество сегментации наблюдаемого изображения, заключающейся в пороговой обработке разностного изображения с разбиением точек на 4 категории: объект, фон, тень, засветка [16]. Важной частью сегментации является получение разницы между текущим кад-

-

-

ром и фоном. В простейшем случае обрабатывается изображение в оттенках серого, тогда значение Δ ц точки разностного изображения можно найти достаточно просто:

А ц = | > -1 - У 2,

где y 1 и y 2 – интенсивности отдельно взятой точки текущего кадра и фона соответственно.

При сегментации такого разностного изображения теряется важная информация о цвете. Проблему можно решить при захвате цветного изображения, например, в пространстве RGB. Вычисление квадрата разницы запишем в следующем виде.

А Ц = ( Г - Г ) 2 + ( g 1 - g 2 ) 2 + ( b - b 2 ) 2 , (16)

где r , g и b – интенсивности отдельно взятой точки для компонент R, G и B соответственно.

Захват цветного изображения на интеллектуальной камере производится в цветовом пространстве YUV, поэтому Δ ц вычисляется по формуле (16) с уч етом преобразования из цветового пространства YUV в RGB. Запишем конечные выражения для получения разницы с использованием значений y , u и v компонент Y, U и V соответственно:

П о = 298 • ( у - У 2 ),

П 1 =П о + 409 • ( V 1 - v 2 ),

П 2 = П о - 100 • ( U 1 - и 2 ) - 208 • ( V 1 - v 2 ), (17)

П з =П 0 + 516 • ( U 1 - и 2 ),

А Ц = ( п 2 +п 2 +П 2 ) /65536.

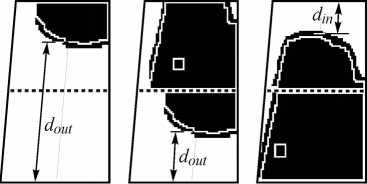

Результат сегментации исходного изображения (рис. 3 а ) в оттенках серого (рис. 3 б ) и в цветном формате (рис. 3 в ) проиллюстрирован ниже.

а)

ОР» [ I

б) в)

Рис. 3. Результат сегментации изображения

-

3.2. Инициализация алгоритма слежения

Инициализация включает следующие этапы:

-

1) Постобработка результатов сегментации: дилатация и эрозия бинарного изображения B Z 1 .

-

2) Разметка и параметризация бинарного изображения с целью определения числа точек каждого сегмента, а также координат углов описывающих сегменты прямоугольников.

-

3) Объединение всех сегментов, число точек которых больше заданного порога.

-

4) Если не найден ни один сегмент подходящего размера, то слежение не производится (ложное обнаружение) – конец алгоритма.

-

5) Оконтуривание сегмента объекта. Получение бинарного контурного изображения C Z 1 .

-

6) Вычисление расстояния d in между объектом и линией въезда в Z1, т.е. минимального расстояния от точек C Z 1 , равных 1, до соответствующей прямой.

-

7) Вычисление расстояния d out между объектом и линией выезда из Z2, т.е. минимального расстояния от точек C Z 1 , равных 1, до соответствующей прямой.

-

8) Если d in > ε d или d out < l zp + ε d , то слежение не производится (ложное обнаружение), иначе начинается основная работа алгоритма в состоянии «Слежение Z1». ε d – величина погрешности в пикселях при сравнении двух расстояний до линии въезда или выезда из зон контролируемой области, l zp – длина зоны в пикселях.

-

3.3. Слежение за сегментом объекта в зонах

Основная работа алгоритма прослеживания сегментов состоит из следующих этапов:

-

1) Обработка бинарного изображения B Z 1 путем выполнение этапов 1–7 алгоритма «Инициализация алгоритма слежения» , описанного выше. В случае отсутствия сегментов слежение прекращается, иначе получаем значения d in и d out .

-

2) Операции при состоянии «Слежение Z1» (движение через зону Z1) и при выполнении условия d out < l zp + ε d :

-

2.1) Если алгоритм слежения работал менее 1 кадра, то слежение далее не производится (ложное обнаружение) – конец алгоритма.

-

2.2) Иначе обработка бинарного изображения B Z 2 (зона Z2) путем выполнения этапов 1–5 алгоритма «Инициализация алгоритма слежения» . Результат – бинарное контурное изображение C Z 2 .

-

2.3) Если не был выделен сегмент объекта на изображении B Z 2 , то сохраняется состояние «Слежение Z1» и переход на этап 4.

-

2.4) Иначе на основе C Z 2 вычисляется расстояние d in 2 между объектом и линией въезда в Z2.

-

2.5) Если d in 2 > ε d , то сохраняется состояние «Слежение Z1» и переход на этап 4.

-

2.6) Иначе на основе C Z 2 вычисляется расстояние d out 2 между объектом и линией выезда из Z2.

-

2.7) Если d out 2 < ε d , то сохраняется состояние «Слежение Z1» и переход на этап 4.

-

2.8) Иначе d out = d out 2 ; сохраняется номер текущего кадра как t Z 2 in ; переход в состояние «Слежение Z1 – Z2».

-

-

3) Операции при состоянии «Слежение Z1 – Z2» (движение одновременно через зоны Z1 и Z2):

-

3.1) Обработка бинарного изображения B Z 2 (зона Z2) путем выполнения этапов 1–5 алгоритма

-

-

3.2) Если не было выделено сегмента объекта на изображении B Z 2 , то удаляются данные о траектории, начиная с кадра t Z 2 in ; переход в состояние «Слежение Z1»; переход на этап 4.

-

3.3) Иначе на основе C Z 2 вычисляется расстояние d out между объектом и линией выезда из Z2.

«Инициализация алгоритма слежения» . Результат – бинарное контурное изображение C Z 2 .

-

4) Расчет данных о траектории движения на текущем кадре t .

-

4.1) Расстояние до линии въезда в Z1:

-

-

4.2) Разница расстояний до линии въезда в Z1:

-

4.3) Расстояние до линии выезда из Z2:

, , . [-1, если din [ din, иначе. |-1, если d,„ (t) < ed или d,„ (t -1) (din (t) - din (t -1), иначе. f-1, если dout < ed или dout (t -1) < ed, dout (t) = 1 , (20) [ dout, иначе. 4.4) Разница расстояний до линии выезда из Z2: A out -1, если dout (t) < ed или dout (t -1) < ed dout (t) - dout (t -1), иначе. 4.5) Определение состояния объекта so: «Движ.» или «Стоп» по порогу Δds (минимальное смещение сегмента в пикселях для принятия решения о его передвижении): – если Δin< 0 и Δout< 0, то so = «Движ.»; – если Δin > Δds или Δout > Δds, то so = «Движ.»; – в остальных случаях so = «Стоп». 4.6) Если din(t) > εd и dout(t) > εd, то рассчитанные параметры din(t), dout(t), Δin и Δout сохраняются. 5) Если din(t) > kz1out ∙ lzp, то слежение прекращается (окончание слежения при достаточном отдалении объекта от линии въезда), где kz1out – коэффициент для определения минимального расстояния между объектом и линией въезда в Z1 для принятия решения о покидании объектом этой зоны. 3.4. Оценка параметров объекта Слежение может быть завершено в момент выезда объекта из зоны Z1. Решение о возникновении данной ситуации принимается или самим алгоритмом слежения, или базовым алгоритмом. По окончании слежения можно выполнить оценку параметров, вычислив сумму оценок скоростей Sv, число кадров с оценкой скорости Nv, сумму оценок длинны Sl, число кадров с оценкой длины Nl: 1) На кадрах, где Δin(t) > 0 и Δout(t) > 0: 1.1) Увеличение Nv на 1. 1.2) Увеличение Sv на оценку скорости v(t): v (t) = (Ain (t) + A out (t))/(2 -Att), Att = tt(t) - tt(t -1), где tt – время получения соответствующего кадра. 2) На кадрах, где din(t) > 0 и dout(t) > 0: 2.1) Увеличение Nl на 1. 2.2) Увеличение Sl на оценку длины l(t): l(t) = 2 - lzp - din (t) - dout (t). (23) 3) Оценка скорости объекта: vТС = Sv / Nv. 4) Оценка длины объекта: lТС = Sl / Nl. Экспериментальные исследования предложенных подходов к обнаружению и оценке параметров ТС проводились как с использованием записанных натурных видеосюжетов, так и на внутренней платформе интеллектуальных видеокамер при наблюдении за разными участками дорог в режиме реального времени. Исследования включали оценку и сравнение качества работы всех предлагаемых алгоритмов: базового алгоритма обнаружения объектов, с использованием слежения на основе оптического потока и с использованием слежения за сегментами. Исследования проводились на базе собственных видеосюжетов, а также на сюжетах из открытых баз GRAM [19] и CDNet 2014 [20]. При проведении исследований использовались сюжеты, записанные неподвижной камерой при наблюдении за дорожно-транспортной обстановкой, при этом число полос составляет от 2 до 5. Для разработанных алгоритмов на каждую полосу устанавливалась контролируемая область. Проводилось сравнение с результатами известных алгоритмов, для которых области интереса не устанавливались, а выполнялась обработка всего участка изображения, охватывающего полосы движения. Примеры сюжетов из собственной базы (рис. 4а), базы GRAM (рис. 4б) и базы CDNet 2014 (рис. 4в) проиллюстрированы ниже. Для каждого сюжета известно общее число ТС, а также число ТС разных типов. Алгоритмы в процессе работы выполняли подсчет проезжающих объектов. В результате обработки всего сюжета подсчитывались следующие значения: nВО – число верно обнаруженных объектов; nЛО – число ложных обнаружений; nП – число необнаруженных объектов (пропусков). Для сравнения с алгоритмами обнаружения объектов, представленными в литературе, по полученным для сюжета nВО, nЛО, nП вычислялись точность (precision, p), полнота (recall, r) и производный показатель: F-мера [21]. В табл. 1 представлены усредненные по разным базам результаты экспериментальных исследований. Усредненные результаты оценки качества классификации объектов приведены в табл. 2. Рассматривались 3 класса автомобилей: легковые (до 5 м), сред- ние грузовые и пассажирские (от 5 м до 7,5 м) и большие грузовые и пассажирские (больше 7,5 м). а) б) в) Рис. 4. Примеры обрабатываемых сюжетов Табл. 1. Сравнение алгоритмов обнаружения и оценки параметров объектов База Алгоритм Всего ТС nВО nЛО nП p r F Собственная Базовый 4393 3967 56 426 0,986 0,903 0,943 + прослеживание сегментов 4218 27 175 0,994 0,960 0,977 + оптический поток 4201 14 192 0,997 0,956 0,976 GRAM Базовый 480 474 3 6 0,994 0,988 0,991 + прослеживание сегментов 478 2 2 0,996 0,996 0,996 + оптический поток 478 2 2 0,996 0,996 0,996 CDNet 2014 Базовый 82 78 2 4 0,975 0,951 0,963 + прослеживание сегментов 81 0 1 1 0,988 0,994 + оптический поток 82 1 0 0,988 1 0,994 Всего Базовый 4955 4519 61 436 0,986 0,912 0,948 + прослеживание сегментов 4777 29 178 0,994 0,964 0,979 + оптический поток 4761 17 194 0,996 0,961 0,978 Табл. 2. Сравнение качества классификации База Алгоритм Число < 5 м Число 5-7,5 м Число > 7,5 м Обнаружено Число ошибок Доля ошибок Собственная Базовый 3450 713 230 3967 667 16,8% + прослеживание сегментов 4218 391 9,3 % + оптический поток 4201 529 12,6% GRAM Базовый 445 30 5 474 63 13,3% + прослеживание сегментов 478 20 4,2% + оптический поток 478 29 6,1 % CDNet 2014 Базовый 79 3 0 78 4 5,1% + прослеживание сегментов 81 10 12,3% + оптический поток 82 4 4,9 % Всего Базовый 3974 746 235 4519 734 16,2 % + прослеживание сегментов 4777 421 8,8 % + оптический поток 4761 562 11,8 % Сравнение с результатами обнаружения и подсчета ТС, полученными известными алгоритмами, проводилось с использованием данных, приведенных в работе [21]. Участвуют следующие подходы: 1) Алгоритм обнаружения и слежения за объектами на основе адаптивной оценки фона с использованием смеси гауссиан [22]. 2) Алгоритм обнаружения объектов на основе оценки фона методом GoDecomposition: рандомизированное разложение матриц [23]. 3) Алгоритм обнаружения движущихся объектов методом Decolor (detecting contiguous outliers in the low-rank representation) [24]. 4) Алгоритм обнаружения движущихся объектов методом Corola (contiguous outliers representation via online low-rank approximation) [25]. 5) Алгоритм обнаружения объектов на основе оценки фона методом Incremental PCP (principal component pursuit) [26]. 6) Алгоритм подсчета ТС на основе модифицированного метода PCP [27]. 7) Алгоритм слежения и подсчета ТС на основе фильтра частиц [28]. 8) Алгоритм обнаружения и слежения за объектами на основе разложения матриц и фильтра Калмана [21]. Сравнение разработанных алгоритмов с работами [21, 27, 28] произведено по доле верно обнаруженных объектов (Pвo – отношение числа верно обнаруженных объектов к эталонному общему числу объектов) при обработке сюжетов M-30 и M-30-HD из базы GRAM, результаты представлены в табл. 3. Табл. 3. Сравнение с представленными в литературе алгоритмами по доле верно обнаруженных объектов Алгоритм Сюжет, Pвo M-30 M-30-HD Базовый 0,986 0,987 + прослеживание сегментов 0,996 0,995 + оптический поток 0,996 0,995 [21] 0,922 0,881 [27] 0,974 0,929 [28] 0,896 0,786 В табл. 4 приведены показатели качества для предложенных алгоритмов и алгоритмов, представленных в работах [21–26]. Сравнение приводится по усредненным по всем сюжетам показателям точности (precision, p), полноты (recall, r) и F-меры. При проведении испытаний на интеллектуальных камерах Axis с процессорами ARTPEC-5 было измерено среднее время обработки кадра с размером 640×360 пикселей и 4 полосами движения. Для базового алгоритма среднее время составило 12 мс. Среднее время для алгоритма с прослеживанием сегментов – 25 мс. Среднее время для алгоритма с применением оптического потока – 250–1500 мс. Табл. 4. Сравнение с представленными в литературе алгоритмами по точности, полноте и F-мере Алгоритм p r F Базовый 0,986 0,912 0,948 + прослеживание сегментов 0,994 0,964 0,979 + оптический поток 0,996 0,961 0,978 [21] 0,895 0,963 0,928 [22] 0,004 0,568 0,008 [23] 0,009 0,212 0,017 [24] 0,584 0,861 0,696 [25] 0,697 0,803 0,747 [26] 0,512 0,407 0,454 Заключение Результаты экспериментальных исследований показали, что базовый подход к обнаружению и оценке параметров объектов позволяет обнаруживать 91 % транспортных средств, доля пропусков и ложных обнаружений составила 10 %, а доля ошибок классификации – 16%. При использовании слежения число верно обнаруженных объектов увеличилось примерно на 5% при уменьшении числа ошибок на 6%. Также сократилась вероятность ошибок классификации на 5–7%, что позволяет сделать вывод о повышении точности оценки таких параметров, как длина и скорость транспортного средства. Алгоритм на основе слежения за сегментами позволяет добиться результатов, сравнимых со слежением на основе метода оптического потока, который более требователен к вычислительным ресурсам. При этом для использования оптического потока необходимо задать увеличенную область обработки, что накладывает дополнительные требования к установке камеры и контролируемых областей. Сравнение разработанных алгоритмов с представленными в литературе показало эффективность предлагаемых подходов. Следует отметить, что задачей известных подходов является анализ сцены в целом, тогда как предложенные позволяют проводить анализ по каждой полосе движения, к тому же уделено большее внимание оценке параметров объектов. Разработанные подходы к обнаружению, слежению и оценке параметров движущихся объектов позволяют решать поставленные задачи при наблюдении за многополосным участком дороги и могут быть применены в системе транспортной аналитики. Исследования выполнены при финансовой поддержке стипендии Президента Российской Федерации молодым ученым и аспирантам (СП-2578.2018.5).

Список литературы Подходы к обнаружению и оценке параметров движущихся объектов на видеопоследовательности применительно к транспортной аналитике

- The future of road transport: implications of automated, connected, low-carbon and shared mobility / Joint Research Centre. - Luxembourg: Publications Office of the EU, 2019. - 148 p. - 978-92-76-14319-2. ISBN: 978-92-76-14319-2

- Husain, A.A. Vehicle detection in intelligent transport system under a hazy environment: a survey / A.A. Husain, T. Maity, R.K. Yadav // IET Image Processing. - 2020. - Vol. 14, Issue 1. - 10 p. - DOI: 10.1049/iet-ipr.2018.5351

- Deshpande, S.D. Max-mean and max-median filters for detection of small-targets / S.D. Deshpande, M.H. Er, V. Ronda, P. Chan // Proceedings of SPIE. - 1999. - Vol. 3809. - P. 74-83. DOI: 10.1117/12.364049

- Ваниев, А.А. Метод выделения быстродвижущихся объектов при использовании цифрового оптического локатора следящего типа / А.А. Ваниев, Г.М. Емельянов // Компьютерная оптика. - 2013. - № 37(4). - С. 477-483.

- Копенков, В.Н. Оценка параметров транспортного потока на основе анализа данных видеорегистрации / В.Н. Копенков, В.В. Мясников // Компьютерная оптика. - 2014. - № 38(1). - С. 81-86.

- Subburaman, V.B. Counting people in the crowd using a generic head detector / V.B. Subburaman, A. Descamps, C. Carincotte // 2012 IEEE Ninth International Conference on Advanced Video and Signal-Based Surveillance. - 2012. - P. 470-475. -

- DOI: 10.1109/AVSS.2012.87

- Kirchner, N. A robust people detection, tracking, and counting system / N. Kirchner, A. Alempijevic, A. Virgona, X. Dai, P.G. Ploger, R.V. Venkat // Proceedings of Australasian Conference on Robotics and Automation. - 2014. - 8 p.

- Han, S. Vehicle detection method using Haar-like feature on real time system / S. Han, Y. Han, H. Hahn // International Journal of Electrical and Computer Engineering. - 2009. - Vol. 3, Issue 11. - P. 1957-1961.

- Wang, H. A hybrid method of vehicle detection based on computer vision for intelligent transportation system / H. Wang, H. Zhang // International Journal of Multimedia and Ubiquitous Engineering. - 2014. - Vol. 9, Issue 6. - P. 105-118. -

- DOI: 10.14257/ijmue.2014.9.6.11

- Nandashri, D. An efficient tracking of multi object visual motion using Hungarian method / D. Nandashri, P. Smitha // International Journal of Engineering Research & Technology. - 2015. - Vol. 4. - P. 1307-1310. -

- DOI: 10.17577/ijertv4is041410

- Andriluka, M. People-tracking-by-detection and people-detection-by-tracking / M. Andriluka, S. Roth, B. Schiele // Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). - 2008. - 8 p. -

- DOI: 10.1109/CVPR.2008.4587583

- Dehghan, A. Automatic detection and tracking of pedestrians in videos with various crowd densities / A. Dehghan, H. Idrees, A.R. Zamir, M. Shah. - In: Pedestrian and evacuation dynamics / ed. by U. Weidmann, U. Kirsch, M. Schreckenberg. - Cham: Springer, 2012. - P. 3-19. -

- DOI: 10.1007/978-3-319-02447-9_1

- Алпатов, Б.А. Выделение движущихся объектов в условиях геометрических искажений изображения / Б.А. Алпатов, П.В. Бабаян // Цифровая обработка сигналов. - 2004. - № 4. - С. 9-14.

- Трифонов, А.П. Обнаружение движущегося с произвольной скоростью объекта при неизвестных интенсивностях изображения и фона / А.П. Трифонов, Р.В. Куцов // Автометрия. - 2006. - № 4. - С. 3-16.

- Bouwmans, T. Traditional and recent approaches in background modeling for foreground detection: an overview / T. Bouwmans // Computer Science Review. - 2014. - Vol. 11-12. - P. 31-66. -

- DOI: 10.1016/j.cosrev.2014.04.001

- Alpatov, B.A. Vehicle detection and counting system for real-time traffic surveillance / B.A. Alpatov, P.V. Babayan, M.D. Ershov // 2018 7th Mediterranean Conference on Embedded Computing (MECO). - 2018. - P. 120-123. -

- DOI: 10.1109/MECO.2018.8406017

- Rublee, E. ORB: An efficient alternative to SIFT or SURF / E. Rublee, V. Rabaud, K. Konolige, G.R. Bradski // International Conference on Computer Vision. - 2011. - P. 2564-2571. -

- DOI: 10.1109/ICCV.2011.6126544

- Babayan, P.V. Real-time pyramidal Lukas-Kanade tracker performance estimation / P.V. Babayan, S.A. Buiko, L.A. Vdovkin, M.D. Ershov, V.S. Muraviev, A.V. Sirenko, S.A. Smirnov // Proceedings of SPIE. - 2019. - Vol. 10996. - 10996OL. -

- DOI: 10.1117/12.2519274

- Guerrero-Gomez-Olmedo, R. Vehicle tracking by simultaneous detection and viewpoint estimation / R. Guerrero-Gomez-Olmedo, R.J. Lopez-Sastre, S. Maldonado-Bascon, A. Fernandez-Caballero. - In: Natural and artificial computation in engineering and medical applications (IWINAC 2013) / ed. by V.J.M. Ferrández, J.R. Álvarez Sánchez, F. de la Paz López, F.J. Toledo Moreo. - 2013. - Vol. 7931. - P. 306-316. -

- DOI: 10.1007/978-3-642-38622-0_32

- Wang, Y. CDnet 2014: an expanded change detection benchmark dataset / Y. Wang, P.-M. Jodoin, F. Porikli, J. Konrad, Y. Benezeth, P. Ishwar // 2014 IEEE Conference on Computer Vision and Pattern Recognition Workshops. - 2014. - P. 393-400. -

- DOI: 10.1109/CVPRW.2014.126

- Yang, H. Real-time vehicle detection and counting in complex traffic scenes using background subtraction model with low-rank decomposition / H. Yang, S. Qu // IET Intelligent Transport Systems. - 2018. - Vol. 12, Issue 1. - P. 75-85. -

- DOI: 10.1049/iet-its.2017.0047

- Stauffer, C. Adaptive background mixture models for real-time tracking / C. Stauffer, W. Grimson // Proceedings of the 1999 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. - 1999. - Vol. 2. - P. 246-252. -

- DOI: 10.1109/CVPR.1999.784637

- Zhou, T. GoDec: Randomized low-rank and sparse matrix decomposition in noisy case / T. Zhou, D. Tao // Proceedings of the 28th International Conference on Machine Learning. - 2011. - P. 33-40.

- Zhou, X. Moving object detection by detecting contiguous outliers in the low-rank representation / X. Zhou, C. Yang, W. Yu // IEEE Transactions on Pattern Analysis and Machine Intelligence. - 2013. - Vol. 35, Issue 3. - P. 597-610. -

- DOI: 10.1109/TPAMI.2012.132

- Shakeri, M. COROLA: A sequential solution to moving object detection using low-rank approximation / M. Shakeri, H. Zhang // Computer Vision and Image Understanding. - 2016. - Vol. 146. - P. 27-39. -

- DOI: 10.1016/j.cviu.2016.02.009

- Rodriguez, P. Incremental principal component pursuit for video background modeling / P. Rodriguez, B. Wohlberg // Journal of Mathematical Imaging and Vision. - 2016. - Vol. 55. - 18 p. -

- DOI: 10.1007/s10851-015-0610-z

- Quesada, J. Automatic vehicle counting method based on principal component pursuit background modeling / J. Quesada, P. Rodriguez // 2016 IEEE International Conference on Image Processing (ICIP). - 2016. - P. 3822-3826. -

- DOI: 10.1109/ICIP.2016.7533075

- Bouvie, C. Tracking and counting vehicles in traffic video sequences using particle filtering / C. Bouvie, J. Scharcanski, P. Barcellos // 2013 IEEE International Instrumentation and Measurement Technology Conference (I2MTC). - 2013. - P. 812-815. -

- DOI: 10.1109/I2MTC.2013.6555527