Выбор метода бинарной классификации при технической диагностике с применением машинного обучения

Автор: Клячкин Владимир Николаевич, Кувайскова Юлия Евгеньевна, Жуков Дмитрий Александрович

Журнал: Известия Самарского научного центра Российской академии наук @izvestiya-ssc

Рубрика: Информатика, вычислительная техника и управление

Статья в выпуске: 4-3 т.20, 2018 года.

Бесплатный доступ

Для проведения технической диагностики могут быть использованы различные методы машинного обучения. Основная задача бинарной классификации применительно к диагностике технических объектов - определить по заданным параметрам функционирования объекта, является ли он исправным. Предполагается, что имеется множество прецедентов: ситуаций с заданными параметрами функционирования и известным состоянием объекта. Задача разделения объектов на два класса - исправных и неисправных, может быть решена как с применением классических статистических методов, например, дискриминантного анализа, так и с использованием современных компьютерных технологий, основанных на методах машинного обучения. Можно попытаться построить композиции различных алгоритмов. Опыт показывает, что два главных метода построения композиции - бэггинг и бустинг - дают значительно более точный результат, чем применение отдельного алгоритма на конкретном наборе данных. При этом качество бинарной классификации (состояние объекта работоспособное или неработоспособное) оценивается по различным критериям: проценту ошибок в контрольной выборке, F-мере и критерию AUC-ROC - площади под кривой ошибок. Рассматривается задача выбора наилучшего метода классификации по заданному критерию.

Техническая диагностика, машинное обучение, бинарная классификация, меры качества

Короткий адрес: https://sciup.org/148312509

IDR: 148312509 | УДК: 681.518.5

Текст научной статьи Выбор метода бинарной классификации при технической диагностике с применением машинного обучения

Работа выполнена при поддержке гранта РФФИ и Правительства Ульяновской области, проект 18-48-730001

Диагностика состояния технического объекта проводится для повышения его надёжности. Под распознаванием понимают отнесение состояния объекта к одному из классов – диагнозов. Часто решение задачи сводится к разделению состояний объекта на работоспособное и неработоспособное. Это задача бинарной классификации и может решаться как классическими статистическими методами (например, с применением байесовского классификатора, или дискриминантного анализа Фишера), так и методами машинного обучения.

Диагностика проводится по результатам контроля косвенных показателей функционирования объекта в процессе эксплуатации [1]. При этом всегда имеется риск ложной тревоги (исправный объект будет признан неисправным) или, наоборот, (пропуск цели), когда неисправность объекта не выявлена.

В качестве исходных данных рассматриваются результаты оценки состояния объекта

(при заданных значениях контролируемых показателей техническая система работоспособна или неработоспособна). Существует некоторая неизвестная зависимость между показателями функционирования объекта и его состояниями. На основе выборки исходных данных требуется восстановить зависимость, то есть построить алгоритм, способный для заданного набора показателей функционирования объекта выдать достаточно точный ответ о его состоянии.

Цель исследования – разработать технологию поиска наилучшего метода классификации состояний объекта.

Исходные данные для диагностики - :это матрица Х показателей функционирования системы, элементы которой xij – результат i -го наблюдения по j -му показателю; i = 1, …, l , j = 1, …, р ( l – количество строк или число наблюдений, р – количество столбцов или число показателей) и вектор-столбец ответов Y , состоящий из 1 (для тех опытов, в которых объект исправен) и 0 при неисправном объекте. Каждой строке xi матрицы Х соответствует определённое значение yi вектора Y .

Задача состоит в построении функции а : Х ^ Y , которая спрогнозирует ответ Y для любого заданного Х [2-4]. При числовых признаках xi , часто используют линейные модели с вектором параметров w = ( w 0 w 1 … w р )

a ( x, w ) = w 0 + w 1 x 1 + ... + w p x p , (1) при этом в задачах бинарной классификации обычно вместо нуля и единицы используют множество ответов Y = { – 1; +1}. В этом случае модель алгоритма примет вид:

p

a ( x, w ) = sign ^ w j x j ( x 0 = 1). (2) j = 0

Параметры wj подбираются по исходным данным; процесс подбора оптимальных параметров называется обучением алгоритма. Найденные параметры должны обеспечить оптимальное значение функционала качества. В рассматриваемой задаче минимизируется функционал ошибок – это среднее количество несовпадений, где L ( a , xi ) называют функцией потерь:

1 l^ 1

Q ( a , X ) = 7 ^ L ( a , X i ) = ^[a ( X i ) - ^ i ] ^ min (3) l i = 1 l i = 1

Алгоритм а , который минимизирует функционал (3), может не обеспечивать хорошее прогнозирование исправности объекта. Ситуация, когда качество работы алгоритма на новых объектах значительно хуже, чем на исходной выборке, свидетельствует о переобучении: алгоритм слишком хорошо подогнан под обучающую выборку и не способен к обобщению на другие выборки. Таким образом, построенный алгоритм не сможет предсказывать состояние исследуемого объекта при новых параметрах функционирования.

Для оценки качества модели с точки зрения возможности прогнозирования исходную выборку из l опытов разбивают на два непересека-ющихся подмножества: собственно обучающую выборку объёма l о , с помощью которой и решается задача обучения (3), и контрольную (или тестовую) объёма l к = l – l о , не используемую для обучения. При использовании кросс-валидации выборка разбивается на N частей (на практике обычно принимают N = 5 или N = 10). Часть ( N – 1) используется для обучения, а оставшаяся – для контроля. Последовательно перебираются все варианты. Для каждого разбиения решается задача обучения по выборке l о и вычисляется функция ошибок Q ( a , X ) на контрольной выборке l к . Среднее значение этой функции по всем вариантам разбиения и характеризует обобщающую способность алгоритма.

При несбалансированных классах (а при решении задач технической диагностики классы практически всегда несбалансированны: работоспособных состояний аппаратуры значительно больше, чем неработоспособных) доля ошибок не может объективно оценивать качество классификации [5-6]. Более информативны точность

P = tp /( tp + fp ) и полнота

R = tp /( tp + fn ), где tp – количество правильно классифицированных работоспособных состояний, fp – количество неправильно классифицированных работоспособных состояний, fn – количество неправильно классифицированных неработоспособных состояний. На основе этих двух показателей может быть сформирован единый критерий

F = 2 PR /( P + R ) – это гармоническое среднее точности и полноты ( F -мера): чем ближе значение F к единице, тем качество классификации выше.

Еще один распространенный функционал качества бинарной классификации - площадь под ROC-кривой (receiver operating characteristics): AUC (area under the curve). ROC-кривая образуется, если по оси абсцисс откладывать значения fp ( c ), а по оси ординат tp ( c ), где c – порог. Площадь под ROC-кривой позволяет оценить модель в целом, не привязываясь к конкретному порогу. Значение AUC автоматически учитывает диспропорцию в представителях класса, а также имеет простую вероятностную интерпретацию: это вероятность того, что ответ на случайном объекте из класса 1 будет больше ответа на случайном объекте из класса 0.

Методы машинного обучения активно применяют в самых разных областях деятельности. Используется множество различных подходов к классификации. Это и классические статистические методы [7-8], и методы, специально ориентированные на машинное обучение (метод опорных векторов, нейронные сети), композиционные методы (бэггинг, бустинг), агрегированный подход и другие [8-10].

Проблема состоит в том, что нельзя заранее определить, какой из выбранных методов обеспечит корректное решение задачи, поэтому часто используется множество различных методов или их комбинации, а решение о применении принимается по результатам исследования функционала качества для контрольной выборки.

Иногда строят композиции алгоритмов. Опыт показывает, что два главных метода построения композиции (бэггинг и бустинг) дают более точный результат, чем применение отдельного алгоритма на конкретном наборе данных.

Бэггинг используют при наличии небольших обучающих выборок: из имеющейся выборки исходных данных случайным образом с возвратом формируется несколько подмножеств такого же объёма, как и исходная выборка. На основе каждого подмножества строится классификатор, а результаты комбинируются путём голосования или усреднения. Часто в качестве базовых алгоритмов используются деревья решений.

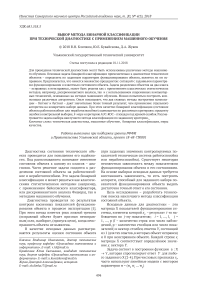

Таблица 1. Меры качества при различных методах классификации

|

F-критерий |

AUC |

|

|

логистическая регрессия |

0.845 |

0.796 |

|

дискриминантный анализ |

0.815 |

0.708 |

|

наивный байесовский классификатор |

0.817 |

0.736 |

|

нейронная сеть |

0.862 |

0.933 |

|

метод опорных векторов |

0.825 |

0.802 |

|

бэггинг деревьев решений |

0.874 |

0.911 |

|

градиентный бустинг |

0.862 |

0.897 |

|

AdaBoost |

0.851 |

0.887 |

|

LogitBoost |

0.839 |

0.887 |

|

GentleBoost |

0.841 |

0.782 |

|

RUSBoost |

0.811 |

0.830 |

Эффективным методом машинного обучения является и бустинг. Итоговое правило в бустинге определяется путём взвешенного голосования композиции базовых правил. При этом используется информация об ошибках предыдущих правил: веса объектов выбирают таким образом, чтобы новое правило точнее работало на тех объектах, на которых с предыдущими правилами чаще возникали ошибки. В различных модификациях используются разные аппроксимации функции потерь в формуле (3): в наиболее распространенном методе AdaBoost – экспонента, в методе LogitBoost (используется при наличии шумовых данных) – аппроксимация, основанная на логистической регрессии, и другие.

Исследование проводилось в пакете Matlab, позволяющим использовать различные методы бинарной классификации, а также обеспечивающим разбивку выборки на обучающую и контрольную части с проведением кросс-валидации – последовательном использовании одной части выборки в качестве контрольной, а остальных частей – в качестве обучающей выборки. В качестве исходных данных использовались результаты 348 наблюдений за объектом, при этом объект оказался неработоспособным в 47 случаях. Критериями качества служили F-критерий и площадь под кривой ошибок. Результаты исследования представлены в таблице 1.

Видно, что по F-критерию наилучшими оказались бэггинг деревьев решений (F = 0,874), также неплохой результат показали нейронная сеть и градиентный бустинг (F = 0, 862). По площади под кривой ошибок наилучшим методом оказалась нейронная сеть (AUC = 0,933), неплохой результат имеет бэггинг деревьев решений (AUC = 0,911). Окончательное решение о том, какой из методов предпочесть, принимает пользователь.

Отметим, что все три статистических метода, используемые для решения этой задачи (логистическая регрессия, дискриминантный анализ и наивный байесовский классификатор), показали низкий результат как по одному, так и по другому критерию. Это, конечно, не всегда так, поэтому целесообразно при решении конкретных задач проводить апробацию множества методов бинарной классификации.

Список литературы Выбор метода бинарной классификации при технической диагностике с применением машинного обучения

- Биргер И.А. Техническая диагностика. М.: Машиностроение, 1978. 240 с.

- Witten I.H., Frank E. Data mining: practical machine learning tools and techniques. 2nd ed. San Francisco: Morgan Kaufmann Publishers, 2005. 525 р.

- Мерков А.Б. Распознавание образов. Введение в методы статистического обучения. М.: Едиториал УРСС, 2011. 256 с.

- Воронцов К.В. Машинное обучение. Композиция классификаторов // https://yadi.sk/i/FItIu6V0beBmF

- Соколов Е.А. ФКН ВШЭ. Лекция 4. Линейная классификация URL: https://github.com /esokolov/ml-course-hse/blob/master/2018-fall/lecture-notes/lecture04-linclass.pdf (дата обращения 14.09.2018).

- Дьяконов А.М. AUC ROC (площадь под кривой ошибок). URL: https://dyakonov.org/2017/07/28/auc-roc-площадь-под-кривой-ошибок/#more-5362 (дата обращения 14.09.2018).

- Теория и практика машинного обучения: учеб. пособие / В.В. Воронина, А.В. Михеев, Н.Г. Ярушкина, К.В. Святов. Ульяновск: УлГТУ, 2017. 290 с.

- Клячкин В.Н. Статистические методы в управлении качеством: компьютерные технологии. М.: Финансы и статистика, ИНФРА-М, 2009. 304 с.

- Bersimis S., Psarakis S., Panaretos J. Multivariate Statistical Process Control Charts: An Overview // Quality and reliability Engeneering International. 2007. V. 23. рр. 517-543.

- Клячкин В.Н., Кувайскова Ю.Е., Жуков Д.А. Диагностика технического состояния аппаратуры с использованием агрегированных классификаторов // Радиотехника. 2018. № 6. С. 46-49.