Интеграция искусственных нейронных сетей с базами знаний

Автор: Головко В.А., Голенков В.В., Ивашенко В.П., Таберко В.В., Иванюк Д.С., Крощенко А.А., Ковалв М.В.

Журнал: Онтология проектирования @ontology-of-designing

Рубрика: Прикладные онтологии проектирования

Статья в выпуске: 3 (29) т.8, 2018 года.

Бесплатный доступ

Статья посвящена вопросам и направлениям интеграции искусственных нейронных сетей с базами знаний. Рассмотрены два направления интеграции: коммуникация через входы и выходы искусственной нейронной сети с целью использования интеграции баз знаний и искусственных нейронных сетей для решения прикладных задач; через представление искусственных нейронных сетей с помощью онтологических структур и их интерпретацию средствами представления знаний в базе знаний с целью создания интеллектуальной среды по разработке, обучению и интеграции искусственных нейронных сетей, совместимых с базами знаний. Базы знаний, с которыми интегрируются искусственные нейронные сети, построены на основе однородных семантических сетей, а обработка знаний в них осуществляется с помощью многоагентного подхода. Предложена онтологическая модель представления искусственных нейронных сетей и их спецификаций в рамках модели унифицированного семантического представления знаний, отличающаяся возможностью представления в базах знаний искусственных нейронных сетей, их динамики и знаний других видов, включая спецификации искусственных нейронных сетей в виде текстов одного языка представления знаний с общей теоретико-модельной семантикой. Предложена многоагентная модель решения задач с использованием искусственных нейронных сетей и знаний других видов, отличающаяся взаимодействием агентов в соответствии с заданной темпоральной моделью через общую память, хранящую знания, интегрированные в единую базу знаний.

Искусственные нейронные сети, база знаний, интеграция, интеллектуальная среда разработки

Короткий адрес: https://sciup.org/170178792

IDR: 170178792 | УДК: 004.032.26, | DOI: 10.18287/2223-9537-2018-8-3-366-386

Текст научной статьи Интеграция искусственных нейронных сетей с базами знаний

В задачах, решаемых современными интеллектуальными системами (ИС), используют различных модели представления знаний. Интеграция моделей такого рода в рамках одной системы зачастую сопряжена со значительными трудностями.

К одному из наиболее активно развиваемых направлений в области искусственного интеллекта относится направление, связанное с решением задач на основе методов машинного обучения. Популярность методов решения задач на основе машинного обучения в значительной степени вызвана развитием теоретических моделей искусственных нейронных сетей (ИНС) и производительных аппаратных платформ для их реализации. Постоянно увеличивается многообразие архитектур, методов, направлений и способов применения ИНС.

Становится актуальной разработка подходов по интеграции ИНС и баз знаний (БЗ), использующих онтологии. Такие интегрированные системы способны сочетать возможность семантической интерпретации обрабатываемых ИНС данных, используя представление прикладных задач, решаемых ИНС, спецификацию её входных и выходных данных с представлением самой структуры ИНС, описанием её свойств и состояний, позволяющим упростить понимание её работы.

1 Искусственные нейронные сети и знания

Появление ИНС связывают с работами У. Мак-Каллока и У. Питтса [1], в которых, однако, предпочитается термин сеть нейронов. Термин «нейронная сеть» («нейронная сетка») за- крепился, начиная с работ К. Фукусимы [2].

Особенный интерес имеет применение глубоких нейронных сетей для формирования абстракций. Эти сети обладают преимуществом, отличающим их от поверхностных моделей – возможность формирования сложной иерархии признаков [3]. Впервые эффективный алгоритм обучения глубоких нейронных сетей был предложен Дж. Хинтоном в 2006 году [4].

Начиная с этого момента, появилось много работ, посвящённых обучению такого типа сетей

(например, [5, 6]). Были предложены и принципиально иные подходы (см., например, [7, 8]).

В данной работе рассматриваются ИНС, построенные на основе понятия формального нейрона [9]. Формальный нейрон задаётся композицией двух функций:

■

■

■ ■ ■ ■

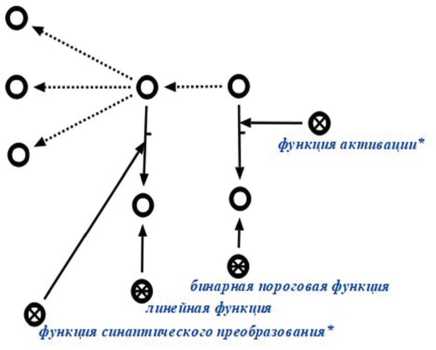

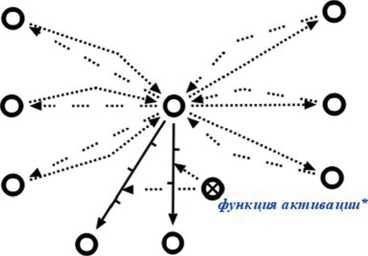

функция синаптического преобразования;

функция активации нейрона.

ИНС на основе формальных нейронов задаётся четвёркой компонентов:

множество вершин нейронной сети (V);

множество рёбер нейронной сети (E (E ⊆ V × V));

множество формальных нейронов, их свойств и параметров нейронной сети (N);

множество соответствий между объединением множеств вершин и рёбер нейронной сети и множеством формальных нейронов, их свойств и параметров нейронной сети S.

S ⊆ 2 (V ∪ E)×N

ИНС можно соотносить с понятием знания в соответствии с разными подходами к пониманию знаний. Соотнесение на основе признаков [10]:

-

■ связность (ИНС имеют связный ориентированный граф, но не всегда сильносвязный);

-

■ сложная структура (существуют ИНС со сложной структурой, состоящей из множества слоёв, вершин нейронной сети и обратных связей);

-

■ интерпретируемость (программные реализации ИНС позволяют их интерпретировать);

-

■ активность (программные реализации ИНС обладают активностью);

-

■ семантическая метрика (семантическая метрика в общем виде и случае для (вершин)

ИНС отсутствует).

В соответствии с IDEF-5 [11] знания выражаются в виде отношений, свойств, видов и атрибутов. В соответствии с этим у ИНС есть только числовые атрибуты и возможно, иногда, виды и отношения, заданные с помощью характеристических функций (предикатов). Однако, в общем случае характеристические функции не определены и не известны.

С точки зрения структурного подхода ИНС – математическая структура (модель), соответствующая принципам коннекционизма, которая соответствует информационному процессу, протекающему в технической (кибернетической) системе, выражаемому в виде соответствия или функции.

С прагматико-математической точки зрения данные, обрабатываемые ИНС, есть элементы некоторого множества, зачастую интерпретируемые как признаковый набор (образ, атри- буты некоторой сущности), а само множество - как признаковое (векторное) пространство. Под признаком понимается числовой, количественный атрибут объекта, сущности, который может быть выражен, задан с помощью соответствия или функции. Различают бинарные, номинальные, порядковые и количественные признаки.

2 Классификация задач, решаемых ИНС

Задачу можно задать отношением между описанием исходной ситуации и описанием множества целевых ситуаций. Классифицировать задачи можно в соответствии с разными признаками. Исходя из общеметодологических принципов, можно выделить признаки классов задач, которые удобно решать с помощью ИНС:

-

■ трудноформализуемые задачи, решение которых обладает естественным (векторным) параллелизмом или параллелизмом данных;

-

■ задачи, решение которых устойчиво к наличию НЕ-факторов в данных и знаниях.

Перечислим возможные признаки классов задач, которые невыгодно решать только с помощью ИНС:

-

■ сложное концептуальное описание в задаче;

-

■ наличие НЕ-факторов и неустойчивость решения к ним;

-

■ преобладание сложно описываемых последовательных процессов в решении задачи;

-

■ необходимость интроспективного анализа и объяснения полученных результатов в сложных ИНС.

Накопленный опыт показывает, что ИНС успешно применяются для решения задач следующих видов (см. таблицу 1).

Таблица 1 - Классификация видов задач, решаемых с применением ИНС

|

Концептуально-прагматическая классификация |

Математическая классификация |

|

аппроксимация: |

|

|

управление процессами |

- оптимизация |

|

прогнозирование |

- экстраполяция |

|

генерация образов |

|

|

сопоставление образов |

|

|

выявление аномальных явлений |

|

|

логический вывод |

логический вывод: |

|

трансляция образов: |

|

|

- кластеризация образов |

- векторное квантование |

|

- сжатие образов |

- понижение размерности |

|

- линейное разделение образов |

- повышение размерности |

|

- ассоциирование образов: |

|

|

- классификация образов |

|

|

- распознавание образов |

Среди классов задач можно выделить классы задач, условно являющиеся специализированно-прикладными, и классы задач, условно являющиеся абстрактнофундаментальными [12].

3 Интеграция ИНС с базами знаний при решении прикладных задач

ИС с БЗ при решении прикладных задач с помощью нейросетевых алгоритмов могут использоваться как для внутренних задач, таких как обучение нейронной сети или оптимизация её работы, так и для решения целевой задачи путём обработки входных и выходных пара- метров ИНС. Такие ИС могут использовать нейросетевые методы наравне с другими имеющимися в системе методами для решения только одной, выделенной системой из подзадач, при решении какой-либо прикладной задачи.

Далее будут рассмотрены п римеры п рименения интеграц и и ИНС с Б З при ре ш ении прикладных задач.

-

3.1 Инте г рация нейронных с етей с б а зами зна н ий в сист е ме расп о знавани я маркировки продукции в ОАО «С а вушкин п р одукт»

Одно й из производствен н ых зада ч в ОАО «Савушк и н проду к т» являе т ся задача распозна в ания маркировки пр о дукции [ 1 3]. На ба з е ИНС [1 4 , 15] раз р абатывается модуль, который а нализирует изобра ж ение с к а меры, находящейся над конвейером (рисунок 1), которая р аспознаёт нанесённ у ю на кр ы шку марк и ровку - с троку с д а той изго т овления и сроком го д ности (рисунок 2).

Рисунок 2 - Бу т ылка с йогу р том с маркированными крышк а ми

модуля в систему р о злива пр е дполагает

Ри с унок 1 - Конвейер с бло к ом камеры

Простейший способ интеграции данного приостановку конвейера и уведомление об этом инженера КИПиА (Контрольно Измерительные Приборы и Автоматика) посредством аварийной звуковой и световой сигнализации, если модулем будет обнаружено n (например, 5) подряд идущих бутылок с ошибкой распознавания маркировки. Он должен определить причину неисправности и её устранить. В этом случае данный модуль распознаёт строку и передаёт результат в БЗ, в которой действие осуществляется согласно следующим правилам:

-

■ если распознанная строка не совпа д ает с эталонной и это единич н ый случ а й, то надо

просто эту бутылку отбра к овать (пр и наличии м одуля отбраковки);

-

■ если р аспознанная строка пустая, и это повто р яется для n подряд идущих б у тылок, то

надо остановить конвейер и уведомить инженера КИПиА о необходимости заправить принтер чернилами, которые закончились;

-

■ если распознанная строка не пустая, но не совпадает с эталонной, и это повт о ряется для n , то надо остановить конвейер и уведоми т ь инжен е ра КИПи А о необходимости очистить печатающий бло к принтер а , в котором забились сопла.

-

3.2 Применение ИНС для п о ддержки и актуализации ба з ы знаний

Таких правил может бы т ь много. Кроме того, необх о димо им е ть возмо ж ность их просматривать и редактироват ь (возмож н о, даже инженером К ИПиА).

Так как постоянно меняется потребительская упаковка (и маркировка), возникает вопрос: кто и как будет производить настройку данной системы на новый вид маркировки? Предположим, сегодня печатаются арабские цифры, а завтра маркировать продукцию нужно будет римскими цифрами. Что необходимо для этого сделать - сформировать обучающую выборку, обучить новую ИНС, запустить её. Такую работу не может выполнить инженер КИПиА (недостаточно знаний в данной области). Но если будет существовать некоторый посредник между ними в виде ИС, то тогда все может выглядеть т ак: ИС получает от нейронной сети информацию о том, что не удаётся распознать надписи, а от пользователя (инженер КИПиА) информацию о том, что всё в порядке и просто запущен новый вид маркировки, тогда она самостоятельно может выполнить перечисленные ранее задачи для адаптации модуля распознавания к новой упаковке.

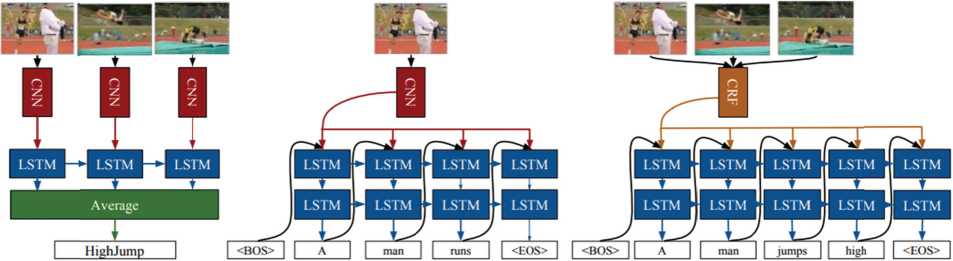

Сегод н я исследователями в области И НС предлагаются а р хитектур ы , состоящ и е из сетей различны х типов. Один из пу т ей интег р ации ИН С и БЗ ле ж ит в плос к ости исп о льзования таких архитектур-гибридов, ф о рмирую щ их систем у обработ к и потоков знаний д л я решения сложных задач. Примером т акой стр у ктуры является г и бридная с еть, исп о льзующая свёрточные нейронные сети ( C NN – con v olutional neural netw o rk) и реку р рентные L STM-сети (long short-term memory) [16 ] . Схема п одобной нейросете в ой моде л и LRCN (Long-term Recurrent Convolutional Networ k ), предст а влена на рисунке 3.

Activity Recognition Image Captioning Video Description

Sequences in the Input Sequences in the Output Sequences in the Input and Output

Рисунок 3 – Долгосроч н ая рекуррентная свёрточ н ая сеть [16]

Здесь фактически представлено два р азличны х варианта такой арх и тектуры, к аждый из которых решает свою задачу. П ервый в ар иант предполагает у среднени е результа т ов работы LSTM-сети и получение ком п актного о п исания производимого дейст в ия. Такой результат можно рассматривать как ра с познаван и е действи я , предста в ленного п оследова т ельностью изображе н ий. Во втором вари а нте осуще с твляется п оследова т ельное пр и менение L STM-сети для формирования текстового описания к изобра ж ению. В о боих вар и антах зад е йствовано два типа нейросетевой архит е ктуры. П е рвый тип – CNN, которая об р абатывае т исходное подаваем о е на вход изобра ж ение и ф ормирует признак и . Второй тип – L STM-сеть, принимающая на вход призн а ки и ген е рирующа я текстовое описан и е. В соот в етствии с классифи к ацией, приведённой в разделе 2, такая з а дача относится к за д ачам рас п ознавания образов ( 1 -й вариант модели) и задачам генерации образов (2-й вариант м одели).

Итоговое текстовое оп и сание, п олученное с помощью L R CN, мо ж ет быть проанализировано, сформулировано в в и де правил а и интегр и ровано в семантич е скую сеть. Семантическая сеть осущест в ляет нак о пление п олученны х знаний в виде конкретных объектов и связей между ними и способ н а в дальнейшем выполнять ло г ические з а ключения. Помимо анализа изображен и й, похо ж ая архит е ктура пр и меняется для формирования текстовы х описаний видеопот о ка.

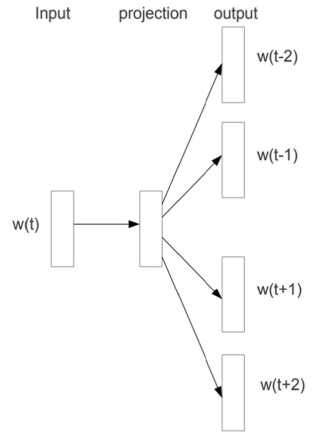

Другой вариант использо в ания бази р уется на применен и и в качес т ве базово г о подхода метода word2vec [17]. Этот метод позв о ляет осу щ ествлять с емантиче с кий анал и з текста с выделением наиболее близки х по смыс л у слов. В основе ме т ода лежи т использо в ание про-

Рисунок 4 – Вариант skip-gram

стой по своей стр у ктуре мн о гослойно й нейронн о й сети, ко торая о с уществля е т формир о вание ко н текста на основе од

-

-

ного це л евого сл о ва (вариа н т skip-gra m s – рису н ок 4 [17]), либо ф о рмирован и е целевог о слова на основе пе р едаваемого конт е кста (вар и ант CBO W – Contin u ous Bag o f Words).

По д контекстом понима е тся совок у пность сл о в (слева и справа) , окружа ю щая целе в ое слово , взятая в пределах

опреде л ённого о к на. В ре з ультате о бученная ИНС осу ществл я ет отобра ж ение сло в а, записа н ного в ви д е унитар

-

-

общего р азмера словаря

ного к о да (и, соответственно, принад л ежащего с ловарю) в простр а нство мен ь шей размерности, ко торое вп о следствии исполь з уется для оценки с емантиче с кой близ о сти слов. Получе н ное пог р ужение может быт ь использовано для предск а зания семантически х отношен и й. Напри м ер, король для королевы то же что отец для ? ( king is to queen as father is to ? ).

Пр и ведём п р имер ви з уализаци и , полученной для выборк и из 10000 0 англояз ы чных док у ментов В и кипедии и 5 0 000 сло в . В экс п ерименте использ о валась у п рощённая

архитект у ра skip-grams, вклю ч ающая 50.000 входн ы х нейронов, соотве т ствующи х целевому слову, 30 0 скрытых и 50000 в ы ходных н е йронов, с о ответству ю щих кон т екстному с лову. При обучении были сформированы пары с лов ( целе в ое слово, контекс т ное слово ) , которые подавали с ь на нейронную сеть мини- б атчами п о 128 пар в каждо м . После о бучения к редуциро в анным кодам слов б ыл прим е нен алгоритм t-SN E для уме н ьшения р а змерности данных. Полученная двумерна я карта се м антическ о го сходст в а изображ е на на рис у нке 5.

available possible*

home

popular Эепега1 common

Dse e*

order wife husband* ifiakeup bureau fatter non-families unit^8n e®

^ housing

special similar • different

eai

presidertinS

Me • royaj member member

. tlevel ^ total « * hfe

governme^rfv comp council* |eagi¥ court law act education

sc I

s

>me

new

two sgve

female mate

hi^

human natural

median number hlst0^ * №F^ dvci capita • result research line household in^°me ^"development •

• . family* e . tfocfuction • speeches*

individuals

v*w-i

etudent^

children *

, males females

support^

version

house sp№in2e

egyoege

ей^е

form nar±

• c^6te wa^ position time periocP

p|a№int

s own

young native

815 er middle h8tj§8ic

free local national

daystimes year® • age

story bowfilm

international

.еаадгеап

us states union staft

community countries * countij

centB?t

site

albinjtord song» •

Ри с унок 5 – Ка р та семанти ч еского сход с тва

village . , to*m world

. island cdp e

towr^t^

district

ar^®£

square street road route

lake nv*

sea laMgterjr

Метод word2vec может использоваться как для формирования БЗ в определённой ПрО (например, [18]), так и извлечения семантических реляций в общем [19].

По классификации, приведённой в разделе 2, эта задача относится к задачам сжатия (понижения размерности).

-

3.3 Пример использования базы знаний на этапе обучения ИНС

Вариантом интеграции нейронных сетей с БЗ является использование БЗ при обучении ИНС. При таком подходе БЗ содержит в себе описание ПрО, в рамках которых решается задача, и с их помощью можно определить входные и выходные значения ИНС. С БЗ работает машина обработки знаний, которая сможет интерпретировать хранящиеся правила валидации (проверка на соответствие погружаемого значения некоторым условиям), проверки на непротиворечивость (проверка того, что новые знания не нарушают логические правила, хранящиеся в БЗ) и корректировки (замена одних знаний другими) знаний.

Такая интеграция может быть использована для выполнения следующих задач.

-

■ Валидация и корректировка обучающих, тестовых и экзаменационных выборок. Все элементы выборок погружаются в БЗ, что подразумевает проверку на непротиворечивость. В системе также может храниться набор правил по валидации (тестированию) и корректировке значений признаков входных элементов.

-

■ Проверка непротиворечивости и корректности выхода ИНС на этапе обучения и осуществление соответствующей корректировки обучения. Обучение ИНС

корректируется в зависимости от промежуточных результатов, которые с помощью обращения к БЗ проверяются на валидность и противоречивость. Результат может быть скорректирован, для чего в БЗ должны присутствовать соответствующие правила. В зависимости от результата обращения к БЗ может изменяться алгоритм обучения за счёт прямого учёта семантики.

-

■ Валидация и корректировка результатов работы обученной ИНС. Результат работы ИНС может проверяться на валидность и противоречивость, а также корректироваться как с помощью правил, использовавшихся во время обучения, так и с помощью другого специализированного набора правил.

Для выполнения этих задач может использоваться как уже готовая БЗ некоторой ИС, так и специально разработанная для обучения конкретной ИНС БЗ.

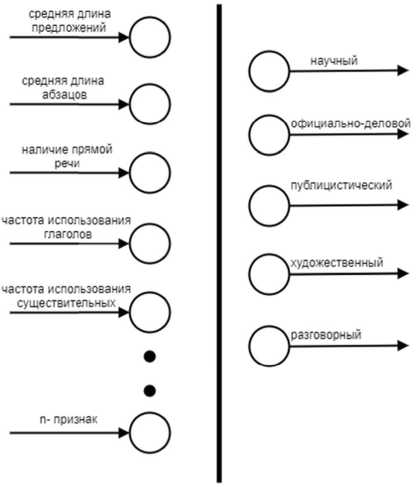

Рассмотрим предлагаемый метод на примере задачи о классификации. Постановка задачи классификации: имеется группа объектов, у которых выделяются n признаков, необходимо отнести каждый объект к одному из p заданных классов. ИНС обучается на некоторой выборке объектов с известными признаками и в зависимости от типа обучения (с учителем или без) с известной принадлежностью к классу.

Процесс обучения можно улучшить, если описать классы объектов и их признаки в БЗ. К примеру, на этапе обучения без учителя ИНС отнесла объект к некоторому классу j . Так как в БЗ хранится описание этого класса, можно будет проверить, не противоречит ли значение признаков этого объекта описанию класса, в который его отнесли. И уже зная это, можно будет делать вывод о необходимости и способе корректировки весов ИНС, таким образом расширяя алгоритм обучения.

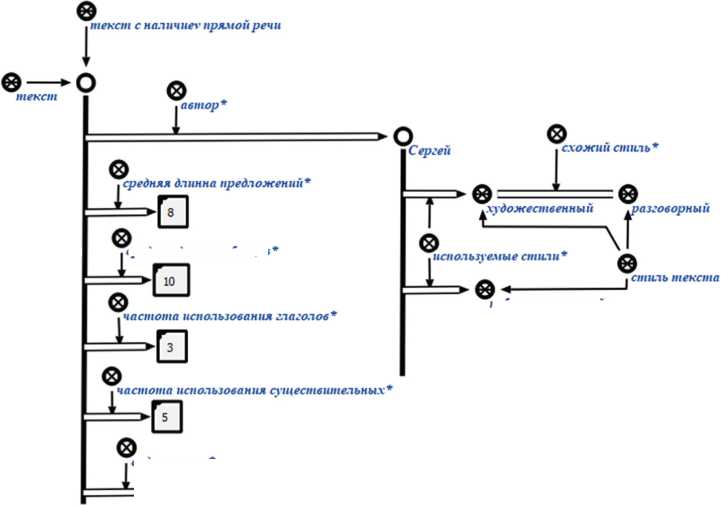

Возьмём условную задачу определения стиля текста. Имеется текст и автор. Из текста извлекаются такие условные признаки, как средняя длина предложений, средняя длина абзацев, наличие прямой речи, частота использования глаголов и существительных. Необходимо определить, какому из пяти традиционных стилей – разговорный, научный, официальноделовой, публицистический, художественный – принадлежит текст. На рисунке 6 представлено схематическое изображение входов и выходов ИНС, решающей эту задачу.

Рисунок 6 – Схематическое изобра ж ение входо в и выходов искусственной нейрон н ой сети для решен и я задачи определения с т иля текста

Каждый элемент обу ч ающей в ы борки погружается в БЗ. Семан ти ческая о к рестность погружённых элементо в расшир я ется уже имеющимися в системе з н аниями. Н а рисунке 7 п р едставлен фрагмен т БЗ, описывающий погружённый элемент в ы борки т е кстов для опр е деления и х стиля. Его сем а нтическая окрестность р а сширяетс я уже име ю щимися в сист е ме знани ми об ав т оре текст а и стилях, кото р ые он ис п ользует в с воих текс т ах.

Эта информация может быть использована для валидации и корр ектировки результатов ИНС во время обучения. К примеру, во время обучения ИНС опр еделила стиль текста как разговорный. В БЗ и меется правило валидации, при котором тексту можно определить только такой стиль, кото рый уже использовал ранее его автор. Также в системе имеется правило корректировки резу льтата, при котором если определен стиль текста, который автор ранее не использовал, то можно заменить его на схожий, который автор использовал. Из фрагмента БЗ, представленного на рисунке 7, си-

стема сможет применить описанные правила валидации и корректировки, и заменить разговорный стиль на наиболее близкий ему художественный. Причём в зависимости от того, бы- ли ли применены правила валидации и корректировки и от результат ов применения этих правил, может меняться алгоритм пересчета весов в ИНС.

средняя длинна обзаиов нубл инист и ч ески и содержимое*

Рисунок 7 – Фрагмент БЗ, описыв а ющий погр у жённый эле м ент выборк и текстов дл я определения их стиля

Описанный подход поможет увеличить степень учёта семантики во время обучения, отбросить или скорректировать заведомо неудачные элементы выборок, а также проверить результат работы ИНС на правдоподобность.

4 Интеллектуальная среда

Интеллектуальная среда – это набор инструментов, способный осуществлять автоматический подбор параметров используемой модели в зависимости от решаемой задачи с минимальным участием конечного пользователя. Такая система способна помочь людям, не являющимися специалистами в области машинного обучения и нейронных сетей, успешно применять последние разработки в своей сфере деятельности.

Успехи в разработке высокоуровневых фреймворков последних лет связаны с возможностями использования в качестве аппаратной платформы для расчётов видеокарт (GPU), а также со способностью выполнять параллелизацию вычислений на разные устройства как одного компьютера, так и целого кластера компьютеров [20].

Известно большое количество различных библиотек, позволяющих успешно внедрять решения на основе интеллектуальных алгоритмов. Однако для этого необходимо иметь набор знаний и навыков, позволяющий модифицировать и улучшать стандартные решения. Выделим часто используемые фреймворки [21].

TensorFlow – одна из самых популярных на настоящий момент библиотек. Была разработана подразделением Google (2015). Позволяет запускать модели на нескольких CPU- и GPU-устройствах (хорошо масштабируется). Доступна для разных платформ, поддерживает разные языки программирования (C++, R, Python).

Caffe/Caffe2 – одна из первых библиотек глубокого обучения. Написана на С++, имеет интерфейс на Python. В основном ориентирована на обучение и использование моделей, построенных на свёрточных и многослойных сетях. Создано большое количество предобучен-ных архитектур для Caffe. Facebook в 2017 году предложил новую версию Caffe2, которая предлагает большую гибкость в построении высокопроизводительных глубоких моделей.

Theano – одна из первых библиотек, реализующих алгоритмы глубокого обучения. Пользуется устойчивой популярностью у специалистов в области глубокого обучения. Часто используется как нижележащий фреймворк для многих высокоуровневых библиотек, которые предоставляют API-обертки (к примеру, Keras).

Keras – предоставляет упрощённый интерфейс для работы с Theano, Tensotflow или CNTK. Очень простой в изучении и использовании. Хорошо документирован. Позволяет описать создание и обучение ИНС в нескольких строчках кода. Написан на Python.

Torch – фреймворк, базирующийся на Lua. Возможно использование библиотек С/С++ и CUDA. Очень простая библиотека, процесс построения моделей максимально упрощен. Есть более современная реализация на Python, называющаяся PyTorch.

Отметим также другие фреймворки, которые активно используются. Это Microsoft CNTK, MXNet и базирующийся на нем Gluon, ONNX, выпущенный в сентябре 2017 года и представляющий собой открытый формат для представления глубоких нейронных моделей.

Основной недостаток разрабатываемых фреймворков — это требование к наличию знаний о структурах моделей, которые должны использоваться для каждой конкретной задачи.

Известно, что выбор нейронной сети для решения задачи — процесс во многом творческий и в большей степени эмпирический, поскольку предполагает получение результатов путём подбора и оценки эффективности различных архитектур сетей. Однако уже сейчас успешно разрабатываются подходы к автоматической генерации моделей нейронных сетей [22], которые показывают преимущество перед ручным подбором параметров.

5 Предметная область ИНС и их денотационная и операционная семантика

Основной частью систем ы , разрабат ы ваемой с помощью технолог и и OSTIS [13, 23, 24] является о нтологическая моде л ь (sc-мод е ль БЗ), п о строение которой о с уществля е тся на основе онтологического подхода. Данный п одход по д разумевае т построе н ие онтоло г ий как систем абсолютных и относител ь ных поня т ий, опис ы вающих т у или ину ю ПрО. В р амках технологии OSTIS уточняется по н ятие онт о логии ка к специфи к ации ПрО [25, 26], в ыделяется их типол о гия.

-

5.1 Представление нейронных сетей в базе знаний

Пред л агаемый подход ос н ован на и с пользова н ии БЗ, со о тветству ю щих мод е ли унифицированного семантического п редставле н ия знаний. В рамка х этой мод е ли используются однородные семантические сети – семанти ч еские сет и , в основ е которых л ежит баз о вая теоретико-множественная семанти ч еская инт е рпретация, построе н ная на о т ношении (ситуативной) при н адлежности (неприн а длежност и ) элемента множес т ву (единс т венный б а зовый тип отношения) [25], связки кото р ого обозн а чаются sc-дугами. Я зыки, вхо д ящие в м о дель унифицирова н ного семантического предста в ления зна н ий, назыв а ются sc-я з ыками, тексты которых состоят из sc-элементов, а формиру е мые из н и х (ситуат и вные) мн о жества, с т руктуры и онтологические представлен и я, онтоло г ические модели н а зываются соответс т венно sc-множествами, sc-структурами и sc-моде л ями. Сем а нтика языков модел и унифиц и рованного семантического представлени я знаний соответствует моде л и ситуат и вных (со б ытийных) множеств. Ситуативные множ е ства пред с тавляют собой более гибкий и адекватн ы й аппарат для пред с тавления знаний, чем классич е ские множества, п о зволяя уч и тывать Н Е -факторы знаний и адаптироваться к пр е дставляе м ой ПрО, сохраняя о н тологиче с кую моде л ь и её семантику. Э то достигается не т олько за с ч ёт учёта в ременны х свойств, ч то позво л яет интерпретировать систему ситуатив н ых множ е ств как р а звитие систем L-неч ё тких мно ж еств, но и за счёт того, что в рамках модели униф и цированн о го семант и ческого пр едставле н ия знаний процесс употребления аппарата ситуати в ных множ е ств спосо б ен иметь д инамиче с кий характер, поддерживаемый динами к ой алфави т ных меток.

Поэтому представляется ц е лесообра з ным упот р ебление ситуативн ы х множес т в и их достоинств для представления И НС сред с твами модели уни ф ицирован н ого сема н тического представ л ения знаний. Семан т ика текст о в sc-языков в рамка х модели у н ифициро в анного семантического представления з наний яв л яется модельной, о д нако воз м ожно её о писание в денотационном виде, в этом с л учае мож н о говорит ь о денота ц ионной се м антике sc-языков на базе ситуативных множеств.

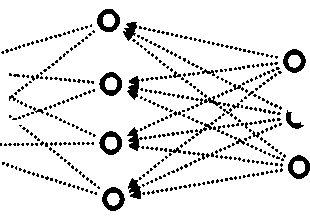

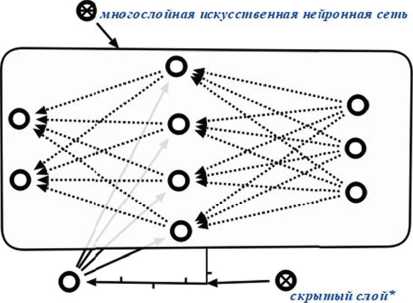

Рисунок 8 – Представление многос л ойной ИНС

Таким образом, п ри предст а влении ИНС можно т рактовать каждую её вершин у (узел), не являющу ю ся реце п торной, к ак обозн а чение си т уативного м ножеств а (sc-множ е ства) все х вершин, и з которых с игнал пр и ходит в э тот узел ( рисунок 8 ). Каждая р ецепторная вершина – это о б означение ситуатив н ого множества при з наков су щ ностей, к о торые она в ыражает.

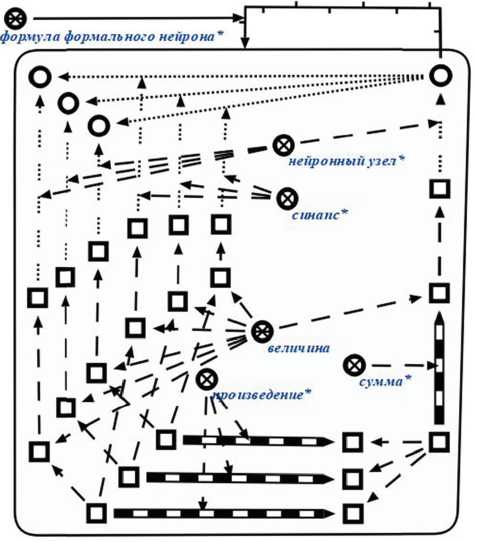

ИНС представляется как ситуативное множество sc-элементов, обозначающих вершины, связи, их параметры, функции, свойства, связки и соответ- ствия между ними (рисунок 9).

Рисунок 9 – Пред с тавление И Н С как ситуа т ивное мно ж ество sc эле м ентов

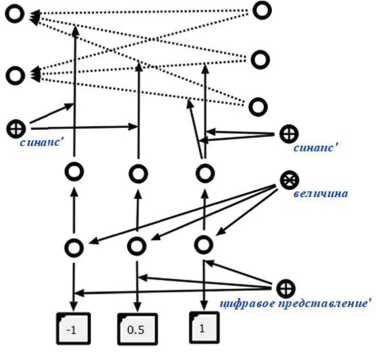

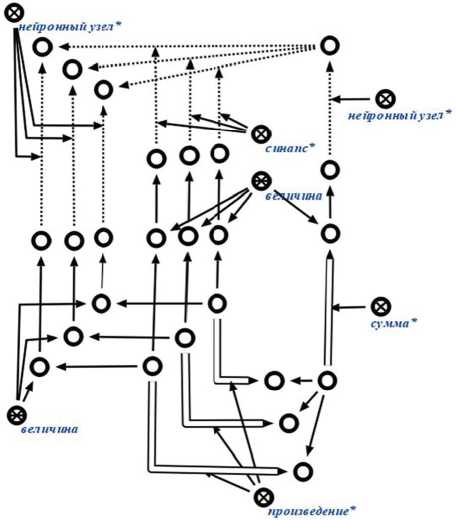

Значе н ия весовых коэфф и циентов для сина п тических связей и выходны х сигналов нейронн ы х элементов предста в ляются к а к ситуати в ное значе н ие некот о рой велич и ны, полученное из м ерением соответств у ющих эл е ментов И Н С (рисун о к 10).

Для у к азания функций си н аптическо г о преобр а зования и активаци и (рисунок 11), значений весо в ых коэффициентов ( рисунок 10) и выхо д ных сигналов нейр о нных эле м ентов используют с я ключевые элемен т ы: функц и я синапт и ческого п р еобразов а ния*, фун к ция активации*, с и напс*, нейронный уз е л*, обозн а чающие с и туативны е отношен и я.

Межд у этими значения м и могут быть установлены математи ч еские вз а имосвязи, выражае м ые с помощью ма т ематичес к их опера ц ий и от н ошений, таких ка к сумма и произвед е ние (рисунок 12). Эт и математ и ческие от н ошения могут быть з аданы в общем виде высказыв а нием или программ о й (рисуно к 13).

Рисунок 1 0 – Представление весовы х коэффици е нтов синаптических связей И НС

Рис у нок 11 – Представление функций си н аптического преобраз о вания и акт и вации узлов ИНС

Рисунок 1 2 – Представление выход н ых значени й элементов ИНС и их математическ и х отношени й

Рисунок 13 – Предс т авление фо р мального о п исания завис и мости выхо д ных значен и й элементо в ИНС

Пред с тавление ИНС со сл о жной стр у ктурой позволяет представлят ь их отдел ь ные части, такие как скрытые слои в мн о гослойны х нейронн ы х сетях ( исунок 1 4 ), встречные связи в ИНС встречного распространения (рису н ок 15), об р атные св я зи в реку р рентных И НС (рисунок 10) и т .п.

Рисунок 1 4 – Представление мног о слойной ИНС со скрытым слоем

Рисунок 1 5 – Предста в ление ИНС встречного распро с транения

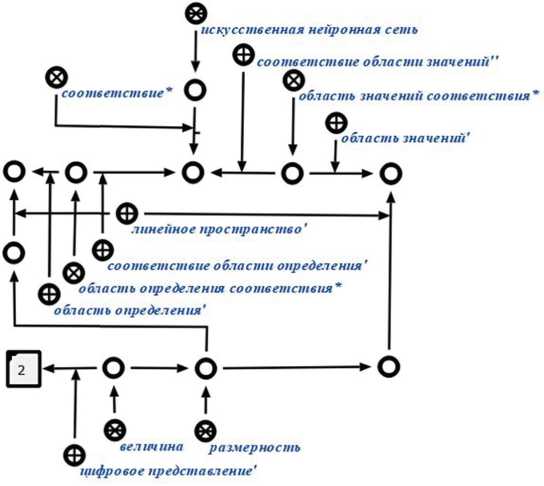

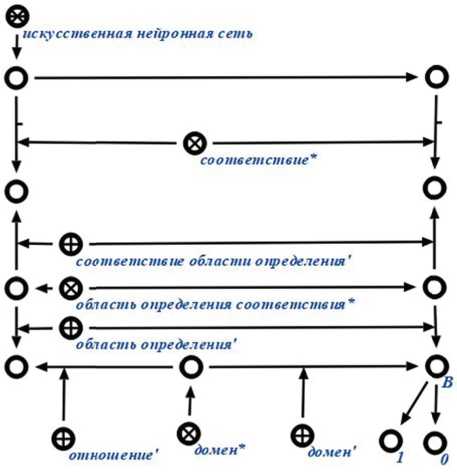

Кажд а я ИНС задаёт соответствие м ежду своими вход а ми и вы х одами (р и сунок 16, рисунок 17), описание этог о факта п редставл я ется с п мощью к лючевых элементов соответс т вие* , область опре д еления со о тветствия* , облас т ь определ е ния’ , соо т ветствие области определения’ , област ь значений соответствия* , об л асть знач е ний’ , соо т ветствие области значений’ . Для у т очнения значений входных нейронн ы х элеме н тов ИНС используются ключевые элементы домен ’ , домен* , отношени е ’ .

Рис у нок 16 - Оп и сание вход о в и выходов сети

Пере ч исленные ключевые элементы н аравне с д ругими и с пользуют с я для спе ц ификации признако в (рисунок 18), зна ч ения кот о рых явля ю тся значениями в х одных и выходных нейронн ы х элементов (рецепт о ров и эфф е кторов) И НС.

Рисунок 17 – Описание входног о нейронного элемента сети

-

*—ф* .

область определения

О-—0.

ооласть определения соответствия

Г-----ф -* .

соответствие ооласти определения

О'*

.четное натуральное число * оинарныи признак

-

*е .

соответствие ооласти значении о-—® ..

область значении соответствия

-----е,

оазасть значении

Рисунок 18 – Описание б инарного п р изнака

-

5.2 Стру к тура предметной о бласти

ПрО – структура, которая з адана на м ножестве s c-элементов.

На П р О определены те же отношени я , что и на sc-структ у рах, кото ры е могут б ыть связаны отно ш ениями включения (ситуатив н ого подм н ожества), изоморф н ого влож е ния и т.д.

Эти отношения являются аналогом отношений модели спецификации знаний [27]. Следует отличать эти отношения от ситуативных отношений временного включения, гипотетического включения, временного изоморфного вложения и гипотетического изоморфного вложения, которые обуславливаются присутствием таких НЕ-факторов, как неполнота и неопределённость.

ПрО А является частной ПрО B , если A включается в B и её (максимальное) исследуемое множество включается в (максимальное) исследуемое множество B.

Важнейшим этапом разработки БЗ по технологии OSTIS является формирование иерархии ПрО (на основе понятия частной ПрО), определяющей структуру БЗ, и их спецификация [26]. Рассмотрение БЗ с позиции соотношения с ПрО позволяет рассматривать исследуемые объекты на различных уровнях детализации, которые отражаются в различных типах онтологий, описывающих определенное направление описания свойства объекта в рамках описываемой ПрО. К таким онтологиям относятся: структурная спецификация ПрО, логическая онтология, логическая система понятий и их определений, теоретико-множественная онтология и другие.

Рассмотрим классификацию ИНС, представленную в рамках теоретико-множественной онтологии соответствующей ПрО.

-

■ Конечнозначные нейронные сети;

-

■ Комплексно-численные нейронные сети:

-

■ Вещественно-численные нейронные сети:

-

■ Рационально-численные нейронные сети:

-

■ Целочисленные нейронные сети.

-

■ Рациональные нейронные сети;

-

■ Повышающие размерность нейронные сети;

-

■ Понижающие размерность нейронные сети;

-

■ Прерывные нейронные сети;

-

■ Непрерывные нейронные сети;

-

■ Дифференцируемые нейронные сети;

-

■ Недифференцируемые нейронные сети;

-

■ Гомогенные нейронные сети;

-

■ Гетерогенные нейронные сети;

-

■ Нейронные сети без обратных связей;

-

■ Нейронные сети с обратными связями;

-

■ Нейронные сети без скрытых нейронов;

-

■ Нейронные сети со скрытыми нейронами;

-

■ Многослойные нейронные сети;

-

■ Однослойные нейронные сети;

-

■ Детерминированные нейронные сети;

-

■ Релаксационные нейронные сети.

Кроме указанных классов ИНС и соответствующих им ПрО можно выделить задачи, классы нейронных сетей и соответствующие ПрО, связанные с обучением ИНС.

Можно выделить два основных класса:

-

■ Обучение ИНС на основе эталонных значений выходных элементов ИНС;

-

■ Обучение ИНС без использования эталонных значений выходных элементов ИНС.

К первому классу можно отнести подклассы:

-

■ Обучение ИНС на основе дельта-правила;

-

■ Обучение ИНС на основе градиентных методов:

-

■ Обучение ИНС методом обратного распространения ошибки;

-

■ Обучение ИНС метод о м сопряж ё нных гра д иентов;

-

■ Обучение ИНС метод о м переме н ной метрики.

К час т ным классам второг о класса от н осятся:

-

■ Обучение ИНС без исполь з ования эт а лонных з н ачений н а основе п р авила Хеб б а [28];

-

■ Обучение ИНС без исполь з ования эт а лонных з н ачений н а основе п р авила WT A [29].

6 Агенты интеллектуальной среды обработки нейронных се тей

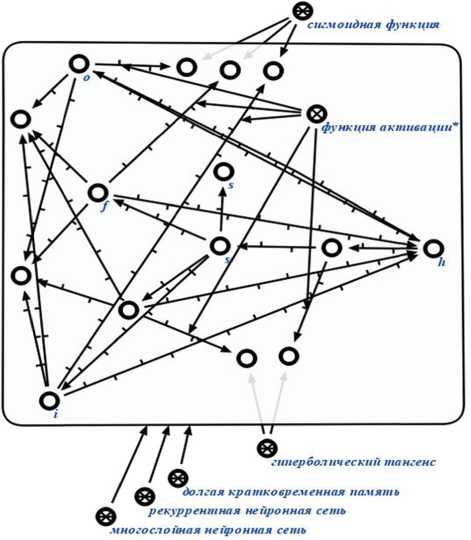

Операционная семантика Б З, постро е нных в со о тветстви и с модель ю унифиц и рованного семантического представлени я знаний, в ыражается в командах sc-маш и н обрабо т ки знаний [30]. Каж д ая sc-машина соотв е тствует ф ормально й модели о бработки и нформац и и, языком которой является некоторый s c-язык. Т а кже кажд а я sc-маш и на облада е т началь н ой информационной конструкцией и м н ожество м операци й , которые она реал и зует, кот о рые могут быть запрограммированы в ви д е процед ур .

В соответствии с многоаге н тным по д ходом ка ж дая sc-ма ш ина мож ет быть реализована в виде сово к упности агентов (sc-агентов). О перационная семантика ИНС в БЗ свод и тся к операционно й семантике реализу ю щих её s c -агентов, операцио н ная семан т ика кото р ых в свою очередь сводится к операцион н ой семан т ике программ (кома н д) их опер а ций.

Все операции sc-агентов выполняются асинхронно. Все sc-агенты вз аимодействуют через общую память, передавая друг другу данные в виде конструкций семантической сети (текстов sc-языка, состоящих из sc-элементов). Условием запуска операции (инициирования sc-агента) является некоторое событие в общей (графовой) памяти. Таким и событиями являются изменения временной непринадлежности на временную (актуальную) принадлежность элемента ситуативному множеству, которое трактуется как множество команд инициирова- ния sc-агентов. Каждая команда представляет собой данные, которые будут обработаны агентом. Такими данными могут быть отдельный sc-элемент и его се мантическая окрестность, доступная в общей памяти, или некоторая структура (sc-структу ра), обозначенная таким sc-элементом (рисунок 19).

После того как операция запущена и выполнена, времен н ая прина дл ежность з аменяется на време н ную (актуальную) н е принадле ж ность. О д нако, мог у т появит ь ся новые в ременные (актуальные) принадлежности, которые б удут иниц и ировать р аботу дру г их sc-агентов.

Рисунок 19 – Передача данны х в виде структуры

Таким образом рабо т а ИНС и процессы обработки зна н ий в БЗ сводятся к н екотором у порядку изменений вре м енной принадлежн о сти на н епринадл е жность и нао б орот. Аг е нты, которые обес п ечивают с емантическо е протоколирование [31] рабо т ы ИНС ф ормируют мет а знания в виде струк т ур специ а льного ви д а, обеспечив а ющих возможность поиска и анализа порядка работ ы ИНС, сводящемуся к взаимо д ействию s c -агентов в об щ ей графовой памяти.

Для р е ализации ИНС мож н о выдели т ь агенты следующих классов.

-

■ Аген т ы по интерпретации и обработ к е входов и выходов И НС;

-

■ Аген т ы по обучению ИНС:

-

■ А генты управления обучением И НС;

-

■ А генты семантическо г о протоко л ирования процессов обучения.

-

■ Аген т ы по интеграции раз л ичных И Н С:

-

■ А генты клонирования (агентов) И НС;

-

■ А генты поиска (агент о в) рецепт о ров ИНС;

-

■ Агенты поиска (агентов) эффекторов ИНС;

-

■ Агенты синтеза (агентов) ИНС:

-

■ Агенты синтеза (агентов) слоя ИНС.

-

■ Агенты синтеза агентов множества нейронов, синаптически связанного с множеством нейронов;

-

■ Агенты синтеза агентов дуальной сети обратного распространения (ошибок);

-

■ Агенты удаления (агентов) синаптических связей;

-

■ Агенты удаления (агентов) ИНС;

-

■ Агенты трансляции онтологического представления ИНС на языки программирования;

-

■ Агенты семантического протоколирования интеграции ИНС.

Заключение

Рассмотренные направления применения интеграций ИНС с БЗ ориентированы на учёт семантики решаемых задач, что, с одной стороны, позволит сделать решение этих задач более структурированным и прозрачным для пользователя, с другой стороны, позволит вносить дополнительные корректировки в процесс обучения нейронной сети и решения задачи. Реализация описанной ИС, а также соответствующей интеллектуальной среды, позволит уменьшить порог вхождения разработчиков в область решения задач с помощью ИНС. Предоставляемые интеллектуальной средой возможности интроспекции ИНС и сохранения состояний ИНС во время обучения позволяют обеспечить более глубокий анализ их работы.

Список литературы Интеграция искусственных нейронных сетей с базами знаний

- McCulloch, W. A Logical Calculus of Ideas Immanent in Nervous Activity/W. McCulloch, W. Pitts//Bulletin of Mathematical Biophysics, 1943, p.115-133.

- Fukushima, K. Neocognitron: A self-organizing neural network model for a mechanism of pattern recognition unaffected by shift in position/K. Fukushima//Biological Cybernetics, 1980, p.193-202.

- Bengio, Y. Learning deep architectures for AI. Foundations and Trends in Machine Learning/Y. Bengio//Foundations and Trends® in Machine Learning, 2009, Vol. 2: No. 1, p.1-127

- Hinton, G.E. A fast learning algorithm for deep belief nets/G.E. Hinton, S. Osindero, Y. Teh//Neural Computation, 2006, p.1527-1554.

- Glorot, X. Deep sparse rectifier neural networks/X. Glorot, A. Bordes, Y. Bengio//14th International Conference on Artificial Intelligence and Statistics, 2011, vol. 15, p.315-323.