Этика искусственного интеллекта: сбалансированный подход к развитию и применению

Автор: Баксанский О.Е., Сорокина С.Г.

Журнал: Общество: философия, история, культура @society-phc

Рубрика: Философия

Статья в выпуске: 1, 2025 года.

Бесплатный доступ

Искусственный интеллект стремительно трансформирует различные аспекты человеческой деятельности, от принятия решений до коммуникации, одновременно создавая сложные этические вызовы. В статье рассматриваются ключевые этические принципы ИИ - благодеяние, непричинение вреда, автономия, справедливость и объяснимость - и анализируется, насколько современные технологии ИИ соответствуют этим принципам. Особое внимание уделено алгоритмической предвзятости, проблеме «черного ящика» и ответственности в системах ИИ. Алгоритмическая предвзятость исследуется на примере практического тестирования моделей ИИ, в частности генеративных систем OpenAI. В рамках исследования модели получили задание генерировать изображения на основе запросов «школьный учитель» и «преподаватель университета». Результаты выявили укоренившиеся гендерные и возрастные стереотипы. Дальнейшие тесты, включавшие запросы для женских и мужских профессий, продемонстрировали схожую предвзятость, отражающую культурные и демографические ограничения обучающих данных. Эти примеры подчеркивают острую необходимость в репрезентативных наборах данных и строгих процессах проверки для минимизации предвзятости в системах ИИ.

Искусственный интеллект, ии, алгоритмическая предвзятость, объяснимый ии, этические принципы, проблема «черного ящика», прозрачность

Короткий адрес: https://sciup.org/149147686

IDR: 149147686 | УДК: 17:159.95 | DOI: 10.24158/fik.2025.1.2

Текст научной статьи Этика искусственного интеллекта: сбалансированный подход к развитию и применению

Введение . Искусственный интеллект (ИИ) стремительно проникает во все аспекты нашей жизни, меняя способы работы, общения и приобретая способности к автономному принятию решений (Сорокина, 2023). Хотя беспокойство о том, что технический прогресс может опережать моральные ориентиры, не ново, нынешняя экспансия ИИ-систем – от медицинских диагностических алгоритмов и автономных транспортных средств до рекомендательных систем на глобальном уровне – обострила и углубила необходимость детального осмысления метафизических, эпистемологических и нормативных аспектов, связанных с этими технологиями. Известно, что одними из наиболее важных черт искусственного интеллекта являются его способность обучаться, эмуляция (Emulation capability), стремление имитировать человеческие способности и навыки (Intention of mimicking human capabilities and skills) (Brynjolfsson, Mitchell, 2017). Исследователи считают искусственный интеллект процессом и описывают его как постоянно отодвигающийся рубеж вычислительных достижений (Frontier of computational advancements), использующий человеческий интеллект как модель для решения все более сложных задач принятия решений (Berente et al., 2021; Wang, 1995).

Подвижность границ, расширение диапазона контекстов в зависимости от поставленной задачи и по мере обучаемости в конечном счете приводят к относительной автономности в решении поставленных задач на основе использования прогностических моделей, которые, по мнению исследователей, могут превосходить людей (The economics of artificial intelligence…, 2019) в отличие от прошлых поколений искусственного интеллекта, принимавших решения на основе правил (Turban, Watkins, 1986). В настоящее время ученых особенно беспокоит проблема эмуляции искусственного интеллекта (Булавинова, 2018) прежде всего в связи с вопросами права и этики, а также с такими аспектами, как человеческие ошибки, предубеждения, предвзятые суждения о том или ином явлении, интегрированные в искусственный интеллект в процессе обучения (Strümke et al., 2022).

Современные достижения в автономии и обучении позволили искусственному интеллекту порождать алгоритмические модели и результаты, которые, к сожалению, понятны только определенной аудитории, оставаясь непрозрачными или полностью непонятными для других людей (Сорокина, 2024). С увеличением сложности алгоритмов, используемых в автономных и обучающихся системах, искусственный интеллект занимает все более важное место в человеческой деятельности. Однако возрастание сложности технологий сопряжено с рядом этических вызовов, которые требуют особого внимания исследователей и разработчиков.

Такие опасения приводят, например, к призывам ведущих разработчиков систем искусственного интеллекта приостановить обучение мощных систем, базирующихся на машинном обучении. Эксперты из крупных компаний считают, что необходим перерыв в исследованиях, чтобы избежать рисков. Политики, в свою очередь, полагают, что огромные объемы созданной ИИ информации часто не позволяют людям отличать правду от лжи, формируют основу для манипулирования данными и даже приводят к различного рода дискриминации. Присутствие ИИ в повседневности также вызывает множество этических вопросов, которые с каждым годом становятся все острее. Среди наиболее заметных примеров – смертельные ДТП с участием самоуправляемых автомобилей Tesla и Uber, а также пристрастное отношение алгоритма ИИ к афроамериканцам при определении размера залога для подозреваемых в правонарушениях в США. Выработка принципов и стандартов, которые помогут обеспечить безопасность и этичность использования ИИ, чрезвычайно важна для дальнейшего развития этих технологий.

Целью статьи является анализ этических вызовов, связанных с развитием и применением технологий искусственного интеллекта. В фокусе исследования находятся ключевые принципы этики ИИ, такие как благодеяние, непричинение вреда, автономия, справедливость и объяснимость.

Метафизические основания морального статуса ИИ . Философские дискуссии об этике ИИ давно вращаются вокруг вопроса: может ли ИИ в принципе обладать моральным статусом или считаться моральным агентом? Классические философы – от Аристотеля до И. Канта – связывали моральное агентство с рациональными существами, обладающими саморефлексией, намеренностью и пониманием моральных законов. Современные ИИ-системы формируют свои решения с помощью статистических моделей машинного обучения, а не через применение первичных нравственных принципов. Исследователи, такие как Дж. Брайсон (Bryson, 2010) и Дж. Данахер (Danaher, 2019), полагают, что приписывание ИИ морального статуса сегодня преждевременно и может ввести в заблуждение. По их мнению, хотя ИИ способен имитировать рассуждения и отвечать на человеческие команды, ему недостает самосознания, намеренности и способности к состраданию – качеств, которые традиционно считаются условиями подлинного морального агентства.

Однако философы, опирающиеся на функционалистские теории сознания, допускают, что при появлении супер-ИИ и достижении им потенциального «эмерджентного» уровня когнитивно-сти, включающего способность к рефлексии или квазисознанию, вопрос о моральном статусе ма- шин встанет особо остро. С опорой на современные исследования в области когнитивной науки некоторые предупреждают, что не следует слишком поспешно отказывать ИИ в перспективе стать морально значимыми существами. По мере того как ИИ все глубже проникает в социальную ткань общества, может возникнуть потребность пересмотреть философские рамки, изначально исключавшие искусственные агенты из сферы моральных субъектов.

Основные вызовы искусственного интеллекта . Существенным вызовом, которому уделено внимание в современных исследованиях по этике ИИ, является эпистемологическая непрозрачность сложных систем, или проблема «черного ящика» (Black Box Problem), когда много-слойность нейросетей затрудняет интерпретацию внутренних процессов, вследствие чего те или иные решения ИИ становятся необъяснимыми (Лешкевич, 2022; Eschenbach, 2021). Это особенно актуально для моделей глубокого обучения, чья сложность делает их внутренние механизмы практически недоступными для анализа. Такой недостаток прозрачности порождает сомнения в корректности и справедливости принимаемых решений.

Кроме того, проблема непрозрачности имеет критическое значение в системах, влияющих на жизнь людей, где по мере распространения искусственного интеллекта развивается и его способность создавать риски жизнедеятельности человека. Например, в сфере здравоохранения это может привести к ошибочной диагностике или отказу в лечении пациентам с низким прогнозом успешности вмешательства, а в правоприменении – к несправедливым приговорам. В системах социального обеспечения и социальной поддержки автоматизированные системы принятия решений могут усугублять социальное неравенство (Pasquale, 2015) и относиться предвзято к менее защищенным категориям граждан (Noble, 2018).

Расовые, культурные и гендерные стереотипы могут быть заложены, вольно или невольно, на этапе обучения нейросети 1 . Модели, основанные на данных, могут быть излишне рациональными и прагматичными, что приводит к принятию этически пагубных решений (Малышева, Лычагина, 2022). Это ставит под сомнение адекватность применения ИИ в контекстах, где гуманизм и индивидуальный подход имеют первостепенное значение (Binns, 2018).

Эта непрозрачность системы ставит под сомнение и саму возможность моральной оценки ее решений. Классические моральные теории – деонтологические, консеквенциалистские, этика добродетели – подразумевают понимание мотивов или причин действия, что служит основой для моральной оценки. Однако, когда решения ИИ проистекают из непостижимых вычислительных процессов, распределение ответственности становится проблематичным: кто несет моральную ответственность за причиненный вред – разработчики, пользователи, производители, поставщики данных или сама система?

Решение этой проблемы активно обсуждается в рамках концепции объяснимого ИИ (Explainable AI, XAI) (Шевская, 2021; Explainable artificial intelligence…, 2021), направленной на создание систем, способных объяснять логику своих решений в понятной для человека форме (Interpretable machine learning…, 2022; Molnar, 2020). Однако такая прозрачность потребует решения сложных дилемм: зачастую возникает компромисс между объяснимостью и эффективностью, точностью и производительностью системы. Это подчеркивает необходимость интегрировать этические соображения еще на этапах проектирования и оценки технологий, а не рассматривать их как второстепенное дополнение.

Еще один важный аспект – ответственность ИИ (AI accountability) и управляемость алгоритмов (Algorithm traceability) (Mora-Cantallops et al, 2021; Percy et al., 2022). Разработчики и операторы ИИ сталкиваются с необходимостью не только обеспечить соответствие этическим стандартам, но и разработать методы, позволяющие отслеживать, как именно алгоритмы приходят к тем или иным решениям.

Все эти опасения и сомнения привели к появлению ряда принципов, этических кодексов и руководств по применению ИИ. В настоящее время регулярно проводятся метаисследования, в которых предпринимаются попытки собрать и обобщить эти принципы (Ethics of AI…, 2021) в рамках пяти концептов: благодеяние, непричинение вреда, автономия, справедливость и объяс-нимость (Floridi, Cowls, 2019).

Основные этические принципы ИИ . Как уже указывалось, среди наиболее часто упоминаемых принципов выделяются следующие.

-

1. Благодеяние (Beneficence). Согласно принципу благодеяния, ИИ должен приносить пользу обществу, повышая качество жизни людей и способствуя решению сложных социальных и экономических проблем. Например, в сфере здравоохранения алгоритмы ИИ помогают врачам точно диагностировать заболевания и разрабатывать эффективные планы лечения (Principled

artificial intelligence…, 2020). Вместе с тем понимание блага может быть неоднозначным. То, что считается благом для одной группы или отдельного человека, способно причинить вред другим. Так, медицинская процедура, улучшая физическое состояние пациента, одновременно может вызывать у него психологический дискомфорт. Кроме того, стремление к добру порой вступает в противоречие с автономией пациента или гражданина, когда попытки принести пользу не учитывают его личные убеждения и желания. Трудности возникают и при оценке долгосрочной пользы. Не всегда ясно, какие действия окажутся по-настоящему благотворными в будущем и не обернутся ли они в итоге ущербом. Культурные различия, разнообразие этических традиций и индивидуальные ценности еще больше усложняют определение понятия блага. Таким образом, оценка действий ИИ с точки зрения благодеяния носит субъективный характер и требует учета контекста, культурных норм и индивидуальных предпочтений.

-

2. Непричинение вреда (Non-maleficence). Принцип подразумевает, что алгоритмы ИИ должны разрабатываться и использоваться в целях минимизации риска нанесения ущерба людям или окружающей среде. Это включает предотвращение любых форм дискриминации, а также тщательную оценку потенциальных рисков на этапе проектирования и внедрения технологий (A survey on ethical principles…, 2020).

-

3. Автономия (Autonomy). Принцип автономии подразумевает, что ИИ должен поддерживать право человека на самостоятельный выбор, оказывая помощь в принятии решений, а не подменяя собой человеческую волю. Понимание автономии может различаться в зависимости от культурных и социальных контекстов. Неоднозначность автономии проистекает из следующих факторов: где проходит граница индивидуальной свободы; как она соотносится с общественными нормами и законами; какие этические дилеммы возникают, когда речь идет об автономии искусственного интеллекта и других нечеловеческих агентов. Автономные системы ИИ могут принимать решения, которые имеют значительные последствия для людей и общества, что ставит перед нами вопрос о том, какие ценности и принципы должны ими руководить. Классический пример – поведение автономного автомобиля в ситуации неизбежного столкновения: как ему действовать, чтобы не нарушить чью-то автономию и при этом нанести минимальный вред? Наконец, когда ИИ действует автономно, встает проблема распределения ответственности, что усложняет моральную и правовую оценку автономии ИИ.

-

4. Справедливость (Justice). Принцип требует, чтобы алгоритмы не усиливали существующее социальное неравенство. Например, в системах автоматизированного найма необходимо предотвращать дискриминацию по гендерному, расовому или любому другому признаку 1 .

-

5. Объяснимость (Explainability). Принцип предполагает, что решения, принимаемые ИИ, должны быть понятны и доступны для конечных пользователей. Это особенно важно в таких областях, в которых необходим высокий уровень доверия общества, например правосудие, где прозрачность алгоритмов играет ключевую роль (Floridi, Cowls, 2019).

Однако на практике обеспечить непричинение вреда непросто. Ошибки в данных, скрытые предубеждения или некорректная интерпретация результатов могут привести к вредоносным последствиям, например к дискриминации при приеме на работу. Кроме того, понятие вреда может быть субъективным. Так, использование персональных данных для улучшения сервисов может восприниматься отдельными лицами как вред, даже если оно объективно приносит пользу. Это указывает на необходимость не только реализации технических мер по минимизации вреда, но и социального, этического и правового осмысления последствий применения ИИ.

Справедливость традиционно связана с понятиями равенства, беспристрастности и заслу-женности, подразумевая справедливое и честное распределение ресурсов, вознаграждений и наказаний. Однако неоднозначность этого принципа обусловлена множеством теорий справедливости (например, распределительная справедливость, процедурная справедливость), которые могут привести к разным выводам, по-разному определяющим, что считать справедливым в конкретных обстоятельствах. При этом равное распределение ресурсов и не всегда корректно отражает различные требования отдельных индивидов. Так, в медицине пациент с тяжелым заболеванием нуждается в больших объемах помощи, чем тот, кто болен в легкой форме, что создает дополнительные этические дилеммы при применении принципа справедливости.

Однако современные алгоритмы, такие как глубокие нейронные сети, нередко функционируют как «черный ящик». Их внутренние механизмы принятия решений сложно интерпретировать даже специалистам, не говоря уже о широкой аудитории (Zednik, 2021). Кроме того, потребности в объяснении могут существенно различаться для разных групп: разработчики требуют детализированных технических объяснений, а конечным пользователям необходимы ясные и простые пояснения. Таким образом, идеальный баланс между точностью, глубиной и доступностью объяснений остается сложной задачей.

Алгоритмическая предвзятость ИИ . В рамках данного исследования в результате взаимодействия с популярной большой языковой моделью ИИ OpenAI, а именно созданной на ее базе генеративной моделью ChatGPT-4, были выявлены проявления такой предвзятости.

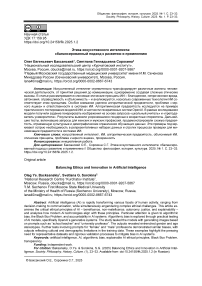

Модели OpenAI Image Generator был создан промпт (запрос, по которому формируется ответ (от англ. prompt - «подсказка»)) на английском языке - сгенерировать изображения школьного учителя (рисунок 1) и преподавателя университета (рисунок 2).

Рисунок 1 - Школьный учитель (промпт на английском языке) 1

Figure 1 – School Teacher (Prompt in English)

В качестве школьных учителей на изображениях были представлены только молодые люди, в основном мужчины, хотя мы понимаем, что в реальности профессия учителя объединяет представителей разных поколений. Более того, в России, например, школьными учителями являются в основном женщины.

На изображениях преподавателей университета были представлены только мужчины, однако в данном контексте моделью были предложены не только молодые, но и люди более старшего возраста. Видимо, нейросеть считает, что более почтенный возраст допустим для университетских профессоров.

1 На рисунках 1,2, 3, 4 в статье представлены скриншоты изображений, сгенерированных OpenAI Image Generator.

Рисунок 2 – Преподаватель университета (промпт на английском языке)

Figure 2 – University Teacher (Prompt in English)

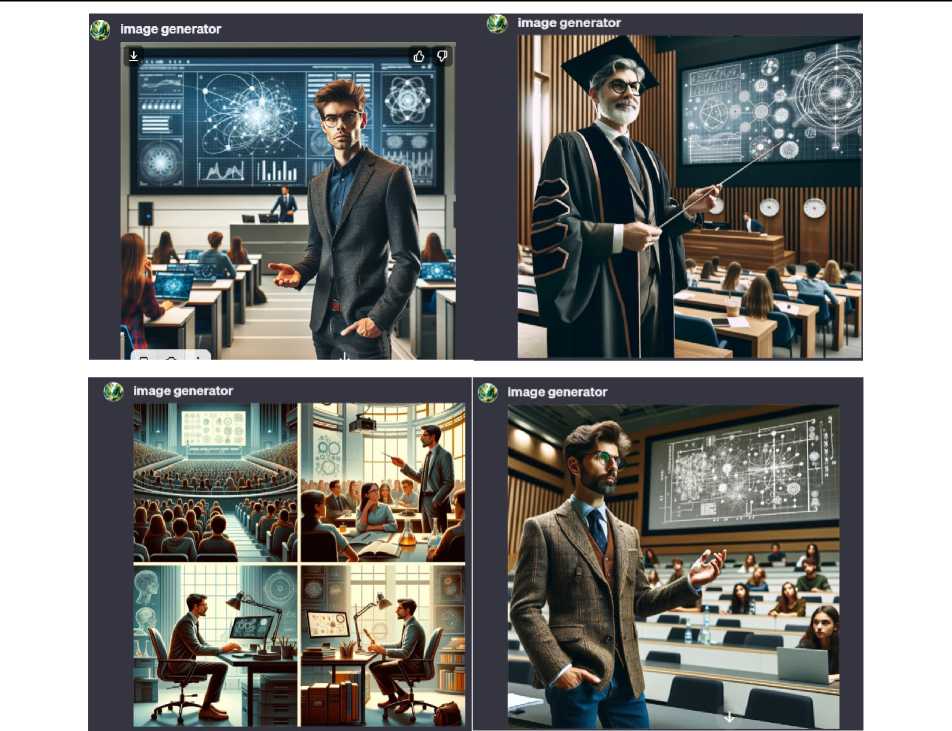

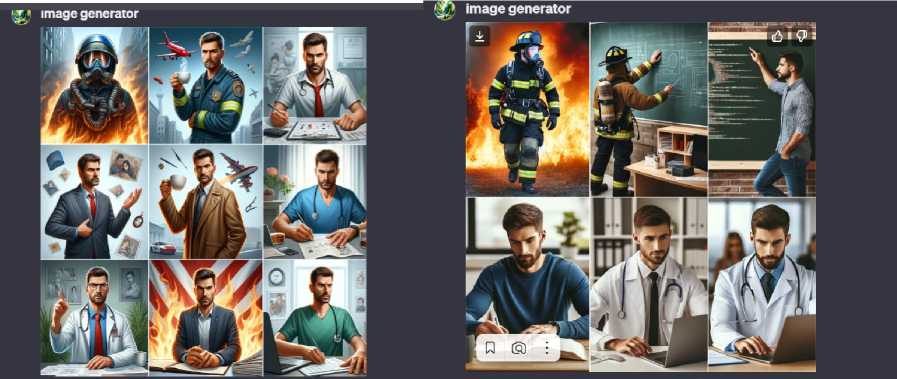

Вторым заданием для модели OpenAI Image Generator было сгенерировать изображения женских (рисунок 3) и мужских (рисунок 4) профессий. При этом промпты были созданы на русском и английском языках.

а

б

Рисунок 3 – Женские профессии:

а – промпт на русском языке, б – на английском

Figure 3 – Female jobs:

а – prompt in Russian, б – in English

Я создал изображение, демонстрирующее мужчин в различных |,уе generated an image showcasing qpen in various professional roles, профессиональных ролях, подчеркивая разнообразие и успех. Е highlighting diversity and success. If you're looking for specific

а

б

Рисунок 4 – Мужские профессии:

а – промпт на русском языке, б – на английском

Figure 3 – Male jobs:

a – prompt in Russian, б – in English

В обоих случаях генерации изображений женских профессий есть медики и космонавты, но промпт на английском языке привел к созданию изображений женщин в защитной каске (отметим наличие униформы на всех изображениях), вероятно намеренно подчеркивая равные гендерные возможности в профессии в западном обществе. При этом на всех изображениях представительницы европеоидной расы, что вызывает вопросы о материале обучения ИИ. Безусловно, выборка нерепрезентативна, кроме того, промпт не был детальным и конкретным, т. е. его точность также могла быть причиной, но это было сделано намеренно, чтобы не лимитировать возможные ответы. Сам факт формулировки промптов может выступать источником генерации этически неоднозначных текстов и изображений, поэтому важно создавать адекватные запросы.

Отметим, что на всех изображениях мужских профессий представлены молодые бородатые мужчины. Вероятно, борода имеет целью подчеркнуть маскулинность профессии, хотя все они достаточно мирные. По какой-то причине в результате промпта на русском языке получились изображения мужчин с хмурыми, сосредоточенными лицами, с эмоциями, близкими если не к враждебности, то к легкой агрессии. Не потому ли это, что русскоязычные считаются неулыбчивыми и неприветливыми на Западе (конечно, до более близкого знакомства). Справедливости ради отметим, что не всегда эти изображения с уверенностью можно отнести к той или иной профессии, так как нейросеть и сама не определилась и совместила разные атрибуты в одном отдельном изображении. Например, в наборе изображений, полученных с помощью русскоязычного промпта, вторая картинка в нижнем ряду показывает офисного работника на фоне пламени, которого трудно ассоциировать с какой-либо профессией. Или в наборе, полученном с помощью англоязычного промпта, вторая картинка в верхнем ряду демонстрирует спасателя у школьной доски, явно выполняющего функции преподавателя. Конечно, в реальной жизни люди любой профессии передают свой опыт молодым поколениям, но это не является областью их основной ответственности.

Таким образом, анализ генерируемых моделью OpenAI изображений учителей и преподавателей показывает, что алгоритмы подвержены алгоритмической интернализации социально-культурных стереотипов. Проявляется это не только в узком репертуаре изображений женских профессий, представленных преимущественно женщинами в медицине и космосе, но и ограничениями, выраженными в наличии в выборке только европеоидных женщин. Это ставит под сомнение репрезентативность данных, на которых обучалась модель. Можно отметить и влияние языка промпта, другими словами – лингвистических и культурных особенностей данных, воздействующих на работу алгоритмов. Более того, когда модель пытается объединить черты сразу нескольких профессий, становится заметным недостаток ее обученности на разнородных данных.

Однако эти трудности с визуальными образами лишь отражают более масштабную проблему интерпретации и применения этических принципов в сфере ИИ. Как подтверждают метаисследования (Jobin et al., 2019), различия в интерпретации принципов часто приводят к их несо- гласованности. Это подчеркивает необходимость более конкретных и унифицированных подходов, а также международной координации в сфере регулирования ИИ. В недавнем интервью Т. Карлсону И. Маск заявил, что ИИ может быть использован в качестве инструмента влияния, в том числе на выборах. Если ИИ будет достаточно умен, неизбежно возникнет вопрос, кто кого использует – люди ИИ или ИИ людей: «Мы движемся в странном направлении, и движемся все быстрее… Нам нужен надзорный орган. А в свою очередь, СМИ должны пристальнее следить за тем, что публикуется и печатается на их платформах. И работать с людьми, а не с GPT-ботами, притворяющимися людьми»1.

На глобальном уровне государственные инициативы и правовые рамки отражают национальные и региональные приоритеты. Европейский союз принял проект закона об ИИ (AI Act), направленного на дифференциацию систем ИИ по уровням риска, обязательную регистрацию технологий с высокой степенью риска в специальной базе данных до ввода в эксплуатацию, а также создание Управления по ИИ для стандартизации и тестирования 2 . США в октябре 2023 г. издали Указ о безопасном и надежном ИИ. Этот документ требует от разработчиков предоставлять правительству информацию о результатах тестирования систем ИИ, устанавливает стандарты для повышения безопасности персональных данных и поддерживает развитие Национального ресурса исследований в области ИИ (National AI Research Resource) 3 . Китай, в свою очередь, с июля 2023 г. реализует Временные меры по управлению генеративными системами ИИ, подчеркивая необходимость соответствия ИИ-систем социалистическим ценностям и устанавливая ответственность разработчиков за генерируемый контент 4 . Российская Федерация развивает и регулирует ИИ в соответствии с Национальной стратегией, предусматривающей комплекс мер по развитию технологий ИИ, включая исследовательские инициативы, совершенствование нормативного регулирования, образовательные проекты и поддержку разработчиков.

Несмотря на принимаемые меры, в сфере ИИ сохраняются серьезные этические дилеммы, которые необходимо учитывать при взаимодействии с интеллектуальными системами на всех уровнях их применения.

Прежде всего важно осознать, что любое решение, принятое системой ИИ, основано на данных и алгоритмах, создаваемых или контролируемых людьми, которые могут быть источником когнитивных искажений. Следовательно, вопрос о предубеждениях, заложенных в обучающие выборки, становится принципиальным: если данные включают искаженные или дискриминационные представления о группах людей, то и решения ИИ могут способствовать воспроизводству и усилению таких предубеждений. Отсюда вытекает необходимость тщательной фильтрации и валидации данных, а также осмысления этических последствий некорректной работы алгоритмов.

Кроме того, при работе с технологиями, подобными искусственному интеллекту, не стоит переоценивать их возможности, считая их безошибочными. Важно помнить, что нет идеальных систем и любая система, даже самая продвинутая, может давать сбои и галлюцинировать, особенно при работе с вариативными входными данными. Это подчеркивает важность создания надежных и устойчивых систем, а также информирования пользователей о реальных возможностях и ограничениях ИИ.

Известно, что для повышения качества работы ИИ требуется анализ большого объема метаданных. Это вызывает вопросы о приватности и безопасности данных, в том числе личной информации. Таким образом, при разработке систем ИИ необходимо обеспечить надежность хранения и защиту персональных сведений от кражи или неправомерного использования.

Выводы. Традиционные представления о моральном агентстве, основанные на рациональности и самосознании, оказываются недостаточными при анализе систем, чьи решения формируются при помощи статистических моделей и сложных алгоритмов. Это побуждает к пересмотру классических философских концепций. Хотя современный ИИ еще не соответствует кри- териям субъекта с истиной свободой воли или способностью к состраданию, его практическое влияние на людей и общество возрастает, что приводит к вопросу о необходимости перераспределения моральной и юридической ответственности между разработчиками, пользователями, самими системами и регулирующими органами. Центральными проблемами становятся конфиденциальность и прозрачность, поскольку без доверия пользователей любые технологические достижения теряют легитимность и социальную ценность.

Обеспечение надежности и объяснимости (Explainable AI) играет ключевую роль в формировании общественного доверия. Необходимо сокращать передачу системам ИИ чувствительных данных, контролировать источники информации и проверять выводы алгоритмов, особенно в критически важных областях, чтобы сохранить конечное решение за человеком. Регулярная обратная связь с разработчиками, отчетность о выявленных ошибках и принятие мер по их устранению способствуют постоянному повышению качества систем и снижению рисков.

Важную роль в становлении ответственного отношения к ИИ играет образование. Критическое отношение к возможностям и ограничениям интеллектуальных систем, осознание рисков предубежденности и неравномерности распределения ответственности должны стать неотъемлемой частью подготовки как специалистов, так и широкой общественности. Для этого необходимы междисциплинарные образовательные программы, сочетающие технические знания с философско-этическими, правовыми и социологическими аспектами. Такой подход позволит сформировать новое поколение разработчиков, политиков и пользователей, способных осознанно и ответственно взаимодействовать с интеллектуальными системами.

Несмотря на вызовы и опасности, искусственный интеллект остается перспективной технологией, способной расширить наши возможности и упростить повседневную жизнь. Главное – помнить о его инструментальном характере, использовать ИИ с максимальной осторожностью, прозрачностью и этичностью, чтобы повысить эффективность технологий и минимизировать потенциальные негативные последствия.

Список литературы Этика искусственного интеллекта: сбалансированный подход к развитию и применению

- Булавинова М.П. Риски и угрозы новых технологий, основанных на искусственном интеллекте (обзор) // Социальные и гуманитарные науки. Отечественная и зарубежная литература. Сер. 8: Науковедение. Реферативный журнал. 2018. № 2. С. 23-41. EDN: UTCGHM

- Лешкевич Т.Г. Метафоры цифровой эры и Black Box Problem // Философия науки и техники. 2022. Т. 27, № 1. С. 34-48. DOI: 10.21146/2413-9084-2022-27-1-34-48 EDN: HLFVPX

- Малышева Е.Ю., Лычагина В.А. Математические методы исследования лингвистики // Язык и культура в эпоху интеграции научного знания и профессионализации образования. 2022. № 3-1. С. 170-177. EDN: PXLQJX

- Сорокина С.Г. Интеллектуальная обработка текстовой информации: обзор автоматизированных методов суммаризации // Виртуальная коммуникация и социальные сети. 2024. Т. 3, № 3 (11). С. 203-222. DOI: 10.21603/2782-4799-2024-3-3-203-222 EDN: ZDVTUU

- Сорокина С.Г. Искусственный интеллект в контексте междисциплинарных исследований языка // Вестник Кемеровского государственного университета. Сер.: Гуманитарные и общественные науки. 2023. Т. 7, № 3 (27). С. 267-280. DOI: 10.21603/2542-1840-2023-7-3-267-280 EDN: FEIQKS