Метод контроля состояния подсистемы (объекта) при неполной измерительной информации о совокупности параметров, определяющих ее динамику. II. Нейронные сети, отражающие динамику входной информации и построенные на принципе обратных связей (рекуррентные сети)

Автор: Малыхина Г.Ф., Меркушева А.В.

Журнал: Научное приборостроение @nauchnoe-priborostroenie

Рубрика: Обзоры

Статья в выпуске: 3 т.14, 2004 года.

Бесплатный доступ

В информационно-измерительных системах (ИИС) и информационно-управляющих системах (ИУС), отражающих состояние контролируемого объекта (подсистемы), существенна проблема отображения в условиях отсутствия воздействия некоторых параметров состояния на датчики измерительной системы, т. е. при неполной измерительной информации. Решение этой проблемы получено на основе анализа уравнений динамики системы объект-ИИС (в пространстве параметров состояния) и использования алгоритмов нейронных сетей (НС), способных отражать изменение входных данных во времени. Вторая (из 3) часть статьи рассматривает структуру и обучение НС, построенных на принципе обратных связей и называемых рекуррентными.

Короткий адрес: https://sciup.org/14264343

IDR: 14264343 | УДК: 681.51+

Текст научной статьи Метод контроля состояния подсистемы (объекта) при неполной измерительной информации о совокупности параметров, определяющих ее динамику. II. Нейронные сети, отражающие динамику входной информации и построенные на принципе обратных связей (рекуррентные сети)

ВВЕДЕНИЕ В РЕКУРРЕНТНЫЕ НЕЙРОННЫЕ СЕТИ

Кроме известной сложности проблемы обработки и анализа нестационарного сигнала в информационно-измерительных системах (ИИС), решению которой посвящен ряд работ [1–4], значительные трудности возникают при интерпретации многомерного сигнала параметров состояния контролируемого объекта в случае, если часть его компонент находится вне зоны чувствительности измерительных датчиков. На решение этой проблемы неполной измерительной информации о состоянии динамического объекта (подсистемы) направлен метод, который основан на представлении уравнений динамики и наблюдения контролируемого объекта в рекуррентной форме и на использовании нейронной сети (НС), отражающей динамику входной информации. В [5] применительно к общей задаче показаны особенности темпоральных НС прямого распространения.

Для метода контроля параметров состояния динамического объекта средствами ИИС при неполной информации здесь анализируются НС, построенные на принципе обратных связей (рекуррентные сети). В отличие от темпоральных НС прямого распространения, в которых реакция на динамику входных данных связана с кратковременной памятью, реализованной на сосредоточенных (в последовательности) или распределенных элементах временнóй задержки (ЭВЗ), НС рекур- рентного типа отличаются тем, что в их структуре используются обратные связи, охватывающие всю НС или отдельные ее слои. Такие рекуррентные нейронные сети (РНС) с глобальными или локальными обратными связями (ОС) сравнительно с темпоральными НС прямого распространения имеют несколько меньшие требования к памяти и рассматриваются как адаптивное устройство отображения вход—выход.

В круг задач, решаемых с помощью РНС, входит нелинейное предсказание, адаптивное выравнивание каналов связи (проблема эквализации), обработка речи, контроль производственнотехнологических процессов по критерию оптимальной динамики и элементы технической диагностики.

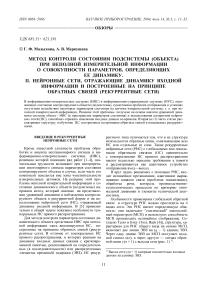

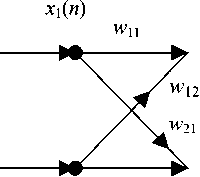

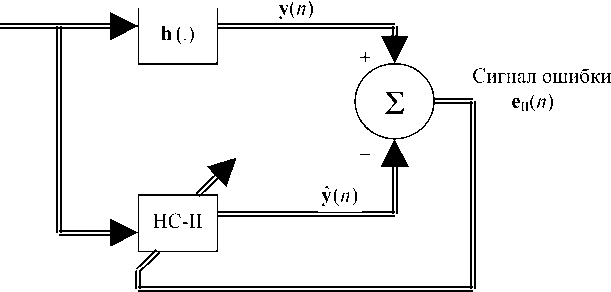

Особенности применения глобальной обратной связи в структуре РНС можно проследить на 4 видах сети. Эти РНС имеют определенную общность: они включают "статический" многослойный персептрон (МСП) и используют способность МСП производить нелинейное отображение. Согласно Тсою и Бэку (Tsoi, Back [6]), структура, характерная для РНС общего вида на основе МСП, включает две линии ЭВЗ на ( q – 1) единиц ЭВЗ. Через одну линию ЭВЗ на МСП поступает входной сигнал u ( n ), а через другую — сигнал обратной связи y ( n + 1) с выхода сети (рис. 1) 1).

Такая структура представляет отображение вход—выход, эквивалентное нелинейной авторегрессии (НАР) с входом на линии ЭВЗ (НАР_ВЗ). На вход НАР_ВЗ подается q -мерный вектор u ( n ) = = [ u (1), u (2),..., u ( n - q + 1)]T и аналогичный q- вектор задержанных значений выхода РНС y ( n ) = [ у (1), у (2),., у ( n - q + 1)]T. Так что выход РНС y ( n + 1) определяется нелинейной авторегрессионной зависимостью вида

У ( n + 1) =

= F(у (1), у РХ-. у ( n - q + 1), u (1), u (2),., u ( n - q + 1)). (1)

Модель НАР_ВЗ отражает особенность общей ОС, однако РНС может использовать и локальные ОС, которые охватывают один или несколько отдельных слоев МСП.

Входной

Рис. 1. Модель нелинейной авторегрессии с временной задержкой внешнего входа (НАР_ВЗ) на основе РНС

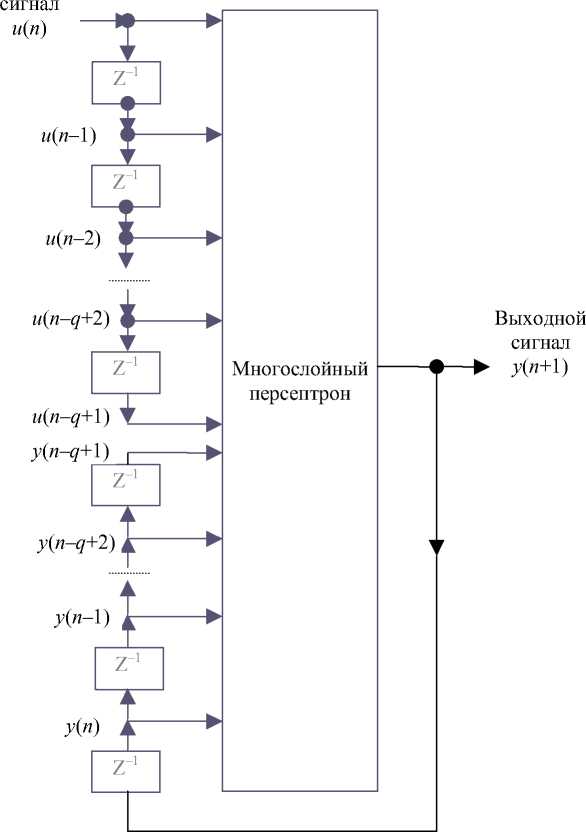

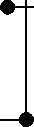

Рис. 2. Модель пространства состояний — прототип РНС Элмана

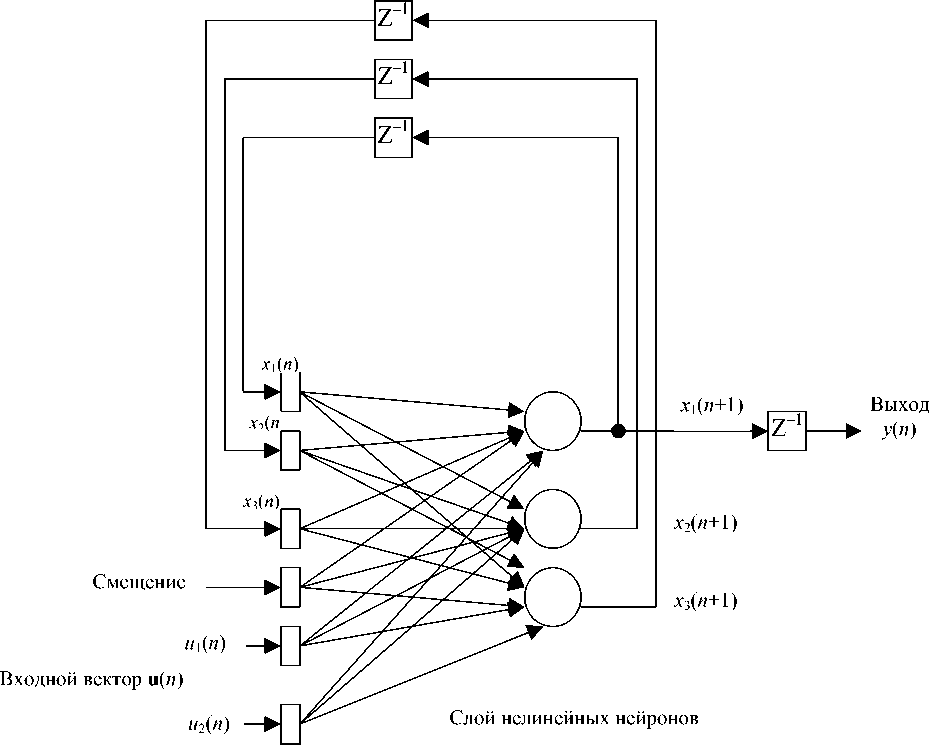

РНС И МОДЕЛЬ ПРОСТРАНСТВА СОСТОЯНИЙ

Для целей метода интерпретации измерений при недостаточной информации2) полезно рассмотреть структуру НС (рис. 2), которая служит прототипом РНС Элмана (Elman [7]), является РНС на основе рекуррентного МСП (Р_МСП), а также хорошо моделирует пространства состояний. Скрытые нейроны определяют состояние сети. Выход скрытого слоя x ( n +1) подается через q -блок ЭВЗ 3) на вход РНС. Этот же вектор-сигнал x ( n +1) через выходной слой, состоящий из линейных нейронов, в виде вектора y ( n +1) подается через p -блок ЭВЗ на выход РНС (вектор y ( n )). Таким образом, входной слой этой РНС состоит из объединения q узлов обратной связи и m узлов источника внешнего воздействия на сеть ( m равно размерности вектора u ( n ), u ( n ) = [ u 1 ( n ), u 2 ( n ),…, u m ( n )]T), а число ЭВЗ в блоке обратной связи ( q ) равно размерности вектора x ( n ) = [ x 1 ( n ), x 2 ( n ),…, x q ( n )]T. Величина q определяет порядок РНС.

Описание в дискретном времени динамики модели пространства состояний 4) определяется уравнениями:

x ( n + 1) = f ( x ( n ), u ( n )), (2)

y ( n ) = C ∙ x ( n ), (3) где f — нелинейная функция, характеризующая скрытый слой, а C — матрица синаптических весов, определяющая выходной слой.

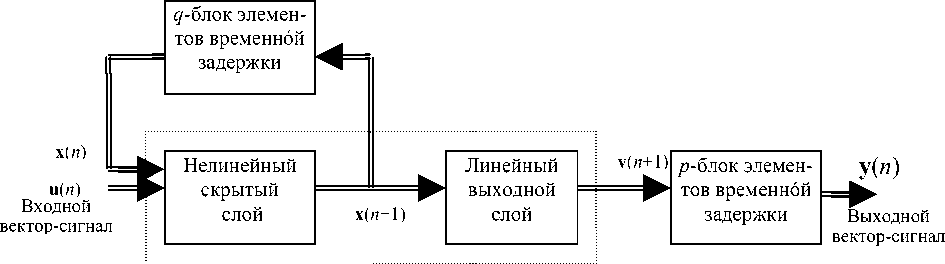

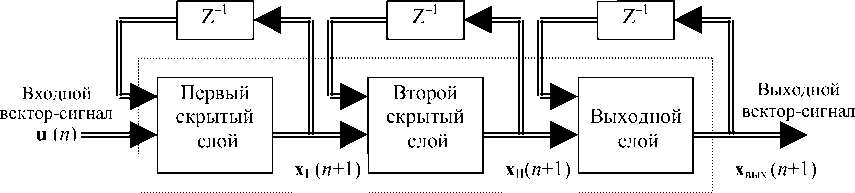

Принцип такого описания НС вполне соответствует модификации Элмана в виде простой РНС [7] и модификации Пускориуса и Фельдкампа (Puskorius, Feldkamp) в виде рекуррентного многослойного персептрона (Р_МСП) [8]. Структура Элмана (рис. 3, а) содержит рекуррентные связи от скрытых нейронов через блок ЭВЗ (слой контекстных элементов) на входные узлы ОС. На другую часть входных узлов подается (как и в описанной выше общей структуре) вектор-сигнал ("управляющий" вектор).

Основой простой РНС Элмана служит однослойный персептрон. РНС на основе Р_МСП (рис. 3, б) имеет одну или несколько ОС, каждая из которых охватывает один слой Р_МСП, т. е. подает через блок ЭВЗ выходной сигнал слоя на его входные узлы, общее число которых позволяет передавать на вход этого слоя также и выход предыдущего слоя 5).

При использовании индексов I, II и вых. для первого, второго и выходного слоев Р_МСП и тех же индексов для нелинейной функции ϕ преобразования сигнала этими слоями модель пространства состояний для Р_МСП описывается соотношениями:

а

Входной вектор-сигнал u ( n )

Контекстный слой

Выходной вектор-сигнал Х вых. ( n +1)

б

X I ( n ) Xn ( n ) Х вых. ( n )

Рис. 3. Простая структура РНС на персептроне с одним скрытым слоем (а) и РНС общего вида на многослойном персептроне с несколькими скрытыми слоями (б)

X i ( n + 1) = ф т ( х т ( n ), u ( n ));

x ii ( n + 1) = фп( хп ( n ), x i ( n )); (4)

Хвых.(n + 1) = фвых. (xвых.(n), Xk(n + 1)), где k — число скрытых слоев в НС.

Описанная структура Р_МСП является обобщением НС Элмана и показывает расширенную трактовку модели пространства состояний, поскольку функции преобразования отдельных слоев Р_МСП могут быть различными.

ЭЛЕМЕНТЫ ТЕОРИИ МОДЕЛИ ПРОСТРАНСТВА СОСТОЯНИЙ

Как отмечено выше, метод интерпретации данных ИИС при недостатке измерительной информации существенно использует концепцию моде- ли пространства состояний. Согласно Сонтагу (Sontag [10]), состояние динамической системы (ДС) определяется как совокупность величин, которые, объединяя всю информацию относительно прошлого поведения ДС совместно с данными о внешнем воздействии на систему, позволяют описать будущее ДС. При анализе нелинейной ДС (в форме с дискретным временем), которая контролируется с помощью некоторой ИИС, используется представление ДС уравнениями:

x ( n + 1) = ф ( W a • x ( n ) + W b • u ( n )); (5)

y ( n ) = C • x ( n ), (6)

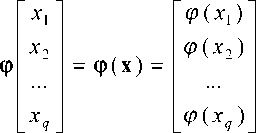

где q-мерный вектор x(n) имеет компонентами q параметров состояния, m-мерный вектор u(n) = = [ui(n), u2(n),..., um(n)] — входное воздействие на ДС; p-мерный вектор y(n) = [у 1(n), у 2( n),..., yp (n )]T — вектор-сигнал выхода ДС. Вектор y(n) — это из- мерительные данные (получаемые в ИИС), которые имеют совокупную эффективность системы датчиков, описываемую матрицей С размерности (p×q). В (5), (6) (q×q)-матрица Wa представляет синаптические веса q нейронов скрытого слоя, которые связаны обратной связью с узлами входного слоя; (q×m)-матрица Wb представляет веса тех скрытых нейронов, которые связаны с узлами источника воздействия, находящимися во входном слое (считается, что элементы смещения также включены в рассматриваемые матрицы); (p×q)-матрица С представляет синаптические веса p линейных нейронов в выходном слое. Нелинейная вектор-функция ф(.) с идентичными компонентами определяет отображение в q-мерном пространстве состояний

R q ф > R q в форме

Пространства R m , R q , R p называют входным пространством, пространством состояний и выходным пространством, а величину q — порядком ДС. Рис. 2 представляет сигнально-потоковый граф динамической системы по рекуррентной модели пространства состояний порядка q с m входами и p выходами. Уравнение (6) является уравнением измерения.

В описанной структуре Р_МСП параметры пространства состояний (скрытого слоя) определяются только теми нейронами, выходы которых идут через блок ЭВЗ на обратную связь; к ним не относятся нейроны выходного слоя. Другой вид рекуррентной структуры на персептроне с одним или несколькими слоями дан на рис. 3, где выход НС или отдельного слоя (как на рис. 3, б) подается в виде обратной связи на вход НС или на вход соответствующего слоя.

УПРАВЛЯЕМОСТЬ И НАБЛЮДАЕМОСТЬ В МОДЕЛИ ПРОСТРАНСТВА СОСТОЯНИЙ

ДЛЯ ДИНАМИЧЕСКОЙ СИСТЕМЫ

Как модели пространства состояний ДС, в которых состояние представляется набором компонент вектора-сигнала нейронов скрытого слоя (рис. 2), могут быть представлены многие РНС. Поэтому важны такие признаки модели ДС, как управляемость и наблюдаемость [11]. РНС (как любая ДС) считается управляемой, если любое ее состояние достижимо за несколько временных шагов при любом исходном состоянии. Наблюдаемость — это возможность определения текущего состояния НС из конечного набора измерений сигналов входа и выхода.

Наиболее важны локальные формы управляемости и наблюдаемости, в частности в окрестности точки равновесия [12]. Если за точку равновесия принять точку x , то для нее будет выполняться условие x = ф ( A • x + B ^ u ). Изменением начала отсчета можно привести точку равновесия в точку x = 0 , u = 0 , для которой справедливо условие 0 = ф (0). Кроме того, суть условий управляемости и наблюдаемости, согласно [13], достаточно проанализировать для случая одномерных входа и выхода, для которого уравнения (5), (6) принимают вид:

x ( n + 1) = ф ( W a • x ( n ) + W b - u ( n )), (8)

y ( n ) = c T∙ x ( n ), (9) где w b и c — векторы; y ( n ) и u ( n ) — скалярные величины.

В окрестности точки равновесия ( x = 0 , u = 0) уравнения (8), (9) можно линеаризовать, сохраняя один член в разложении Маклорена (разложении Тейлора в окрестности нуля):

S x ( n + 1) = ф '( 0 ) W S n ) + ф '( 0 ) W b- 8 u ( n ), (10) где S x ( n ) и S u ( n ) — малые смещения вектора состояния x ( n ) и управления u ( n ); ф '( 0 ) — якобиан от ф ( v ) относительно своего аргумента v в точке v = 0 . Линеаризованная система уравнений имеет вид

S x ( n + 1) = A S x ( n ) + b S u ( n ); (11)

S y ( n ) = c T S x ( n ), (12) где ( q × q )-матрица A и q -вектор b определяются соотношениями:

A = ф'(0) Wa, b = ф'(0) wb.

Уравнения (11), (12) имеют линеаризованную форму, поэтому для них можно использовать результаты из теории управления [11, 12], которые определяют условия управляемости и наблюдаемости линейной динамической системы.

Локальная управляемость

Повторное использование уравнения (11) дает соотношения

S x ( n + 1) = A S x ( n ) + b S u ( n );

S x ( n + 2) = A S x ( n + 1) + b S u ( n + 1);

S x ( n + q ) = A q • b S x ( n ) + A q • b S u ( n + q - 1)+ +^+ A ^ b S u ( n + 1) + b S u ( n ),

где q — размерность пространства состояний (вектора x ).

Таким образом, для ДС, описываемой линеаризованным уравнением (11), управляемость эквивалентна тому, чтобы матрица М упр . (называемая матрицей управляемости) имела полный ранг ( q ), т. е. чтобы ее определитель не был равен нулю:

М упр. = [ A q ' • b , ..., A • b , b ], Ве1( М упр. ) * 0.

Управляемость применительно к РНС

Рекуррентная нейронная сеть, описываемая уравнениями (8), (9), управляется последовательностью входных воздействий в виде вектора uq, который определен выражением uq(n) = [u(n), u(n + 1), ..., u(n + q - 1)]T. (17)

Следовательно, можно рассмотреть отображение

G( x ( n ), u q ( n )) = ( x ( n ), x ( n + q )), (18)

где G — нелинейное преобразование в пространстве размерности 2 q ( R 2 q —G ^ R 2 q ).

Из (18) следует, что

-

1) состояние x ( n + q ) является нелинейной функцией своего прошлого значения x ( n ) и входных сигналов u ( n ), u ( n + 1),- • -, u ( n + q - 1);

-

2) якобиан от x ( n + q ) по u q ( n ), оцененный в начале координат (0, 0), равен матрице управляемости М упр. из (16).

С другой стороны якобиан отображения G относительно x ( n ) и u q ( n ) можно выразить по правилу его определения:

Локальная наблюдаемость

Повторное совместное использование уравнений (11) и (12) позволяет получить соотношения:

S y ( n ) = c T^ S x ( n );

S y ( n + 1) = c T S x ( n + 1) =

= c T^ A S x ( n ) + c^b S u ( n );

S y ( n + q - 1) = c T^ A q 1 S x ( n ) +

+ c T^ A q • b S u ( n ) +

+...+ c T- A - b S u ( n + q - 3) + + c T^ b S u ( n + q - 2).

Так что линеаризованная система, описываемая уравнениями (11), (12), — наблюдаемая при условии, если матрица Мнабл. имеет ранг q, т. е. полный ранг:

М набл = [ c , CA T , ..., CT)q-1],

Det( M набл. ) * 0.

Теперь положим, что РНС описывается уравнениями (8) и (9) и получает воздействие uq-1(n) = [u(n), u(n + 1),..., u(n + q - 1)]T (23)

и что вектор-сигнал выхода, определяемого начальным состоянием x(n) и последовательностью управлений (воздействий на НС) uq-1(n), будет определяться выражением yq(n) = [y(n), y(n +1),^, y(n + q - 1)]T. (24)

Тогда можно рассмотреть отображение H

R 2 q - 1

H ^ r 2 q - 1

такое что упр. _

(0,0)

{ d x ( n ) /d x ( n ) } (0,0) { d x ( n + q ) /d x ( n ) } (0,0)

_ { d x ( n ) /d u q ( n ) } (0,0) { d x ( n + q ) /d u q ( n ) } (0,0)

IX

. 0 M упр.

где I — единичная матрица; 0 — нулевая матрица; X — некоторая матрица, которая не влияет на величину якобиана.

Определитель Det( J (0’0) ) = Det( I ) • Ве1( М упр . ) = = Det( M уп p. ), т. е. если М упр . имеет полный ранг, то и якобиан имеет полный ранг. В этом случае будет существовать обращение уравнения (18)

( x ( n ), x ( n + q )) = G-1( x ( n ), u q ( n )). (20)

Уравнение (20) устанавливает существование последовательности управлений { uq ( n )}, которые локально могут перевести состояние ДС x ( n ) в состояние x ( n + q ) за q временных шагов.

H( u q -1 ( n X x ( n )) = ( u q— 1 ( n X У q ( n )). (25)

Показано [13], что якобиан от yq(n) по x(n) равен матрице наблюдаемости Мнабл. из (22). Поэтому если выразить якобиан от H относительно uq-1(n) и x(n), то получится т набл_

J (0,0) =

{ d u q- 1 ( n ) /d u q- 1 ( n ) } (0,0)

{ d u q-1 ( nW(.n ) } (0,0)

IX

.0 М набл.

{ d y q ( n ) /d u q- 1 ( n ) } (0,0)

{ d y q ( n ) /d x ( n ) } (0,0)

И следовательно,

Det( J н 0 аб 0 л ' ) = Det( I ) • Det( M набл. ) = Det( M набл. ) * 0.

Таким образом, J Ho^' имеет полный ранг, и соотношение (25) обратимо:

( u q- 1 ( n ), x ( n )) = H-1( u q —1 ( n ), y q ( n )). (27)

Следовательно, x ( n ) выражается с помощью нелинейной функции H-1 через u q -1( n ) и y q ( n ), а обратная ей нелинейная функция H отражает наблюдение РНС в соответствии с (25).

Модель пространства состояний для РНС с одним входом и одним выходом, которая описывается уравнениями (8) и (9), можно преобразовать в эквивалентную ей форму модели типа вход— выход. Уравнения модели пространства состояний позволяют выразить y ( n + q ) через x ( n ) и u q ( n ):

y ( n + q ) = Ф( х ( n ), u q ( n )), (28)

где q — размерность пространства состояний РНС; Ф — отображение

R 2 q Ч^ R .

При условии, что модель РНС обладает свойством наблюдаемости, имеет место соотношение типа

x ( n ) = Т ( У q ( n ), u q -1 ( n )), (29)

где T — отображение

R 2 q ^ R 2 q .

Подстановка (29) в (28) дает выражение

y ( n + q ) = Ф( Т ( У q ( n ), u q -1 ( n )) = F( y q ( n ), u q ( n )). (30)

При этом u q -1 содержится в u q в качестве его первых ( q -1) элементов, и отображение F

R 2 q I > R объединяет отображения Ф и T.

Используя определения y q ( n) и u q ( n) по (23) и (24), уравнение (30) можно преобразовать к развернутой форме:

y ( n + q ) =

= F( y ( n ),..., y ( n + q -1), u ( n ),..., u ( n - q + 1)). (31)

Таким образом, показано существование отображения, которое связывает выход y ( n + 1) через свои предшествующие значения y ( n ),..., y ( n + q -1), и текущие, и прошлые значения входного сигнала u ( n ),..., u ( n - q + 1). Чтобы полученное представление вход—выход было эквивалентно модели пространства состояний по (8) и (9), РНС должна быть наблюдаема.

Практическая реализация описанной эквивалентности — это, в частности, то, что описанная выше модель НАР_ВЗ (МСП с двумя ЛЭВЗ на входе и с обратной связью с выходного нейрона (рис. 1)) фактически может имитировать соответствующую полностью рекуррентную модель пространства состояний, изображенную на рис. 2 (если принять m = 1 и p = 1). При этом поведение эк- вивалентных НС не будет отличаться с точки зрения преобразования вход—выход.

АЛГОРИТМЫ ОБУЧЕНИЯ

Как известно, применяются две формы обучения: обучение набором данных, в котором корректировка весов НС производится методом предъявления серии обучающих примеров (СОП), и режим последовательного обучения, при котором веса корректируются каждый раз после отдельного предъявления. Аналогичным образом обучаются РНС [14, 15]. Однако для РНС форма обучения СОП имеет смысл, близкий к последовательному обучению обычного МСП: настройка весов РНС производится после получения установившейся реакции выхода на поступающие на вход обучающие сигналы.

Непрерывное обучение применяется, когда нет возможности переустановить начальные состояния и требуется обучение в реальном времени. Отличительная черта непрерывного обучения — это то, что сеть обучается в то время, пока сигнал все еще обрабатывается сетью. Процесс обучения не прерывается, например, при использовании РНС для моделирования нестационарного сигнала. В этой ситуации непрерывное действие РНС не предоставляет удобного времени, чтобы остановить обучение и начать его заново с другими значениями начальных параметров сети.

Имея в виду эти две формы обучения, можно рассмотреть алгоритмы обучения, специфичные для РНС: алгоритм обратного распространения во времени (ОРВ), который предполагает возможность разворачивания темпоральной РНС в цепочку "статических" МСП. Такое разворачивание РНС дает возможность использовать обычный алгоритм обратного распространения (алгоритм ОРО [4]). Алгоритм ОРВ может выполняться способом СОП, последовательным способом для выполнения обучения в реальном времени или с помощью их комбинации. Алгоритм обучения реального времени выводится из модели пространства состояний.

Оба алгоритма обучения основаны на методе спуска по градиенту и используют текущую оценку функции стоимости (усредненного квадрата ошибок) для ее минимизации по набору синаптических весов НС. Оба алгоритма достаточно просты по логике исполнения, но могут медленно сходиться. Кроме того, они похожи в том, что представление сигнально-потоковым графом для алгоритма ОРВ может быть получено из перестановки представления сигнально-потокового графа для определенной формы рекуррентного алгоритма обучения реального времени [16].

Алгоритм обучения реального времени (непрерывного), основанный на градиентном спуске, использует минимальное количество информации — мгновенную оценку градиента функции стоимости (функции риска) по параметрам, которые подставляются в НС. При этом некоторое ускорение процесса обучения может быть достигнуто путем использования теории фильтра Калмана, которая позволяет более эффективно использовать обучающие данные.

Для улучшения процедуры обучения РНС Гайлсом (Giles [17]) предложено несколько эвристических правил, которые могут быть сведены к ряду практических рекомендаций.

-

• Обучающие примеры должны следовать лексикографическому порядку — наиболее короткие строки символов предъявляются сети в первую очередь.

-

• Обучение должно начинаться с малых обучающих образцов, а затем в ходе обучения их размер может наращиваться.

-

• Обновление величины синаптических весов НС должно происходить, только если ошибка отбрасываемого примера больше некоторого порога (выбираемого в контексте решаемой задачи).

-

• Во время обучения можно использовать некоторое экспоненциальное снижение величины весов ("распад" или релаксацию весов), что своеобразно служит грубым способом регуляризации, направленной на ограничение нормы весов НС.

Первое правило особенно полезно там, где оно применимо, оно смягчает проблему близкого к нулю значения градиента, которая возникает при использовании для обучения РНС метода градиентного спуска.

а

б

Время 0

x 1 ( n +1)

x 2( n +1)

x 2( n ) w 22

n n +1

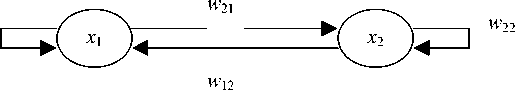

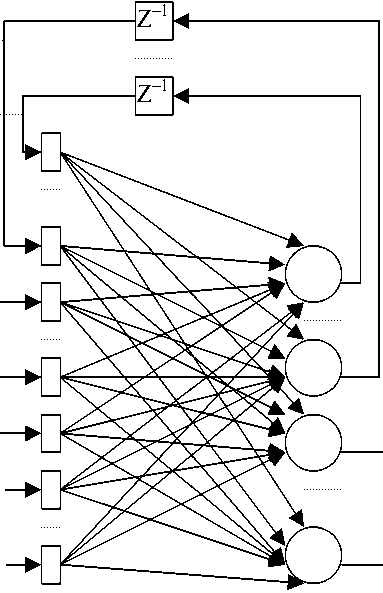

Рис. 4. Граф структуры РНС с двумя нейронами (а) и ее сигнальнопотоковый граф (б). РНС на (б) развернута во времени

Обучение по алгоритму обратного распространения во времени

Алгоритм обратного распространение во времени (ОРВ) — расширение алгоритма ОРО [4] — является основным принципом реализации способа обучения РНС. Алгоритм ОРВ строится путем так называемого разворачивания время-зависи-мого функционирования РНС в многослойную (однородную) нейронную сеть с распространением вперед, структура которой наращивается на 1 слой за каждый шаг по времени работы исходной РНС. Так, если N — РНС, которую требуется обучать темпоральной задаче, начинающейся со времени n 0 и длящейся до момента n , а N* — это нейронная сеть с распространением вперед, получающаяся при разворачивании время-зависимого (темпорального) действия РНС N, то N* соотносится с исходной РНС N, как показано на рис. 4.

-

• Для каждого временного шага интервала ( n 0, n ), сеть N* имеет слой с к нейронами, где к — число нейронов, содержащихся в РНС N.

-

• В каждом слое сети N* содержится копия каждого нейрона сети N.

-

• Для каждого временного шага l ( l е [ n 0, n ]) синаптическая связь нейрона i в слое l (в развернутой сети) к нейрону j в слое l + 1 в сети N* является копией связи нейрона i к нейрону j в сети N.

На рис. 4 отображена упрощенная модель РНС (без ЭВЗ) из двух нейронов с обратными связями (эта сеть N представлена графом ее структуры) и преобразованная форма РНС в виде эквивалентной сети прямого распространения (сеть N* показана сигнально-потоковым графом на рис. 4, б). Эквивалентная форма сети прямого распространения удобна для выполнения обычного алгоритма ОРО, который служит эмуляцией алгоритма ОРВ для исходной рекуррентной сети N.

Обучение по алгоритму ОРВ в формате использования СОП

В этой модификации алгоритма ОРВ множество данных разделяется на независимые серии, каждая из которых представляет один из анализируемых видов временного (темпорального) образца (ТО). Если начало серии (ТО) — n 0, а конец ее — n 1 , то общая функция риска (стоимости) определяется выражением:

1 n 1

Eобщ.( n 0, n1) = ~ У У j n)> (32) n = n о j е A где A — множество индексов j, принадлежащих тем нейронам сети, для которых известны желаемые отклики выхода; ej(n) — сигнал ошибки выхода нейрона j, измеренный относительно желаемого значения выхода.

Чувствительность сети определяется как частные производные функции риска Вобщ . относительно весов сети. Чтобы определить чувствительность, можно использовать развитый Вильямсом и Пенгом (Williams, Peng [18]) алгоритм ОРВ для ОСП, который строится на обычном алгоритме ОРО с ОСП (или с обучением эпохами [4, 13]). Алгоритм основывается на следующих процедурах.

-

• Выполняется проход в прямом направлении через сеть для интервала [ n 0 , n 1 ] . Запоминается полный список входных данных, состояния сети (ее синаптических весов) и желаемого отклика за этот временной интервал.

-

• Выполняется обратный проход, в ходе которого на основе зарезервированных данных осуществляется вычисление компонент локального градиента

j n ) = -{ д E общ. ( n о , n 1 )/ d V j ( n )} (33)

по формуле j n) = ф'(vj (n)) ej (n) для n = n 1;

ф '( V j ( n )) x

X e j ( n ) +

+ У w jk • 5 k ( n + 1) к е A

для n 0 < n < n 1 ,

где ф '(.) — производная функции активации по своему аргументу; n 0< n < n 1; V j ( n ) — индуцированный потенциал нейрона j , который с помощью функции ф преобразуется в его выходной сигнал; W jk — синаптический вес связи от к к j- му нейрону.

Использование (34) повторяется, начиная с n 1 , шаг за шагом в обратной последовательности по n ( n 1 , n 1 - 1,..., n 0 + 1). Число шагов равно длине временного интервала ( n 0 , n 1 ).

-

• После завершения ОРВ до момента n 0 + 1 применяется корректировка синаптичекого веса w j i нейрона j

A w ji =

dEобщ.(nо, n 1) η д wji n1

= П У {5 j(n) x(n -1)}, n = n о +1

где п — параметр скорости обучения; x i ( n - 1) — входной сигнал, приложенный к синапсу i нейрона j в момент времени n - 1.

Процедура ОРВ для ОСП существенно отличается от процедуры ОРО тем, что желаемые отклики специфицируются для нейронов во многих слоях НС, потому что выходные нейроны многократно дублируются, когда динамическое поведение РНС разворачивается в НС прямого распространения.

Сокращенный алгоритм ОРВ

Для того чтобы применять алгоритм ОРВ для процедуры реального времени, при минимизации функции риска приходится использовать текущую величину суммы квадратов ошибок

E ( n ) = 1 ∑ e 2 j ( n ) .

2 j ∈ A

Для последовательного способа обучения по алгоритму ОРО используется градиент E ( n ) для подстройки синаптических весов на каждом шаге времени n . Подстройка производится постоянно в процессе работы сети. Однако, чтобы сделать процесс возможно гибким, производится запоминание входных данных и состояния сети только на конечном интервале, называемом глубиной использования данных (ГИД). Практически это значит, что при обозначении ГИД через h информация старше h единиц времени не принимается во внимание. Если бы этого не делалось, то длительность вычисления (так же как и объем запоминаемой информации) линейно возрастал бы от времени, достигая таких значений, что продолжение обучения могло бы стать неэффективным. Эту вторую форму алгоритма называют усеченным ОРВ или алгоритмом УОРВ [18].

Изменение ОРВ при переходе к УОРВ достаточно очевидно. Локальное значение градиента определяется теперь на глубину h (по времени), поэтому у нейрона j для времени l значение этого градиента дает соотношение

δ j (l) = – ∂ E (l)/ ∂ v j (l), ∀ : j ∈ A , n – h < l ≤ n . (37)

Тогда общий вид выражений для локального градиента в алгоритме УОРВ дает выражение

δ j ( l ) = ϕ '( v j ( l )) e j ( l ) для l = n ,

δ j ( l ) = ϕ '( v j ( l ))×

× ∑ [ wkj δ k ( l + 1) ] для n – h < l < n . k ∈ A

После вычисления УОРВ в обратном направлении (до момента времени n – h + 1) производится подстройка синаптических весов w j i нейрона j по соотношению

∆ w ji ( n ) = η ⋅ ∑ ( δ j ( l ) ⋅ x i ( l - 1)), (39)

l = n - h + 1

где η и x i ( l – 1) определены ранее, а δ j ( l ) определяется по (38).

Использование w kj в (38) требует, чтобы сохранялись предшествующие значения весов. Задача несколько облегчается при очень маленьком значении параметра η , когда на каждом шаге веса меняются несущественно.

Сравнение (38) и (34) показывает, что в отличие от алгоритма ОРВ с ОСП в алгоритме ОРВ реального времени используется только текущий сигнал ошибки (в момент n ). Поэтому не приходится хранить предшествующие значения желаемого отклика. В результате алгоритм УОРВ проводит вычисления для всех предшествующих отсчетов времени практически аналогично способу, каким алгоритм ОРО осуществляет вычисления для скрытых нейронов МСП.

С точки зрения практических аспектов реализации алгоритма ОРВ усечение его — это не слишком искусственный способ. Если РНС устойчива, то должны сходиться производные ∂ E ( l )/ ∂ v j ( l ), т. к. вычисления назад по времени слишком далеко соответствуют более сильной обратной связи (которая, грубо говоря, равна крутизне сигмоида, умноженной на вес). В любом случае глубина усечения h должна быть достаточно велика, чтобы вычисленные производные хорошо аппроксимировали фактические их значения. Это требование создает нижнюю границу для величины h .

Процедура разворачивания для алгоритма ОРВ обеспечивает полезное средство для изображения РНС в виде последовательного (каскадного) соединения идентичных слоев с прямым (вперед) распространением сигнала. Это помогает понять, как реализуется процедура алгоритма ОРВ для РНС. Но это преимущество имеет обратную сторону. Процедура хорошо работает для сравнительно простых РНС, состоящих из небольшого количества нейронов. В то же время выражения, связанные с алгоритмом ОРВ, в частности (38), становятся громоздкими, когда процедура ОРВ применяется к общим видам структур, которые встречаются в практике. Для этих ситуаций Вер-босом (Werbos [19]) рекомендован более общий подход, согласно которому каждое выражение для слоя прямого распространения порождает соответствующий набор выражений обратного распространения. Преимущество этого подхода состоит в его однородной трактовке прямых и рекуррентных (обратных) связей. Однако следует отметить, что изложение этого метода в [19] не ориентировано на непосредственное использование и пока не нашло прикладной адаптации.

Вектор параметров состояния x ( n )

Смещение и 1( n)

Входной вектор u ( n )

и 2( n )

Рис. 5. Сигнально-потоковый граф полносвязной РНС с четырьмя нейронами ( q = 4), двумя входами ( m = 2) и двумя выходами (р = 2)

>У 1 ( n )

Выходной вектор y ( n + 1)

>У 2 ( n )

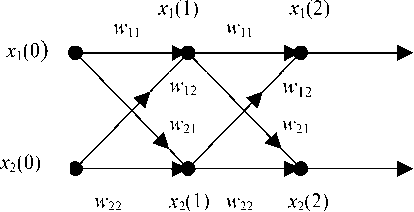

Рекуррентный алгоритм обучения НС в реальном времени

Название алгоритма рекуррентного обучения реального времени (РОРВ) отражает его назначение для полносвязной РНС и для реализации подстройки весов в реальном времени, т. е. в процессе выполнения сетью обработки сигналов [14]. Полносвязная РНС простой структуры может состоять из q нейронов и иметь m внешних входов (внешний сигнал с m компонентами). Сеть имеет две функционально различные (но объединенные кон катенацией в один слой6)) группы нейронов. На входные узлы одной группы поступают сигналы обратной связи с выхода всех нейронов слоя (т. е. вектор x(n) параметров состояния), а на входные узлы другой группы нейронов поступает m-вектор входного воздействия u(n).

Принципы построения алгоритма РОРВ удобно проанализировать на несложной структуре полносвязной рекуррентной НС (рис. 5), которая имеет в своем составе q = 4 нейрона, вектор из параметров состояния x(n) размерности 4 и m = 2.

Описание модели пространства состояний, определяемое уравнением (8), в развернутом виде выражается соотношением

x ( n + 1) =

= [ ф ( w T • 5 ( n )Х-, ф ( w T • 5 ( n )х

- , ф ( w T • 4 < n X)?, (40)

При этих обозначениях можно произвести дифференцирование уравнения (40) по w j , и применение правила вычисления производной сложной функции позволяет получить рекурсивное уравнение

Л (n + 1) = Ф ( n )-[ W a ( n ) Л ( n ) + U j ( n )], j = 1, 2,., q .

где ф — активационная функция нейронов; w j — ( q + m + 1)-вектор синаптических весов нейрона j в РНС и ^ ( n ) — ( q + m + 1)-вектор, описанный ниже.

Векторы wi, .., wq определяются соотношением wj = [wajj wbj]T, j = 1, ., q, (41)

в котором w a ,j и w b , — это j -е столбцы транспонированных полных матриц весов W aT и W J .

( q + m + 1)-вектор £ ( n ) определяется выражением

£ ( n ) = [ x ( n ) u ( n )]T, (42)

где x ( n ) — q -мерный вектор параметров состояния; u ( n ) — ( m + 1)-мерный входной вектор ( m компонент внешнего воздействия и 1 компонента постоянного смещения на нейрон, причем первая компонента u ( n ) равна 1 и соответственно первый элемент в w b j - равен смещению b , приложенному к нейрону j ).

Для некоторого упрощения удобно ввести матрицы Л j ( n ), U j ( n ) и Ф ( n ), определяя их следующим образом.

-

• Л j ( n ) — ( q х q + m + 1)-матрица, элементы которой суть частные производные от x ( n ) по вектору веса w j :

Л j ( n ) = d x ( n )/ d w j , j = 1, 2,., q . (43)

-

• U j ( n ) — это ( q х q + m + 1)-матрица, у которой все строки нулевые, кроме строки j , которая равна транспонированному вектору £ ( n ):

Это рекурсивное уравнение описывает нелинейную динамику состояния (т. е. эволюцию состояния) процесса обучения в реальном времени. Оно дает математическую форму реализации алгоритма РОРВ.

Теперь для завершения алгоритма необходимо соотнести матрицу Л j ( n ) с градиентом поверхности ошибки (градиентом функции риска) относительно w j . Для этого вначале с помощью уравнения измерения (9) определяется p -вектор сигнала ошибки

U j ( n ) =

§ T( n )

^ строка j ,

j = 1,2,..., q .

• Ф ( n ) — это диагональная ( q х q )-матрица, у которой к -й диагональный элемент является частной производной активационной функции по своему аргументу, оцененной в точке w T • ^ ( n ):

Ф ( n ) = dlag { ф '( w T • £ ( n )Х-.., ф l( w T • £ ( n )),

- , ф '(w T • Х ( n )) } - (45)

e ( n ) = d ( n ) - y ( n ) = d ( n ) - C - x ( n ).

Сумма квадратов ошибки (или, точнее, квадрат нормы вектора-сигнала ошибки)

E ( n ) = E n = (1/2) e ( n )^ e ( n )

определяет функцию риска (ФР) — суммарную величину текущего значения ошибки

ФР = E общ. = X E n = (1/2) E ( e ( n )T • e ( n ) ) . (47) ( n ) ( n )

В свою очередь критерий минимизации ФР служит для настройки весов РНС. Алгоритм крутого спуска осуществляет движение к минимуму по поверхности ошибок в направлении, противоположном градиенту ФР ( Е общ . ).

Таким образом, для выполнения алгоритма РОРВ необходимо получение выражения для градиента (символ V ) от Е общ. :

V w ( Е общ. ) = д Е общ. / d w =

= ^ { д E n /d w } = ^ V w ( E n ), (48)

( n ) ( n )

где V w( Е п ) — градиент от E ( n ) относительно матрицы весов W = { w k } (т. е. относительно каждого элемента этой матрицы).

Непосредственное вычисление градиента предоставляет способ получения уравнения обновления весов РНС, не делая аппроксимаций. Однако, чтобы получить алгоритм обучения РНС в реальном времени, необходимо использовать текущую оценку градиента, а именно оценку мгновенного значения V w ( Е „ ), которая могла бы служить аппроксимацией для метода крутого спуска.

Для этой цели требуется использовать квадратичную ошибку Е „ в текущем времени n и, мини-

мизируя ее, двигаться против градиента этой функции ошибок:

∂ Е n / ∂ w j = { ∂ e ( n ) / ∂ w j } e ( n ) =

= – C ∙{ ∂ x ( n ) / ∂ w j } e ( n ) =

= – C ∙ Λ j ( n )∙ e ( n ), j = 1,…, q . (49)

Подстройка вектора синаптических весов w j нейрона j осуществляется по соотношению

∆ w j ( n ) = – η ∙ ∂ Е n / ∂ w =

= η ∙ C ∙ Λ j ( n )∙ e ( n ), j = 1,…, q (50)

где η — параметр скорости обучения; Λ j ( n ) — определяется выражением (43).

В начале алгоритма обучения проводится инициализация матрицы Λ j (0) в виде Λ j (0) = 0 для всех j , т. е. предполагается, что в начальный момент РНС пребывает в некотором постоянном состоянии.

В Приложении дана сводка соотношений, определяющих алгоритм РОРВ. Представленный там алгоритм применим к РНС с произвольной (дифференцируемой) функцией активации нейронов ϕ (.). Для случая сигмоидальной нелинейности нейронов в виде функции гиперболического тангенса следует использовать выражение (51), которое показывает связь выхода нейрона j с потенциалом его возбуждения ( v j ):

x j ( n + 1) = ϕ ( v j ( n )) = tanh( v j ( n )),

ϕ '( v j ( n )) = ∂ ϕ ( v j ( n )) / ∂ v j ( n ) = sech2( v j ( n )) =

= 1 – [ x j ( n + 1)]2. (51)

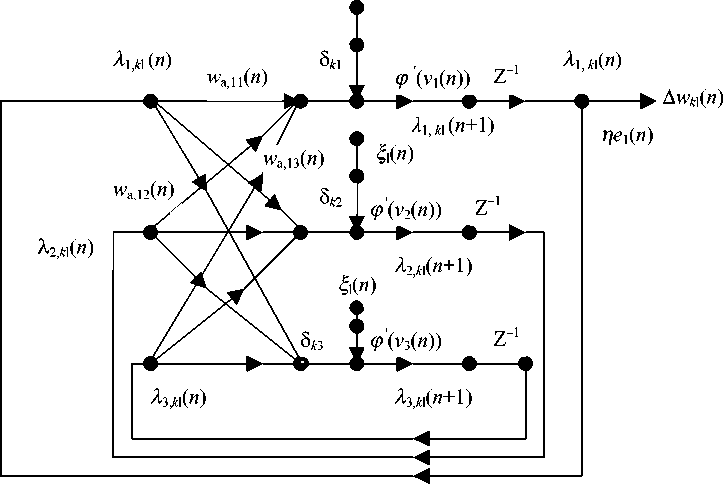

В этом же Приложении для полносвязной РНС (рис. 1П ) дан пример применения алгоритма РОРВ. Показаны порядок и обозначения параметров модели пространства состояний (матриц W a , W b и вектора C) ; построение вектора ξ ( n ) и матрицы Λ j . Приведены выражения для подстановки параметров анализируемой РНС и граф чувствительности рассматриваемой полносвязной РНС.

Использование в алгоритме РОРВ текущего ("мгновенного") градиента ∇w(Е(n)) означает, что этот описанный здесь алгоритм отличается от алгоритма ОРВ (не выполняющегося в реальном времени), основанного на ∇w(Еобщ.). Однако это отличие аналогично отличию стандартного алгоритма обратного распространения (алгоритма ОРО [4]) при двух вариантах обучения: с настройкой параметров сети после каждого предъявления примера (sample-метод) и с настройкой после предъявления серии образцов (batch-метод). Хотя алгоритм РОРВ не гарантирует движения по поверхности ошибок (Еобщ.(W) ) в направлении, противоположном градиенту, различие между РВ и не-РВ вариантами алгоритма часто очень незначительны, и методы становятся почти идентичными, когда параметр скорости обучения выбирается очень малым. Самым неприятным потенциальным последствием этого отклонения от модификации, построенной на истинном градиенте (∇w(Еобщ.)), является то, что наблюдаемая траектория (полученная как зависимость точек эволюции весов при градиентном спуске по поверхности Е(n)) может стать зависимой от темпа изменения веса, производимого алгоритмом РОРВ. Последняя ситуация может трактоваться как дополнительный источник обратной связи, вносящий элемент неустойчивости в систему. Этого эффекта можно избежать, используя достаточно малое значение η, — малое настолько, чтобы масштаб изменения веса был намного меньше масштаба весов функционирующей сети.

Одной из стратегий, часто используемых при обучении РНС, является усиливающее влияние учителя (УВУ) [14, 15]. В области адаптивной фильтрации эта стратегия известна как метод выровненной ошибки [20]. В основном УВУ состоит в замене действительного выхода нейрона (во время обучения сети) на соответствующий желаемый отклик. Эта замена действует в последующих за ней вычислениях динамического поведения сети. Стратегия УВУ, кроме алгоритма РОРВ, используется и в некоторых других алгоритмах обучения, но для ее применения необходимо, чтобы нейрон, подвергнутый УВУ, блокировал свой выход в обратную связь сети. По данным Вильямса и Зипсера (Williams, Zipser [15]) использование при обучении стратегии УВУ имеет определенные преимущества.

-

• УВУ может приводить к более быстрому обучению. Причина состоит в предположении, что сеть правильно обучена на всей предшествующей части задачи, относящейся к нейрону, для которого реализовано УВУ.

-

• УВУ может служить как некоторый корректирующий механизм во время процесса обучения. Например, синаптические веса НС могут иметь корректные значения, но тем не менее сеть функционирует где-то в неверной области пространства состояний. В этом случае простая подстройка параметров (без УВУ) является неправильной стратегией.

-

• Алгоритм обучения, основанный на градиенте функции риска (ФР) и использующий УВУ, оптимизирует ФР иначе, чем аналогичный алгоритм без применения УВУ. Поэтому обе версии алгоритма могут давать несколько отличающиеся по комплекту весов НС при условии, что соответствующий сигнал ошибки не равен нулю. Но в последнем случае и в самом обучении нет необходимости.

Описанный алгоритм РОРВ работает недостаточно быстро, что связано главным образом с необходимостью многократно вычислять текущее (на каждом временнóм шаге) значение градиента. Совершенствование алгоритма основано на трактовке супервизорного (с учителем) обучения РНС как оптимальной фильтрации. Применение такого подхода позволяет рекуррентно использовать информацию, содержащуюся в обучающих данных, путем своеобразного возвращения к первой итерации процесса обучения. Основой усовершенствованного алгоритма РОРВ для рекуррентной нейронной сети служат элементы теории фильтров Калмана 7).

Исчезающий градиент у РНС

В практическом приложении РНС при обучении с использованием алгоритма, основанного на градиентном спуске, встречается ситуация исчезающего градиента [21, 22]. Ситуация связана со стремлением получить желаемый отклик НС в текущий момент времени и с тем, что этот отклик зависит не только от текущего входного сигнала, но и от его прошлых значений. Суть в том, что за счет комбинации нелинейных нейронов предельно малое изменение отдаленного по времени входного сигнала почти не изменяет обучение сети. Проблема может возникнуть даже в том случае, если большое изменение в отдаленных по времени входных данных влияет на переменные параметры состояния РНС, но это изменение почти не отражается на величине градиента. Это явление, называемое проблемой исчезающего градиента , при применении алгоритма, основанного на градиентном спуске, делает трудным обучение РНС при редко проявляющихся изменениях входных данных. В связи с этим Бенгио (Bangio [22]) для многих прикладных задач полагает необходимым сохранять информацию о состоянии РНС в течение возможно длительного времени, особенно при анализе зашумленной информации.

ИСПОЛЬЗОВАНИЕ РНС В ПРИКЛАДНЫХ ЗАДАЧАХ

Экспериментальный подход к моделированию ДС с неизвестными параметрами используется в задаче идентификации [11, 23, 25]. Процедура идентификации включает этапы планирования и отбора структуры модели, оценку параметров, проверку моделей и имеет интерактивную форму вычисления, в которой можно возвращаться или двигаться вперед (относительно описанных эта- пов) до построения удовлетворительной модели. При анализе ДС для построения удобно параметризованной модели и ее идентификации можно использовать процедуры, основанные на модели пространства состояний или на модели вход—выход. Выбор этих двух схем идентификации зависит от информации о входных и наблюдаемых переменных ДС.

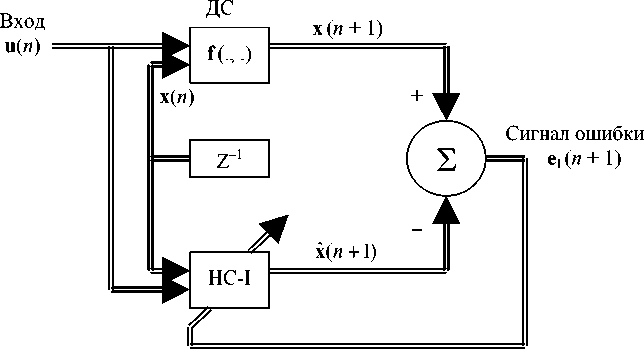

Система идентификации на основе пространства состояний

Система идентификации использует модель ДС в виде

x ( n + 1) = f ( x ( n ), u ( n )), (52)

y ( n ) = h ( x ( n )), (53)

где f (.,.) и y (.) — нелинейные вектор-функции, вид каждой из которых неизвестен. (53) является обобщением (9).

Для идентификации ДС могут быть использованы две НС: первая НС-I отражает уравнение процесса (52), вторая НС-II — уравнение измерения (53). Учитывая, что x ( n ) является задержанной на единицу времени переменной x ( n + 1) и что x ˆ( n + 1) обозначает оценку для x ( n + 1), структуру первой НС можно представить рис. 6, а. Эта НС включает конкатенацию двух групп входных узлов, на одну из которых поступает вектор-сигнал внешнего воздействия u ( n ), а на другую — вектор параметров состояния x ( n ) . Совместное действие u ( n ) и x ( n ) определяет на выходе сети оценку x ˆ( n + 1) . Вектор сигнала ошибки:

e I ( n + 1) = x ( n + 1) – x ˆ( n + 1) . (54)

В (54) x ( n + 1) играет роль желаемого отклика, и предполагается, что локальное состояние доступно для получения величины ошибки. Ошибка e I( n + 1) служит для подстройки синаптических весов РНС на основе минимизации функции риска.

Вторая НС (НС-II, рис. 6, б ) имитирует систему измерения и работает с реальным состоянием x ( n ) (в целом неизвестной) ДС, получая оценку y ˆ( n ) выхода НС. Вектор-сигнал ошибки e II ( n ) = = y ( n ) – y ˆ( n ) , в котором y ( n ) играет роль желаемого выхода, служит для образования ФР и подстройки синаптических весов РНС на основе минимизации этой ФР.

Обе НС (рис. 6) работают синхронно и дают решение модели пространства состояний, необходимое для обеспечения идентификации ДС. Такой способ идентификации называют последовательно-параллельной моделью идентификации в распознавании для обозначения того факта, что реальное состояние неизвестной ДС подается на модель идентификации так, как это показано на рис. 6, а. Используемая здесь форма обучения относится к УВУ.

Последовательно-параллельную модель следует отличать от параллельной модели идентификации, в которой x(n), поступающее на НС-I, заменяется на x(n) (получается из x(n +1) после ЭВЗ Z -1).

а

Неизвестная

Состояние

б

Неизвестная

ДС

x ( n )

Рис. 6. Решение задачи идентификации на основе двух РНС. а — РНС-I, отражающая процесс ДС (объекта, подсистемы); б — РНС-II для измерительной системы

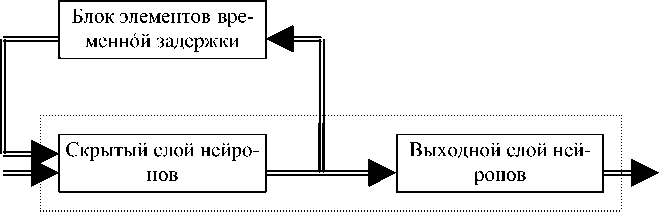

Входной

Рис. 7. РНС при решении задачи идентификации в форме модели нелинейной авторегрессии с временнóй задержкой внешнего входа (НАР_ВЗ)

Практическое преимущество этой альтернативной модели обучения состоит в том, что модель НС функционирует точно таким образом, как неизвестная ДС, т. е. таким образом, каким модель будет использоваться после окончания обучения. Поэтому вполне вероятно, что модель, полученная за счет параллельного способа обучения, может показывать автономное поведение, которое пре- восходит поведение модели, полученной за счет последовательно-параллельного типа обучения. Но параллельный способ обучения дольше, чем последовательно-параллельный. В частности, в рассматриваемой ситуации оценка xˆ(n) , используемая в параллельном способе, обычно не так точна, как фактическое состояние x(n), введенное в структуру последовательно-параллельного способа обучения

Модель вход—выход

Эта модель в идентификации используется, когда имеется доступ только к выходному вектору ДС. Для упрощения анализа достаточно рассмотреть ДС с одним входом и одним выходом (т. е. скалярные u(n) и y(n)) и структуру модели НАР_ВЗ, при которой соотношения вход—выход имеют вид я n + 1) =

= Ф ( y ( n ),-••, y ( n — q + 1), u ( n ),-••, u ( n - q + 1)), (55) где q — порядок ДС.

Таким образом, оценка y(n + 1) реального выходного сигнала РНС y ( n + 1) используется для получения сигнала ошибки

e ( n + 1) = y ( n + 1) - y ( n + 1), где y ( n + 1) играет роль желаемого отклика сети. Как обычно, подстройка весов РНС осуществляется, исходя из минимизации ФР, в качестве которой принимается квадрат сигнала ошибки.

Модель идентификации (рис. 7) относится к последовательно-параллельной форме с УВУ, т. к. реальный выход ДС y ( n + 1) (а не модели идентификации) подается через обратную связь на вход.

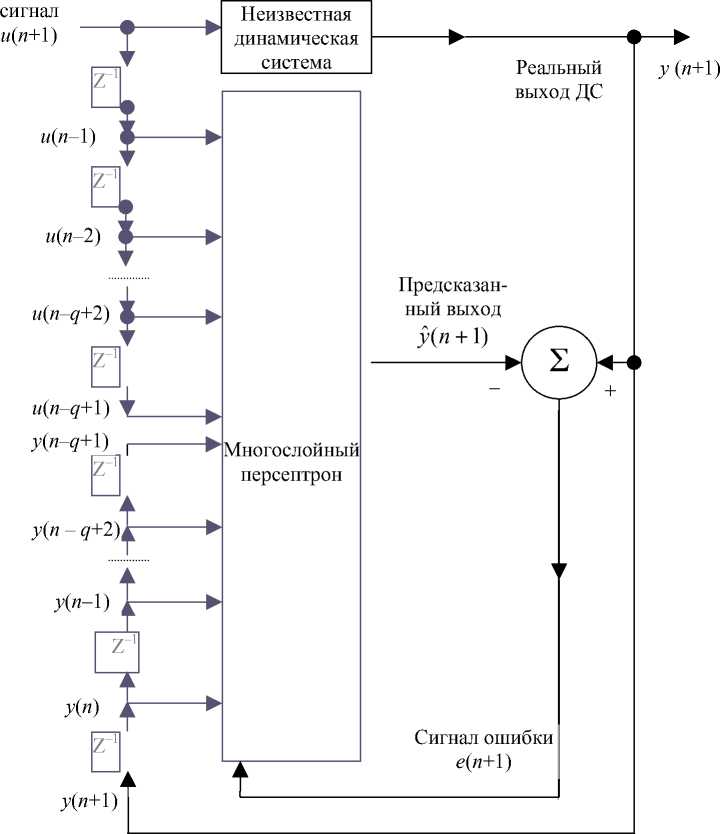

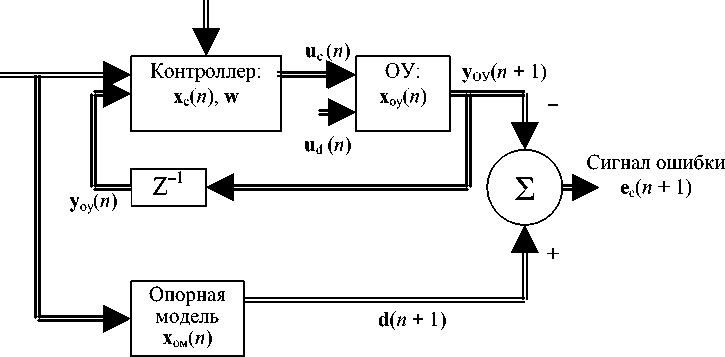

Система адаптивного управления с опорной моделью (САУ_ОМ)

Другой областью применения РНС является адаптивное управление [8, 24, 25]. В структуру управления входит базовая опорная модель (имитатор желаемого и оптимального поведения ДС), РНС — как управляющее устройство (контроллер) и объект управления (ОУ), в качестве которого может быть некоторый производственнотехнологический комплекс (рис. 8, а).

Стратегия адаптивного управления, ориентированная на опорную модель, предполагает, что при создании системы управления на РНС имеется достаточно информации относительно анализируемой ДС. От контроллера и через объект управления (ОУ) подается обратная связь на вход системы, образуя сеть с внешней рекуррентностью. ОУ получает входной сигнал u с ( n ) от контроллера и внешнее управляющее воздействие u d . Эволюция ОУ во времени является функцией приложенных воздействий и своего собственного состояния x ОУ ( n ). Выход ОУ y ОУ ( n + 1) определятся вектором параметров его состояния x ОУ , а также возможными шумами. Контроллер получает на входе внешне определенный опорный сигнал r ( n ) и выход y ОУ ( n + 1), преобразованный за счет ЭВЗ в y ОУ ( n ).

Контроллер производит сигнал управления uс(n) = f1(xc(n), yОУ(n), r(n), w), (56) где xc — соответственное состояние контроллера; w — вектор параметров НС, доступный для подстройки; вектор-функция f1(. , . , . , . ) определяет соотношение вход—выход контроллера.

Желаемый отклик d ( n + 1) объекта управления обеспечивается выходом опорной модели (ОМ), которая дает этот отклик в качестве реакции на сигнал r ( n ). Поэтому d ( n + 1) является функцией сигнала r ( n ) и собственного состояния x ом ( n ) опорной модели

d ( n + 1) = f ом ( x ом ( n ), r ( n )). (57)

Вектор-функция f ом определяет соотношение вход— выход опорной модели. Ориентиром для подстройки параметров сети служит движение в направлении антиградиента поля ФР, которое определяется квадратом нормы вектора e c ( n + 1) = = d ( n + 1) – y ОУ ( n + 1). И цель подстройки весов сети w определяется минимизацией функции риска.

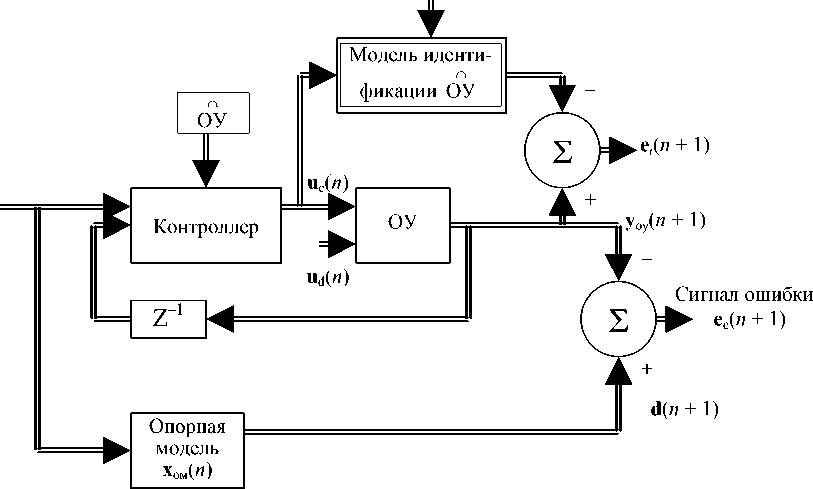

Метод управления в САУ_ОМ (рис. 8, а) можно назвать прямым, т. к. он не требует идентификации параметров объекта управления и параметры контроллера непосредственно подстраиваются, чтобы улучшить функционирование ОУ. Однако пока для подстройки параметров контроллера (на основе сигнала ошибки) нет достаточно точных и достоверных методов. Поэтому неизвестный объект управления структурно включается между контроллером и ошибкой выхода. В связи с эти предложена более гибкая структура САУ_ОМ, реализующая непрямое управление (НПУ) (рис. 8, б). В этой структуре используется двухступенчатая процедура:

-

1. Модель объекта управления ОУ (обозначаемая

-

2. Модель идентификации ОУ используется (после обучения) вместо ОУ для вывода оценок динамических производных ОУ по компонентам вектора параметров контроллера, которые доступны для подстройки.

ОУ) служит для обеспечения оценок, необходимых для получения разностных соотношений выхода ОУ со значениями входа ОУ, которые предшествуют выходу ОУ и его внутренним состояниям. Описанная процедура использована для обу чения НС идентификации ОУ, и модель ОУ считается моделью идентификации.

п

Таким образом, в непрямом управлении, нейронная сеть с внешней рекуррентностью составлена из контроллера и представления ОУ в форме вход—выход, которое эмулируется моделью иден тификации ОУ .

а

e c ( n )

r ( n )

б

e i ( n )

r ( n )

Рис. 8. Структуры РНС для системы адаптивного управления с опорной моделью (САУ_ОМ): а — схема прямого управления; б — схема непрямого управления

Приложение РНС для создания контроллеров с общей структурой, показанной на рис. 8, б, занимает значительное место в сфере систем адаптивного управления (от двигателей и биореакторов до автоматических подсистем) [8, 24]. Часто эти контроллеры включают рекуррентные МСП, а для обучения начинают использовать довольно трудоемкие алгоритмы на основе фильтров Кал-мана.

ЗАКЛЮЧЕНИЕ

В целях применения в ИИС для анализа данных при неполной измерительной информации рассмотрены разновидности структуры, элементы теории и алгоритмы обучения рекуррентных нейронных сетей (РНС), а также их приложения — идентификация динамического объекта (подсистемы) и адаптивное управление по "эталонной" модели. Проанализированы модель пространства состояний динамического объекта, понятия и условия управляемости и наблюдаемости. В терминах пространства состояний представлена модель нелинейной авторегрессии, построенной на РНС с внешним входом на линии элементов временной задержки.

Проанализированы два способа обучения РНС: на основе алгоритма обратного распространения во времени (алгоритм ОРВ) и на основе рекуррентного алгоритма обучения реального времени (РАО_РВ). Намечен путь усовершенствования РАО_РВ на основе фильтров Калмана. Приведены некоторые рекомендации (эвристического типа), позволяющие противодействовать ухудшению характеристик обучения РНС при значениях градиента, близких к нулю.

Таким образом, в предшествующей [5] и в этой частях статьи проанализированы структуры темпоральных (с прямым распространением сигнала) и рекуррентных (с обратными связями) нейронных сетей, реагирующих на изменение входной информации изменением реализуемого сетью отображения. Эти виды нейронных сетей используются в методе интерпретации данных, получаемых и обрабатываемых ИИС в условиях, когда не весь набор параметров состояния контролируемого динамического объекта (подсистемы) воздействует на датчики измерительной системы. Метод трактовки измерительных данных при неполной информации 8) основан на рекуррентном представлении уравнений динамики контролируемого объекта и уравнения наблюдения (определяющего преобразование информации в системе измерения)

и на использовании темпоральной или рекуррентной нейронной сети.

ПРИЛОЖЕНИЕ. Сводка соотношений, определяющих алгоритм рекуррентного обучения в реальном времени (алгоритм РОРВ). Пример

Параметры m — размерность входного сигнала; q — размерность пространства состояний; p — размерность выходного сигнала; wj — вектор синаптических весов нейрона, j =1, 2, „., q.

Инициализация

-

1. Множеству синаптических весов (компонентам векторов w j , j = 1, 2, „., q ) присваиваются малые значения, выбираемые из равномерного распределения.

-

2. Начальная величина всех компонент вектора состояния полагается равной нулю, x (0) = 0 .

-

3. Начальная величина всех векторов Л также полагается равной нулю, Л j (0) = 0 для j = 1, 2,., q .

Процедура вычислений

Для n = 0, 1, 2, .. вычисляются значения векторов (в указанной ниже последовательности):

ЛД n + 1) = Ф ( n ){ W a ( n ) ЛД n ) + Щ n )},

e ( n ) = d ( n ) - C - x ( n ),

A w j ( n ) = П" C Л j ( n ) e ( n ).

Определения для x ( n + 1), Л j ( n ), U j ( n ) и Ф ( n ) приведены в основном тексте статьи выражениями (40), (43), (44) и (45).

Формирование алгоритма РОРВ

Формирование алгоритма выполнено для полносвязной рекуррентной сети (рис. 1П), которая включает 3 нейрона, два входных узла и один выход. Сеть имеет двухкомпонентный вход (входной вектор u ( n ), m = 2), характеризуется 3-компонентным вектором x параметров состояния нейронного слоя ( q = 3) и имеет скалярный выход ( p = = 1). Матрицы W a, W b имеют вид:

|

w 11 |

w 12 |

w 13 |

■ b 1 |

w 14 |

w 15 |

||

|

W a = |

w 21 |

w 22 |

w 23 |

, W b = |

b 2 |

w 24 |

w 25 |

|

_ w 31 |

w 32 |

w 33 _ |

b 3 |

w 34 |

w 35 _ |

Первый столбец матрицы W b представляет смещения ( b 1 , b 2, b 3), приложенные к нейронам 1, 2 и 3. Матрица C в данном случае является вектором (поскольку мы рассматриваем скалярный выход сети) C = [1, 0, 0].

Рис. 1П. Полносвязная РНС двумя входами, двумя скрытыми нейронами и одним выходным нейроном

Имея в виду, что m = 2, q = 3, можно с помощью выражения (42) (основного текста статьи) определить £ ( n ) и kl -элементы ( j ) матрицы Л j ( n ):

^ ( n ) = [ X 1 ( n ) x 2( n ) x 3( n ) 1 U 1 ( n ) u 2( n )]T,

X j,kl ( n + 1) =

= ф( V j ( n ))•

У w j ( n ) ^ j , kl ( n ) + 8 kj ^ i ( n ) }

(/) _ где 8kj — символ Кронекера (k, j = 1, 2, 3); индекс l = 1, 2,..., 6.

Подстройка параметров сети по алгоритму рекуррентного обучения реального времени (РОРВ) осуществляется на основе выражения

A W k i ( n ) = п ( d 1 ( n )) - x 1 ( n ) X 1, k i ( n ).

Отметим, что индексы в этом выражении принимают свои значения в соответствии с определением матриц: W a= { w j -}, (j' , / ) = 1, 2, 3 и W b = { W ji }, j = 1, 2, 3, l = 4, 5, 6.

ξ l ( n )

Рис. 2П. Граф чувствительности полносвязной РНС, показанной на рис. 1П

Эволюция величины подстройки весов ∆ w kl ( n ) рассматриваемой нейронной сети может быть представлена графом чувствительности, который показан на рис. 2П.

Список литературы Метод контроля состояния подсистемы (объекта) при неполной измерительной информации о совокупности параметров, определяющих ее динамику. II. Нейронные сети, отражающие динамику входной информации и построенные на принципе обратных связей (рекуррентные сети)

- Gaunaurd G.C., Strifors H.C. Signal analysis by mean of time-frequency transformation of Wigner type//Proceedings of IEEE. 1996. V. 84, N 9. P. 1231-1247.

- Исмаилов Ш.Ю., Меркушева А.В. Нейросетевой алгоритм на вейвлет-преобразовании нестационарного сигнала в ИИС//Труды Международной научной конференции по мягким вычислениям и измерениям SCM'2001. СПб.: Изд. ГЭТУ (ЛЭТИ), 2001. Т. 1. С. 251-256.

- Малыхина Г.Ф., Меркушева А.В. Вейвлет-фильтрация нестационарного сигнала с адаптацией на основе нейронной сети//Труды Международной научной конференции по мягким вычислениям и измерениям SCM'2001. СПб.: Изд. ГЭТУ (ЛЭТИ), 2001. Т. 1. С. 239-242.

- Меркушева А.В. Применение нейронной сети для текущего анализа нестационарного сигнала (речи), представленного его вейвлет-отображением. I. Основные принципы//Научное приборостроение. 2003. т. 13, № 1. с. 64-70.

- Малыхина Г.Ф., Меркушева А.В. Метод контроля состояния подсистемы (объекта) при неполной измерительной информации о совокупности параметров, определяющих ее динамику. I. Анализ структуры нейронной сети, приспособленной к динамическому характеру анализируемой информации//Научное приборостроение. 2004. т. 14, № 1. с. 57-67.

- Tsoi A.C., Back A.D. Locally recurrent globally feet-forward networks: A critical review//IEEE Transactions on Neural Networks. 1994. v. 5. p. 222-239.

- Elman J.L. Finding structure in time//Cognitive Science. 1990. v. 14. p. 179-211.

- Puskorius G.V., Feldkamp L.A. Dynamic neural networks methods applied to on-vehicle idle speed control//Proceedings of IEEE. 1996. v. 84. p. 1407-1420.

- Giles C.L., Sun G.Z., Lee Y.C., Chen D. Higher order recurrent networks and grammatical interference//Advances in Neural Information Processing Systems. San Mateo, CA: Morgan Kaufmann, 1990. v. 2. p. 382-387.

- Sontag E.D. Mathematical control theory: Dynamic finite-dimension systems. N.Y.: Springer Verlag, 1990. 360 p.

- Сейдж Э.П., Уайт Ч.С. Оптимальное управление системами. М.: Радио и связь, 1982. 391 с.

- Levin A.V., Narendra K.S. Control of nonlinear dynamic systems using neural networks: Reliability, identification and control//IEEE Transactions on Neural Networks. 1996. v. 7. p. 30-42.

- Haykin S. Neural networks. N.Y.: Prentice-Hall, 1999. 842 p.

- Williams R.J., Zipser D. Learning algorithms for continually running fully recurrent neural networks//Neural Computation. 1989. v. 1. p. 271-280.

- Williams R.J., Zipser D. Gradient-based learning algorithms for recurrent networks and their computational complexity//Back-propagation: Theory, Architecture and Applications/Eds. Chauvin Y., Rumelhart D.E. Hillsdale, N.Y.: Lawrence Erlbaum, 1995. p. 433-484.

- Beaufays F., Wan E.A. Relating real-time back-propagation through time: Application to flow-graph inter-reciprocity//Neural Computation. 1994. v. 6. p. 396-406.

- Giles C.L. et al. Constructive learning of recurrent neural networks: Limitation of recurrent cascade correlation with simple solution//IEEE Transactions on Neural Networks. 1995. v. 6. p. 829-836.

- Williams R.J., Pang J. An efficient gradient-based algorithm for on-line training the recurrent -network trajectories//Neural Computation. 1990. v. 2. p. 4090-5100.

- Werbos P.J. Back-propagation through time: What it does and how do it//Proceedings of IEEE. 1990. v. 78. p. 1550-1560.

- Mendel J.M. Lessons in estimation theory for signal processing. Communication and control. Englewood Cliffs, N.Y.: Prentice-Hall, 1995. 360 p.

- Hochreiter S., Schmithuber J. LSTM can solve hard long time lag problems//Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 1997. v. 9. p. 473-479.

- Bengio Y., Simard P., Frasconi P. Learning long time dependences with gradient descent is difficult//IEEE Transactions on Neural Networks. 1994. v. 5. p. 157-166.

- Цыпкин Я.З. Информационная теория идентификации. М.: Наука, Физматлит, 1995. 336 с.

- Puskorius G.V., Feldkamp L.A. Neuro control of nonlinear dynamic systems on the basis of recurrent neural networks//IEEE Transactions on Neural Networks. 1994. v. 5. p. 279-297.

- Уидроу Б., Стирнз С. Адаптивная обработка сигналов. М.: Радио и связь, 1989. 439 с.