Оптимизация стохастического градиентного бустинга с помощью out-of-sample оценок качества

Автор: Ибрагимов Б.Л., Гусев Г.Г.

Журнал: Труды Московского физико-технического института @trudy-mipt

Рубрика: Математика

Статья в выпуске: 3 (63) т.16, 2024 года.

Бесплатный доступ

Стохастический градиентный бустинг (SGB) - это мощный метод ансамблевого обучения, широко используемый в различных приложениях машинного обучения. Он использует регуляризацию, отбрасывая подмножество данных на каждой итерации, что помогает предотвратить переобучение. Однако эти данные вне выборки (OOS), которые обычно остаются неиспользованными во время обучения модели, представляют собой нераскрытую возможность для повышения стабильности процесса обучения. В данной работе мы предлагаем новый подход, который использует OOS данные не только для оценки качества построенных деревьев решений, но и для целенаправленной оптимизации гиперпараметров. Оценивая корреляцию между фактическими и предсказанными значениями градиентов на OOS данных, мы выводим метрики, которые эффективно приближают производительность деревьев на невидимых тестовых данных. Наши эмпирические исследования, проведенные на коллекции реальных наборов данных размером до 100,000 примеров, демонстрируют эффективность этого метода. Результаты показывают последовательное снижение уровня ошибок с улучшениями до 2% по logloss по сравнению со стандартными реализациями SGB. Эти выводы подчеркивают потенциал настройки гиперпараметров на основе OOS данных не только для повышения точности модели, но и для предоставления вычислительно-эффективного пути к регуляризации в рамках градиентного бустинга.

Стохастический градиентный бустинг, регуляризация, подвыборки, ансамбль, машинное обучение

Короткий адрес: https://sciup.org/142242984

IDR: 142242984 | УДК: 004.852

Текст научной статьи Оптимизация стохастического градиентного бустинга с помощью out-of-sample оценок качества

Несмотря на значительные успехи глубоких нейросетевых алгоритмов, методы ансамблевого обучения, такие как градиентный бустинг (Gradient Boosting) [1], все еще являются неотъемлемой частью арсенала машинного обучения благодаря своей высокой точности и способности эффективно работать с большими и сложными данными [2]. Градиентный бустинг основывается на идее построения последовательности базовых моделей (как правило, решающих деревьев), в которой каждая следующая модель стремится уменьшить функцию потерь за счет приближения вектора градиента ошибок в точке текущего предсказания. Этот метод доказал свою эффективность и широко используется в современных задачах прогнозирования [3] от классификации и регрессии до решения задач в области обработки текстов и изображений.

В то же время градиентный бустинг подвержен проблеме переобучения, особенно на небольших или сильно шумных данных [4]. Для борьбы с переобучением были разработаны различные методы регуляризации, такие как контроль за глубиной деревьев, уменьшение скорости обучения и добавление шума в процессе обучения. Одним из таких методов является стохастический градиентный бустинг (SGB) [5], который включает случайную выборку подмножества данных на каждой итерации обучения. Это снижает корреляцию между деревьями и повышает обобщающую способность модели.

В последние годы были предложены методы усовершенствования алгоритма SGB [6], однако они в первую очередь сосредоточены на процедурах выбора наиболее информативной подвыборки. При этом текущие методы в основном не учитывают те данные, которые исключаются из каждой итерации обучения, то есть данные, оставшиеся «вне выборки» (out-of-sample, OOS). В большинстве случаев эти данные просто игнорируются, хотя могли бы быть полезны для повышения качества модели. В частности, они могут использоваться для оценки качества построенных деревьев и корректировки гиперпараметров модели, что потенциально может привести к еще более устойчивой модели с улучшенной обобщающей способностью.

Регуляризация играет ключевую роль в улучшении обобщающей способности моделей машинного обучения, и стохастический градиентный бустинг не является исключением. Однако до сих пор мало внимания уделялось использованию OOS данных для дополнительной оптимизации модели в процессе обучения, хотя такие данные традиционно используются в других ансамблевых методах, таких как бэггинг (bagging) [7].

В настоящей работе мы анализируем применимость OOS данных для регуляризации моделей градиентного бустинга, а также предлагаем новый способ их использования для оценки качества и оптимизации гиперпараметров деревьев решений, что позволяет достичь более высокой точности моделей и их устойчивости при применении к различным типам данных.

2. Градиентный бустинг

Формально задача градиентного бустинга [1] заключается в минимизации некоторой дифференцируемой функции потерь L(y,F (х)), г де у — истинное значение, F (ж) — предсказание модели.

Алгоритм начинается с константного предсказания:

п

F0(x) = arg min V' L(yi,c).

c ^-^

i=1

Затем на каждой итерации т добавляется новое дерево fm(x), которое минимизирует остаточную ошибку (градиент) текущей модели:

Fm(x) = Fm-1(x) + Vfm(x), где и — коэффициент скорости обучения (learning rate), который контролирует вклад каждого нового дерева.

Введем обозначение gm(xi) = ^^дн^2^^ • Основная идея градиентного бустинга заключается в том, чтобы на каждой итерации обучатв регрессионное дерево, используя градиенты функции потерь в качестве целевой переменной:

п fm = arg min ^ (-gm (xi) -f (xi ))2 . (1)

^ i=i

Здесь fm — новое дерево, которое аппроксимирует отрицательный градиент функции потерь.

Стохастический градиентный бустинг (SGB) [5] — это расширение стандартного градиентного бустинга, в котором на каждой итерации случайным образом выбирается подмножество обучающих данных для построения очередного дерева решений.

Формально процесс SGB можно описать следующим образом:

1) На т-й итерации случайным образом выбирается подмножество данных Sm из общего множества данных X с размером |Sm| = s х |X |, г де s — это коэффициент подвыборки (sampling rate).

2) Далее, на этом подмножестве данных Sm обучается очередное дерево fm(x), которое аппроксимирует негативный градиент функции потерь, аналогично стандартному градиентному бустингу.

3) После обучения дерево добавляется к модели с учетом коэффициента скорости обучения.

3. Эмпирический анализ качества обученных деревьев

Из описания процедуры построения модели градиентного бустинга (секция 2) следует, что одним из ключевых факторов, влияющих на качество модели бустинга, является качество предсказаний градиентов отдельными деревьями (уравнение 1). В данной секции мы рассмотрим результаты эмпирического исследования, проведенного для анализа того, как различные метрики качества отдельных деревьев влияют на общую производительность градиентного бустинга. В частности, внимание уделяется тому, насколько хорошо деревья справляются с задачей предсказания градиентов на каждой итерации и как эти предсказания отражаются на метриках качества на обучающей, OOS и тестовой выборках.

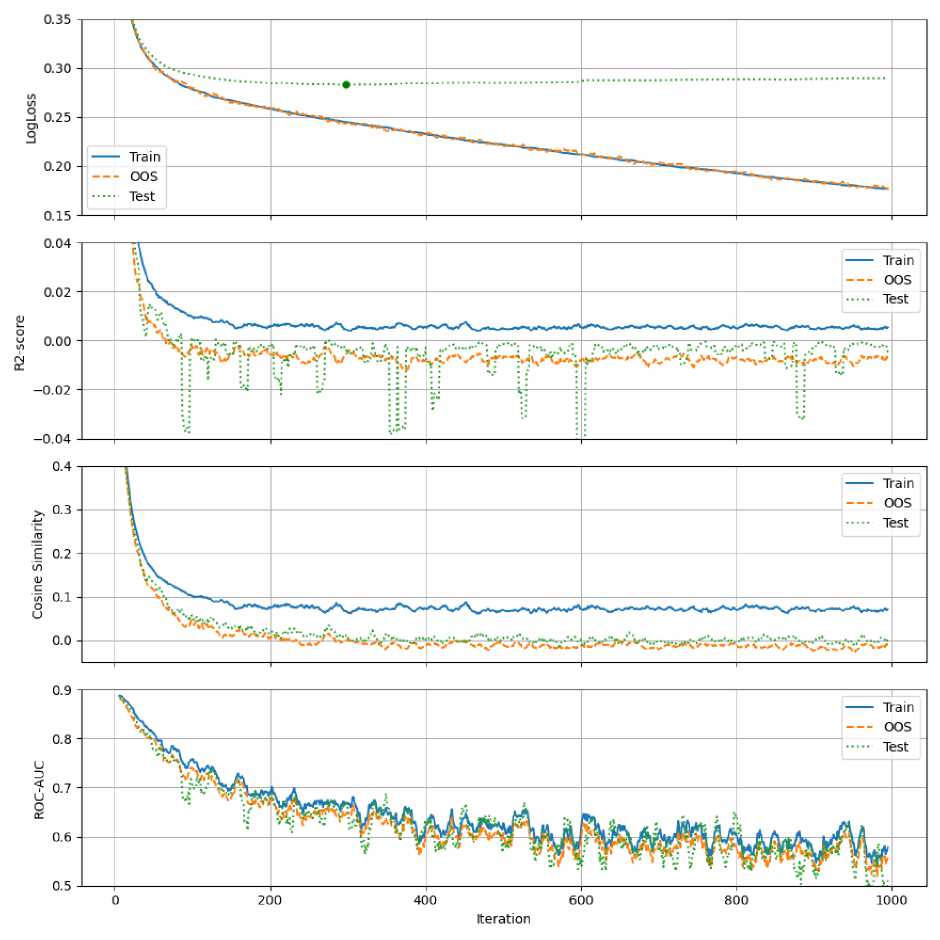

Для эксперимента исходные данные были разделены на обучающую и тестовую выборки в соотношении 4 к 1. Обучающая выборка, в свою очередь, была разделена на две части: 80% данных использовались для обучения деревьев на каждой итерации, а оставшиеся 20% — как данные вне выборки (OOS). Обучение модели стохастического градиентного бустинга проводилось с использованием 80%. данных на каждой итерации, а затем качество модели оценивалось на трех выборках: обучающей, OOS и тестовой. Гиперпараметры моделей были выбраны таким образом, чтобы гарантировать сходимость процесса обучения. В качестве исследуемых метрик для оценки качества отдельных регрессионных деревьев были взяты коэффициент детерминации (R2, косинусное сходство, roc-auc (предсказание знака градиента), а также Log Loss для оценки качества ансамбля после каждой итерации.

Результаты эксперимента на наборе данных Adult (та же картина наблюдается и на прочих наборах, перечисленных в секции 5) представлены на рис. 1. Первый вывод заключается в том, что качество регрессионных деревьев довольно быстро становится низким по мере увеличения количества деревьев, что заметно по отрицательным значениям R2 и околонулевым значениям косинусного сходства как для OOS выборок, так и для тестовой выборки. Причем резкое падение качества происходит еще до фактического момента переобучения, на что указывает тот факт, что даже при отрицательном качестве предсказаний отдельными деревьями тестовый logloss продолжает уменьшаться. Этот результат кажется неинтуитивным, учитывая, что задачей градиентного бустинга на каждой итерации является приближение значений градиентов.

Рис. 1. Оценка качества ансамбля (Log Loss) и отдельных деревьев ( R2, косинусное сходство, roc-auc) в зависимости от итерации. Маркером па первом графике выделена точка переобучения

Этот контринтуитивный результат может быть объяснен тем, что, несмотря на низкое качество предсказания величины градиентов, модели успешно справляются с предсказанием их знаков (график гос-апс), что позволяет процессу оптимизации двигаться в правильном направлении. На это же указывает и метрика косинусного сходства, которая вплоть до момента переобучения имеет хоть и слабо выраженные, но положительные значения. Подробная интерпретация и анализ приведенных выше эффектов приводится в секции 4.

Интересным наблюдением является факт, что на большинстве итераций качество на OOS данных оказывается ниже, чем на тестовых данных, несмотря на то, что последние обладают очевидным смещением, связанным с неизбежным эффектом переобучения. Этот результат можно объяснить тем, что OOS выборка является случайным подмножеством обучающих данных, которое может иметь меньший объем и большую вариативность оценок. Это ведет к большей чувствительности к шуму и, как следствие, к ухудшению метрик. Этот эффект связан с известным в статистике понятием смещения выборки или эффекта малой выборки [8], где меньшие подвыборки могут демонстрировать большее отклонение в метриках по сравнению с более репрезентативными выборками. В частности, при случайном разделении выборки на две части, их оценки среднего будут отрицательно скоррелированы в силу того, что они не являются независимыми.

Несмотря на то, что метрики качества на OOS данных хуже, чем на тестовых данных, и значительно хуже, чем на обучающей выборке, они демонстрируют высокую связь с метриками на тестовых данных. Это особенно заметно при визуальном анализе графиков, а также подтверждается тестом Спирмена. Такой результат указывает на то, что, несмотря на худшие показатели на OOS выборке, она все же предоставляет полезную информацию о том, как дерево будет вести себя на невидимых данных. Таким образом, OOS метрики могут служить надежным индикатором для оценки потенциального поведения модели и могут быть использованы для построения алгоритмов регуляризации моделей градиентного бустинга. В следующих секциях мы предлагаем один из подходов, основанный на этой идее, а также теоретическое и экспериментальное обоснование его эффективности.

4. Оптимизация обучения с помощью OOS оценок

Известно [1], что оптимизация среднеквадратичной ошибки (уравнение 1) при построении очередного дерева эквивалентна минимизации первого члена разложения по Тейлору изменения функции потерь:

mse„(x) = £Е^х.) + fm^ = -Е ^ ^ + СШ, let iel let | |

п

^Lm(X ) = ^^Qm^i) • ^fm(xi) = ЕЕ 9m(Xi) • ufm,l =

i =1

let iel

let

(E i e l 9m(Xi ) ) 2 \l\

где учтено, что дерево fm с листьями £ — кусочно-постоянная функция со значением fm,l = ЕщМе2 в листе I.

Важно отметить, что данная эквивалентность справедлива только для обучающей выборки и не выполняется для OOS и тестовых/валидационных выборок. Отсюда вытекает слабая связь процесса обучения и регрессионных метрик (секция 2). Также данный факт может являться подтверждением того, что низкое качество предсказания величин градиентов не обязательно ведет к низкому качеству итогового ансамбля. Аналогично, можно заметить связь падения косинусной схожести на OOS ниже нуля с началом переобучения. Это согласуется с представлениями выше, так как отрицательное значение скалярного произведения (рост функции потерь) на OOS выборке при малых шагах обучения означает низкую обобщающую способность построенного дерева.

Таким образом, минимизация скалярного произведения на OOS данных позволяет оценить изменение функции потерь на этих данных и служит основой для предлагаемого метода регуляризации:

к

^L m (Xoos) = gm (Xi ) • У f m(Xi) = ЕЕ gm(Xi) • Vfml.

i =1

lec iel

Заметим, что приведенная выше оценка является суммой независимых с.лагаемв1х по листьям. Таким образом, возникает возможность оценки качества отдельных листьев.

Мы предлагаем простой алгоритм регуляризации, который основан на величине OOS оценки скалярного произведения предсказания градиента в листьях. А именно: алгоритм оценивает знак соответствующей метрики в каждом листе и зануляет значение в тех листьях, в которых скалярное произведение оказалось положительным:

fm(x) = ^1( x G I) • 1 £ gm(X) • fm,l < 0 • fm,l.

lec V' e x oos n i /

5. Эксперименты

Для оценки эффективности предлагаемого метода регуляризации, он был реализован на базе современной библиотеки для обучения моделей градиентного бустинга PyBoost [9]. Обучение моделей проводилось с подбором гиперпараметров посредством 5-фо.лдовой стратифицированной кросс-валидации с максимальным числом деревьев, ограниченным до 1000. Это ограничение было выбрано для предотвращения переобучения и обеспечения устойчивости модели. Категориальные признаки обрабатывались с помощью алгоритма, описанного в статье CatBoost [10].

В таблице 1 представлен перечень использованных наборов данных и их характеристики, а также результаты сравнения качества моделей при различных долях сэмплирования для классического SGB и предложенного метода на основе OOS, описанного в секции 4. Все эксперименты были проведены на 10 независимых запусках с различными значениями случайного зерна (random seed), которое влияет на формирование подвыборок на каждой итерации. Важно отметить, что для каждого запуска случайное зерно для классического SGB и предложенного алгоритма было одинаковым, что позволяет проводить корректное сравнение эффективности этих подходов и использовать парный статистический тест (тест Уилкоксона), чтобы подтвердить значимость различий между двумя подходами. Усредненные результаты по всем 10 запускам также представлены в табл. 1.

Таблица 1

Результаты сравнения качества моделей (LogLoss) при различных долях сэмплирования для классического SGB и предложенного метода на основе OOS

|

Sampling Ratio |

0.1 |

0.3 |

0.5 |

0.7 |

0.9 |

|

Adult (49К/15) |

.2989/.2988 |

.2860/. 2853 |

.2830/.2815 |

.2799/.27Э4 |

.2789/. 2782 |

|

Amazon (ЗЗК/10) |

.1682/. 1670 |

.1645/. 1634 |

.1641/. 1631 |

.1638/. 1635 |

.1641/. 1638 |

|

Default (30K/23) |

.4.331/.4.330 |

.4322/.4323 |

.4.330/.4327 |

.4337/.4335 |

.4348/.4342 |

|

KDD Churn (50K/231) |

.2.349/. 2344 |

.2337/. 2333 |

.2329/.2325 |

.2329/.2326 |

.2329/. 2326 |

|

KDD Internet (10K/69) |

.2635/. 2610 |

.2470/.2468 |

.2343/.2312 |

.2308/.2291 |

.2295/.2294 |

|

KDD Upselling (50K/231) |

.1705/.1704 |

.1685/. 1681 |

.1673/4670 |

.1672/.1671 |

.1669/.1671 |

|

Kick (73K/36) |

.3000/. 2997 |

.2978/.2979 |

.2969/.2963 |

.2965.2959 |

.2959/.2959 |

|

Marketing (45K/16) |

.2107/. 2097 |

.2050/. 2043 |

.2022/.2O15 |

.2011/. 1999 |

.2007/. 2001 |

Жирным цветом выделены результаты со статзначимыми отличиями (p-value < 0.05) согласно парному тесту Уилкоксона.

Из приведенных результатов можно сделать вывод об эффективности использования OOS выборок для регуляризации моделей SGB. В подавляющем числе экспериментов удается достичь значимого уменьшения ошибки предсказаний. При этом значимость эффекта наблюдается независимо от уровня сэмплирования. Анализ значений р-value, по.лученнв1х с помощвю теста Уилкоксона, подтверждает статистическую значимость улучшений.

6. Заключение

В данной работе был предложен новый метод регуляризации стохастического градиентного бустинга (SGB) с использованием оценок качества на данных вне выборки (OOS). Основная идея заключается в том, чтобы использовать скалярное произведение между предсказанными и истинными градиентами на OOS данных для оценки качества модели и последующей коррекции структуры деревьев.

Эмпирические исследования показали, что предложенный подход позволяет значительно улучшить качество предсказаний модели на различных наборах данных. В частности, было отмечено уменьшение ошибки предсказаний (Log Loss) на тестовых данных по сравнению с классическими реализациями SGB. Важно отметить, что улучшения наблюдаются независимо от уровня сэмплирования, что подчеркивает универсальность метода.

Кроме того, проведенный анализ показал, что несмотря на низкие значения традиционных метрик, таких как R2 и косинусное сходство на OOS данных, предложенный метод позволяет сохранить высокое качество модели за счет оптимизации важнейшего показателя — направления градиента. Это открывает новые возможности для дальнейшего улучшения моделей машинного обучения, особенно в условиях ограниченного объема данных и наличия шума.

В качестве возможных направлений для будущих исследований можно отметить обобщение алгоритма на методы второго порядка, оценку возможности оптимизации прочих гиперпараметров (размер листьев, регуляризационные коэффициенты и т.п.), а также разработку более эффективных алгоритмы использования OOS оценок.

Список литературы Оптимизация стохастического градиентного бустинга с помощью out-of-sample оценок качества

- Friedman J.H. Greedy function approximation: a gradient boosting machine // Annals of statistics. 2001. P. 1189 1232.

- Roe B.P. [et al.}. Boosted decision trees as an alternative to artificial neural networks for particle identification // Nuclear Instruments and Methods in Physics Research Section A: Accelerators, Spectrometers, Detectors and Associated Equipment. 2005. V. 543. N 2-3. P. 577-584. EDN: HGFLZF

- Caruana R., Niculescu-Mizil A. An empirical comparison of supervised learning algorithms // Proceedings of the 23rd international conference on Machine learning. 2006. P. 161-168.

- Mease D., Wyner A. Evidence Contrary to the Statistical View of Boosting // Journal of Machine Learning Research. 2008. V. 9. N 2.

- Friedman J.H. Stochastic gradient boosting // Computational statistics & data analysis. 2002. V. 38. N 4. P. 367-378.

- Ke G. [et al.}. Lightgbm: A highly efficient gradient boosting decision tree // Advances in neural information processing systems. 2017. V. 30.

- Breiman L. Out-of-bag estimation. 1996.

- Heckman J. J. Sample selection bias as a specification error // Econometrica: Journal of the econometric society. 1979. P. 153-161.

- Iosipoi L., Vakhrushev A. Sketchboost: Fast gradient boosted decision tree for multioutput problems // Advances in Neural Information Processing Systems. 2022. V. 35. P. 2542225435.

- Prokhorenkova L. [et al.}. CatBoost: unbiased boosting with categorical features // Advances in neural information processing systems. 2018. V. 31.