Проблемы и перспективы применения искусственного интеллекта в финансовой сфере

Автор: Ларина О.И., Кузнецова В.В.

Журнал: Региональная экономика. Юг России @re-volsu

Рубрика: Фундаментальные исследования пространственной экономики

Статья в выпуске: 4 т.13, 2025 года.

Бесплатный доступ

В настоящее время термин «искусственный интеллект» (далее – ИИ) обобщает различные цифровые технологии (нейронные сети, машинное обучение, чат-боты, роботизированные системы, генеративный интеллект) и сферы их применения, такие как компьютерное зрение, обработка естественного языка, распознавание речи, интеллектуальные системы поддержки принятия решений, интеллектуальные роботизированные системы, используемые в том числе в различных сферах деятельности. В то же время отсутствует консенсусное определение понятия ИИ, в литературе и публичных выступлениях зачастую встречаются смешения технологий и используемых конкретных приложений. Отсутствие четкого определения и сопутствующего ему адекватного правового регулирования ограничивает применение технологии ИИ в гражданском обороте. В статье приводится сравнительный страновой анализ развития правового регулирования ИИ. Осуществлен обзор возможного использования ИИ в финансовой сфере, которая в текущий момент наиболее активно внедряет данную технологию. Программы ИИ могут быть встроены в общую операционную модель финансового института по-разному, наиболее распространенными являются централизованные модели управления технологическими инновациями. На основе системного анализа этапов и сфер применения технологий ИИ в финансовом секторе авторы выделяют и описывают группы рисков: общие риски, риски ввода данных, риски обработки данных, риски результатов. Авторский подход к классификации рисков может быть развит и применим в новых адаптированных системах риск-менеджмента. В зависимости от перспектив регулирования инноваций в статье разработаны четыре сценария возможного дальнейшего развития технологии искусственного интеллекта. Вклад авторов. О.И. Ларина – обзор литературы и анализ российского правового регулирования применения ИИ в России, систематизация рисков применения и разработка сценариев возможного дальнейшего развития технологии ИИ. В.В. Кузнецова – сравнительный страновой анализ развития правового регулирования ИИ, анализ сфер применения ИИ в финансовой сфере, систематизация рисков применения технологии ИИ.

Искусственный интеллект, финансовый сектор, цифровые технологии, риски, управление рисками, сценарии развития, правовое регулирование, инновации, нейронные сети

Короткий адрес: https://sciup.org/149149734

IDR: 149149734 | УДК: 339.97 | DOI: 10.15688/re.volsu.2025.4.9

Текст научной статьи Проблемы и перспективы применения искусственного интеллекта в финансовой сфере

DOI:

На данный момент одной из наиболее обсуждаемых в обществе тем является вопрос о том, насколько допустимо применение цифровых технологий искусственного интеллекта в разных сферах деятельности человека и какими могут быть последствия их широкого распространения. В научный оборот понятие ИИ ввел еще в 1955 г. профессор Стэнфорда Дж. Маккарти, определив его как науку и инженерию создания интеллектуальных машин [Manning, 2020]. В последнее десятилетие технологии ИИ быстро развивались, что было вызвано всеобщей цифровой трансформацией. В настоящий период во многих сферах деятельности уже стали широко применяться различные программные продукты на основе ИИ. Их многообразие и дальнейшее усложнение ставит вопрос о систематизации и применении обозначенной технологии в правовом поле. Ускорившийся в 2020-х гг. темп цифровых инноваций и скорость эволюции технологий и приложений ИИ затрудняют разработку точного и конкретного определения понятия «искусственный интел- лект», которое подходило бы к условиям разных юрисдикций и сфер социально-экономической активности.

Финансовая сфера выступает флагманом и пионером в области практического внедрения ИИ, хотя клиенты финансовых институтов пока по большей части остаются скептически настроенными в отношении ИИ: только 21 % клиентов используют банковские приложения ИИ, 26 % категорически отказываются ими пользоваться, а 57 % сомневаются в их полезности [Irwin, 2024]. Дальнейшее применение ИИ и в финансовой сфере, и в гражданском обороте в целом нуждается в адекватном правовом регулировании данной технологии. В свою очередь, отсутствие четкого и понятного определения понятия ИИ и возможных границ его использования сдерживает выработку пруденциальных подходов к регулированию и надзору за применением соответствующих программ в финансовом посредничестве.

Целью статьи является определение перспектив дальнейшего развития технологии искусственного интеллекта в финансовой сфере. Мето- дологией исследования выступает сравнительный страновой анализ развития правового регулирования ИИ, а также системный анализ этапов и сфер применения технологий ИИ в финансовом секторе.

Сложности теоретического и правового определения ИИ: обзор правовой базы

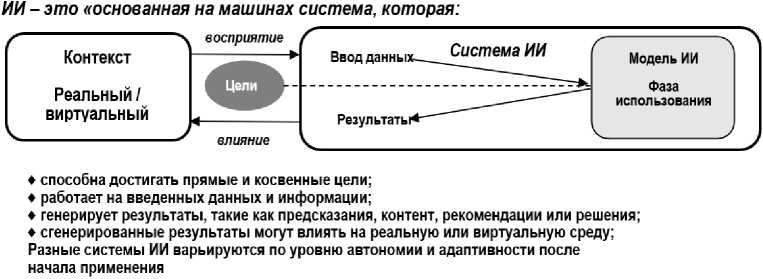

В современную эпоху попытка сформулировать общее определение понятия ИИ была предпринята экспертами Организации сотрудничества и экономического развития (далее – ОЭСР) в 2017 г., но уже в 2024 г. оно было обновлено и скорректировано. В соответствии с обновленным подходом ИИ – «это основанная на машинах система, которая в явных или неявных целях делает вывод из получаемых входных данных, генерирует выходные данные, такие как прогнозы, контент, рекомендации или решения, которые могут влиять на физическую или виртуальную среду.

Различные системы ИИ различаются по уровню автономности и адаптивности после развертывания» [Explanatory Memorandum … , 2024]. Данное обновленное определение ИИ было включено в первый международный Договор об ИИ, принятый Советом Европы 17 мая 2024 г. (рис. 1).

Для понимания того, насколько различны подходы разных юрисдикций к определению ИИ, в начале 2024 г. эксперты ОЭСР провели опрос регуляторов 49 юрисдикций, в которых активно развиваются и используются технологии ИИ. Результаты опроса показали, что только в 26 юрисдикциях действовали регуляторные определения понятия ИИ, еще в 13 было разработано стандартное определение, но оно носило необязательный характер или распространялось не на все сектора экономики, в остальных понимание ИИ оставалось нестандар-тизированным [Regulatory Approaches … , 2024].

Например, в настоящее время в трех юрисдикциях – ЕС, Южной Кореи и Бразилии – уже имеется специальное законодательство об ИИ (см. таблицу).

Рис. 1. Иллюстрация обновленного определения ИИ, разработанного экспертами ОЭСР Примечание. Составлено по: [Explanatory Memorandum … , 2024].

Таблица

Базовые характеристики законов ЕС, Южной Кореи и Бразилии

|

ЕС |

Южная Корея |

Бразилия |

|

Закон вступил в силу 01.08.2024. Классифицирует системы ИИ на 4 группы в зависимости от уровня риска; запрещает вредоносное использование ИИ; высокорисковые системы ИИ должны соответствовать строгим правилам качества данных, прозрачности, человеческого контроля и безопасности; системы ИИ должны сообщать пользователям, что они – ИИ, если они взаимодействуют с людьми, создают контент или принимают автоматизированные решения |

Закон был принят 26.12.2024, вступит в силу с 01.01.2026. Предусматривает формирование системы развития и регулирования, включая Национальный комитет ИИ и Научно-исследовательский институт безопасности ИИ; поддержку мер по развитию ИИ; создание механизмов для обеспечения безопасных и надежных баз данных для развития высокорискованного и генеративного ИИ |

Сенат одобрил закон 24.12.2024. Регулирует разработку, развертывание и использование ИИ; определяет обязательства поставщиков и операторов систем ИИ; запрещает использование систем ИИ с чрезмерным риском; разрешает разработчикам использовать защищенные авторским правом материалы для обучения моделей ИИ в некоммерческих целях; штрафы за несоблюдение комплаенса могут достигать 50 млн бразильских реалов (около 1,6 млн долл.) или 2 % от общего оборота компании |

Примечание. Составлено по: [EU AI Act ... , 2025; South Korea’s ... , 2025; Brazil AI Act].

В Колумбии, Израиле, Швейцарии, Сингапуре определение ИИ носит самый общий характер и охватывает разные виды деятельности. В США собственные определения ИИ есть у отдельных отраслевых ассоциаций (например, у Национальной ассоциации страховых комиссаров), а в Индонезии оно присутствует в формулировках общих принципов финансового надзора. В других странах, где технологии ИИ нашли широкое практическое применение, общепринятое определение ИИ отсутствует (Коста-Рика, Мексика, Турция, Гонконг, Китай). В Индии разработки и использование ИИ регулируют два закона: Information Technology Act (2000) и Digital Personal Data Protection Act (2023).

В России также постепенно разрабатывается нормативно-правовое регулирование ИИ:

– в 2019 г. был обнародован Указ Президента РФ от 10.10.2019 № 490 «О развитии искусственного интеллекта в Российской Федерации» и опубликована «Национальная стратегия развития искусственного интеллекта на период до 2030 года» [Национальная стратегия ... , 2019];

– в 2020 г. был принят Федеральный закон от 24.04.2020 № 123-ФЗ «О проведении эксперимента по установлению специального регулирования в целях создания необходимых условий для разработки и внедрения технологий искусственного интеллекта в субъекте Российской Федерации – городе федерального значения Москве и внесении изменений в статьи 6 и 10 Федерального закона “О персональных данных”» [Федеральный закон № 123-ФЗ, 2020].

В указанных правовых актах дано определение понятию ИИ как «комплексу технологических решений, позволяющему имитировать когнитивные функции человека (включая самообучение и поиск решений без заранее заданного алгоритма) и получать при выполнении конкретных задач результаты, сопоставимые как минимум с результатами интеллектуальной деятельности человека. Комплекс технологических решений включает в себя информационно-коммуникационную инфраструктуру (в том числе информационные системы, информационно-телекоммуникационные сети, иные технические средства обработки информации), программное обеспечение (в том числе случаи, когда используются методы машинного обучения), процессы и сервисы по обработке данных и поиску решений» [Федеральный закон № 123-ФЗ, 2020]. Кроме того, в России постепенно вводят разные ГОСТы, регулирующие применение ИИ в отдельных отраслях.

Так, с января 2025 г. вступил в силу ГОСТ Р 716572024 «Технологии искусственного интеллекта в образовании. Функциональная подсистема создания научных публикаций. Общие положения» [ГОСТ Р 71657-2024, 2024].

В связи с тем, что в настоящее время термин «технология искусственного интеллекта» включает различные цифровые технологии (например, машинное обучение, нейронные сети, генеративный интеллект и др.) и сферы применения, которые могут быть в различных областях, ни в России, ни в других государствах пока нет универсального правового документа, детально систематизирующего использование указанной технологии, что, в свою очередь, затрудняет ее применение в гражданском обороте.

Риски, связанные с применением технологий ИИ: обзор источников и авторский подход

На текущем этапе применения ИИ в научной литературе представлены разные исследования, касающиеся перспектив данной технологии. Например, интересен подход, предлагающий комплексную страновую оценку уровня внедрения искусственного интеллекта, где авторы разработали интегральный страновой показатель, характеризующий текущий уровень и прогноз дальнейшего развития технологии ИИ [Пьянкова, Митрофанова, Ергунова, 2025]. Другая научная литература посвящена выделению сопутствующих рисков. В основном специалисты указывают на кадровые риски [Локштанки-на, 2022; Смирнова, 2022] и риски утраты персональных данных [Тимохович, Булычева, 2020; Лотош, Платонов, Ткалич, 2021]. Специалисты компании IBM [Foundation Models… , 2023], например, выделяют три группы иных рисков: традиционные риски, то есть те, что были известны ранее или были выявлены на ранних этапах развития технологий; известные риски, но теперь усилившиеся в силу внутренних характеристик базовых моделей, прежде всего их генеративных способностей; проявляющиеся риски, присущие базовым моделям и их генеративным возможностям.

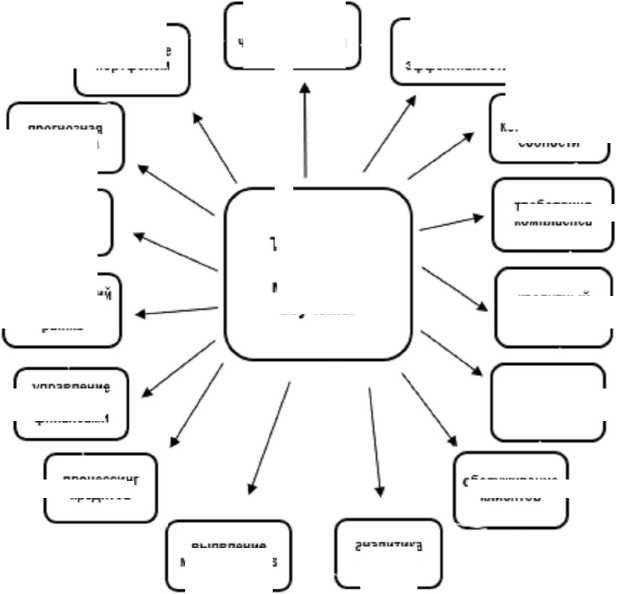

Возможен и иной подход к выделению групп рисков. Прежде всего выделим комплекс рисков, порождаемых самой технологией, – это общие риски. Более того, различные риски характерны для разных фаз применения программ моделей ИИ (см. рис. 2).

Риски ввода данных . Модели ИИ обучаются на больших объемах данных. Когда финансовые институты используют данные в риск-ме-неджменте или в работе с клиентами, результаты применения технологии напрямую зависят от качества вводимых данных. Действует прямая зависимость: «ошибочные данные на входе – ошибочные данные на выходе». Иными словами, если модель ИИ обучена на неверных и/или неполных данных, результаты также будут неверными или неполными. Важной предпосылкой для эффективного и действенного использования систем ИИ является обеспечение хорошего качества данных и применение модернизированных программ.

Риски обработки данных . Использование для обучения ИИ исторических данных может вести к тому, что модель будет копировать сложившиеся неравенства и исторические предубеждения, например игнорировать определенные группы потенциальных клиентов. Для этой фазы как минимум характерны следующие риски:

– риски пропускной способности : систематические ошибки в модели ИИ, известные как «смещение модели», могут привести к нежелательным или неверным результатам; смещение модели может возникнуть, если не были выбраны корректные данные для обучения или параметры модели были неверными, в результате чего обучение алгоритма будет искаженным; далее, когда в модель будут вводиться новые, более качественные данные, прежние систематические ошибки могут повторяться снова и снова из-за способа обучения модели, что может вести к нежелательным или неверным результатам;

– риски объяснимости: модель ИИ часто состоит из сети нескольких взаимосвязанных слоев (уровней) и способна иметь сотни параметров, поэтому не всегда возможно отследить ре- зультаты, сгенерированные моделью ИИ, до одного параметра, чтобы объяснить, почему следует принять то или иное решение, по этой причине можно представить технологию ИИ как модель «черного ящика».

Риски результатов . Программы ИИ способны выдавать нежелательные и/или предвзятые рекомендации, например дискриминирующие определенные группы клиентов. Использование программ ИИ для разработки персонализированных продуктов (услуг) или ценообразования может подавлять эффективность рыночного ценообразования и вести к несправедливому ценообразованию. Ценообразование на основе рекомендаций генеративного ИИ часто требует больших объемов данных о клиентах, включая конфиденциальные, что может вести к несоблюдению пруденциальных требований и профессиональной этики.

Таким образом, комплексный подход позволяет выделить общие риски, связанные с использованием технологий ИИ. Общие риски – это риски для функционирования всех финансовых институтов: смена бизнес-модели и структуры управления; неверная оценка рисков и неэффективная политика риск-менеджмента; приложения ИИ могут подрывать прибыльность организации, если они разрушают репутацию или дают некорректные предсказания и рекомендации; усиление зависимости от третьих сторон – поставщиков программ ИИ. Если несколько организаций одновременно используют одно и то же приобретенное программное обеспечение ИИ, это делает их всех зависимыми от одного и того же поставщика. Подобная концентрация рынка и массовые закупки программных продуктов могут вести к системному риску.

Следует выделить новые риски для регулирующих и надзорных органов. Этот комплекс

Общие риски: смена бизнес-модели; риски внутреннего управления; кибербезопасность

Риски ввода: некорректные, неполные данные

Риски обработки данных: использование модели "черного ящика", плохой риск- менеджмент

Риски результатов: социально неприемлемые результаты, дискриминация и др.

Рис. 2. Группы рисков, присущих технологии ИИ, для финансовых организаций Примечание. Составлено авторами.

рисков значителен и включает риск фальсификаций отчетных данных и риск усиления финансовой нестабильности.

Риск фальсификаций отчетных данных возникает при использовании генеративного ИИ для подготовки регуляторных отчетов. Использование генеративного ИИ (ChatGPT) сопряжено с дополнительными рисками, связанными, в частности, с распространением неточностей и дезинформации. Сгенерированный контент может содержать неточности (называемые «галлюцинациями моделей») и таким образом приводить к распространению неверной информации и генерации фальшивых отчетов для регулирующих и надзорных органов.

Риск усиления финансовой нестабильности . Финансовая система содержит ряд внутренних уязвимостей (асимметрия информации, стратегические взаимосвязанности и взаимодополняемости финансовых институтов, неопределенности и др.), в силу которых развиваются финансовые кризисы. Они могут негативно взаимодействовать с внутренней логикой программ ИИ и тем, как последние применяются финансовыми институтами. Как минимум дестабилизация финансовой системы, обусловленная широким применением технологий ИИ, может распространяться по четырем каналам:

– канал злонамеренного использования: если финансовые институты обучают системы ИИ обходить пруденциальные требования и/или дистанционный надзор, то регулирующим и надзорным органам крайне сложно выявить подобные уловки; системы ИИ также могут стимулироваться на использование технологии для противоправной деятельности;

– канал дезинформации: пользователи программ (приложений) ИИ не понимают ограничений технологии и постепенно становятся от него зависимыми; особенно выражено воздействие этого канала для макропруденциальной политики, так как критерии оценки ее результативности расплывчаты, а базы данных ограниченны; в этом случае рекомендации, генерируемые ИИ, могут быть ошибочными («галлюцинация ИИ»);

– канал несоответствия: в его основе – сложности обеспечения того, чтобы сгенерированные системой ИИ рекомендации соответствовали целям, поставленным операторами. При множественности конфликтующих целей программа ИИ способна выстроить свою иерархию целей нежелательным для финансовых регуляторов образом. Результатом могут стать дестабилизирующие финансовую систему «набеги» на финансовые институты, распродажи активов, внезапные дефициты рыночной ликвидности и др.;

– канал структуры рынка: разработка и эксплуатация систем ИИ зависит от трех дефицитных ресурсов – качества человеческого капитала, вычислений и данных. Если на финансовом рынке доминирует олигополистическая структура поставщиков технологий и их пользователей, то это усиливает процикличность и вероятность системного финансового риска.

Помимо обозначенных в разделе специфических рисков, для всех финансовых институтов возникают также общественные риски применения ИИ: возможность утечки конфиденциальных данных; киберриски (хакерские атаки, манипулирование данными, комплексные атаки и мошенничества); дополнительное потребление электроэнергии; изменение структуры занятости.

Применение ИИ финансовыми институтами

В настоящее время, как следует из данных доклада PYMNTS 1 за 2024 г., 72 % ведущих финансовых институтов уже применяют те или иные программы (приложения) ИИ, хотя и в разной степени активно [Finance Leaders ... , 2024]. Наибольшее применение в деятельности финансовых институтов получили программы ИИ по выявлению мошенничеств и оценке рисков (64 %). Программы ИИ и машинного обучения многие финансовые институты также используют для выполнения и других отдельных задач: оптимизации ИТ-операций, повышения эффективности операционного менеджмента, цифрового маркетинга (включая персонализированные предложения), кредитного скоринга, оптимизации продаж и инвестиций, управления портфелями активов. Одно из не менее важных направлений применения технологий ИИ занимает управление комплаенсом и генерирование соответствующих регуляторных отчетов. Вместе с тем спектр возможных направлений применения технологий ИИ и машинного обучения финансовыми институтами может быть существенно шире (см. рис. 3).

Все финансовые регуляторы – респонденты опроса ОЭСР [Explanatory Memorandum ... , 2024] единогласно отметили, что участники финансового сектора в настоящее время экспериментируют, разрабатывают и/или внедряют различные программные приложения ИИ. Однако у органов регулирования и надзора за финансовыми институтами нет четкого понимания того, как именно они применяют приложения ИИ, поскольку, как правило, пока нет нормативно-правовых требований к поднадзорным субъектам финансового сектора информировать надзорные (контрольные) органы об использовании или экспериментировании с программами ИИ.

Ряд финансовых институтов уже начинает использовать технологии генеративного ИИ (Gen-AI). Как следует из исследования McKinsey Global Institute [Scaling ... , 2024], новое поколение технологий ИИ может принести финансовым институтам серьезные материальные выгоды. По оценкам экспертов института, применение приложений генеративного ИИ позволит финансовым организациям дополнительно получать от 200 до 340 млрд долларов. Однако одновременно использование программ генеративного ИИ порождает и новые сложности – еще не до конца понятые или пока неизвестные риски.

В первую очередь сложности применения различных приложений генеративного ИИ связаны с тем, каким образом они включены в общую операционную модель финансового института и как они трансформируют общую бизнес-модель финансовых институтов. На текущем этапе применения программ генеративного ИИ большин- ство финансовых институтов, обследованных McKinsey Global Institute, отдает предпочтение централизованной модели управления ими в силу нескольких причин:

– на ранних этапах внедрения технологии возникает необходимость быстро и скоординированно принимать решения по различным вопросам;

– в связи с нехваткой специалистов по генеративному ИИ централизованное управление ими позволяет финансовому институту использовать их более эффективно;

– в быстро меняющихся внешних условиях, включая постоянное совершенствование программ генеративного ИИ, централизованное управление помогает более результативно контролировать результаты и риски использования технологии;

– для упрощения своевременного отслеживания изменений в нормативно-правовом регулировании.

Любая модель управления, которая задействует программы генеративного ИИ, влияет на организационную структуру финансовых институтов и процедуры принятия как операционных решений, так и практик планирования развития и несет в себе новые риски, с которыми организации ранее не сталкивались.

управление портфелем алгоритми -ческая торговля повышение конкурентоспособности автоматизация и эффективность анализ эмоции участников рынка риск-менеджмент

снижение издержек выявление мошенничеств аналитика данных

Рис. 3. Возможные сферы применения технологий ИИ и машинного обучения финансовыми институтами Примечание. Составлено по: [Finio, Downie, 2023].

прогнозная аналитика

требования комплаенса

управление личными финансами

процессинг кредитов

Технологии ИИ и машинного обучения

кредитный скоринг

обслуживание клиентов

Заключение и выводы

На основе ситуативного моделирования дальнейшего развития направлений технологии и соответствующего им нормативно-правового регулирования представим возможные сценарии развития ИИ (рис. 4).

Так, авторы выделяют четыре возможных сценария развития ИИ: максимально благоприятный (ИИ для общества), консервативный и рискованный (ИИ для регуляторов и непроверенный ИИ), а также негативный («Зима» ИИ). Для проектирования благоприятного сценария необходимо активное развитие технологии и адекватное правовое регулирование. С одной стороны, введение общего законодательства, регулирующего ИИ без отраслевой специфики, может стимулировать разработки и внедрение инновационных технологий. С другой стороны, эта ситуация позволяет финансовым институтам применять различные программы ИИ без уведомления регулирующих органов и клиентов, что повышает рискованность их деятельности и уязвимость их клиентов. Авторы поддерживают мнение о необходимости введения правового (специализированного по отраслевому направлению) регулирования применения ИИ.

Использование искусственного интеллекта в финансовой сфере будет влиять на многие системы, организационную структуру финансовых институтов, процедуры принятия решений и практику планирования развития, что, в свою очередь, несет в себе новые риски, с которыми организации ранее не сталкивались. Научная новизна и теоретическая значимость настоящего исследо- вания заключаются в авторском подходе к идентификации и систематизации рисков, присущих технологии ИИ, для финансовых организаций, а также в применении ситуативного моделирования дальнейшего развития направлений технологии и соответствующего им нормативно-правового регулирования.