Структура, характеристики и задачи Самарского академического центра высокопроизводительной обработки информации

Автор: Шорин В.П., Сойфер В.А., Кравчук В.В., Фурсов В.А.

Журнал: Известия Самарского научного центра Российской академии наук @izvestiya-ssc

Рубрика: Информатика и вычислительная техника

Статья в выпуске: 1 т.2, 2000 года.

Бесплатный доступ

Описывается структура высокопроизводительных ресурсов науки и образования Самарского региона, включающих кластеры вычислительных машин Института систем обработки изображений и Самарского научного центра РАН. Приводятся результаты тестирования и оценки производительности указанных кластеров. Формулируются задачи центра высокопроизводительной обработки информации, обсуждаются перспективы его развития.

Короткий адрес: https://sciup.org/148197556

IDR: 148197556

Текст научной статьи Структура, характеристики и задачи Самарского академического центра высокопроизводительной обработки информации

В последнее десятилетие в ведущих странах мира усилилось внимание к созданию и применению высокопроизводительной вычислительной техники. Связано это с тем, что ряд глобальных проблем, возникших перед человечеством (космические исследования, управляемый термоядерный синтез, моделирование атмосферы и мирового океана, предсказание погоды и глобальных изменений в атмосфере, генетика человека и др.), могут быть решены лишь путем проведения фундаментальных научных исследований, включающих масштабные численные эксперименты или инженерные задачи с широкой областью применения (Grand challenges) [1]. Эффективное решение этих задач возможно только на современных суперкомпьютерах. В настоящее время признано экономически более выгодным концентрировать мощные вычислительные ресурсы в центрах коллективного пользования и развивать инфраструктуру удаленного доступа к ресурсам с использованием средств телекоммуникаций.

Потребности организаций Самарского научного центра (СНЦ) РАН и крупнейших ВУЗов г. Самары поставили в повестку дня создание распределенной среды науки и образования на основе центра высокопроизводительной обработки информации. Важным организационным этапом создания такого центра явилось создание в декабре 1998 г. по согласованному решению руководителей крупнейших ВУЗов и ряда научных органи заций г. Самары учебно-научного центра «Исследовательский университет высоких технологий» (ИУВТ). Одна из целей его создания заключалась в совместном использовании научного оборудования и развитии материальной базы фундаментальных исследований для решения проблем акустики машин, аэродинамики, прочности, цифровой обработки изображений, компьютерной оптики, автоматизированного проектирования летательных аппаратов и оптических систем, моделирования сложных систем и др.

Активная работа по созданию центра высокопроизводительной обработки информации началась с середины 1999 г. Первым этапом явилось создание однородного кластера из 4-хвычислительных машин в Институте систем обработки изображений (ИСОИ) РАН. Вторым этапом явилось создание кластера вычислительных машин в СНЦ РАН. В настоящей статье описываются топология, характеристики производительности указанных кластеров, а также обсуждаются основные задачи формируемого на их основе регионального академического центра высокопроизводительной обработки информации (ЦВОИ).

Структура центра высокопроизводительной обработки информации

Самарский региональный ЦВОИ структурно объединяет два кластера вычислительных машин: однородный кластер ИСОИ РАН и высокопроизводительный кластер СНЦ

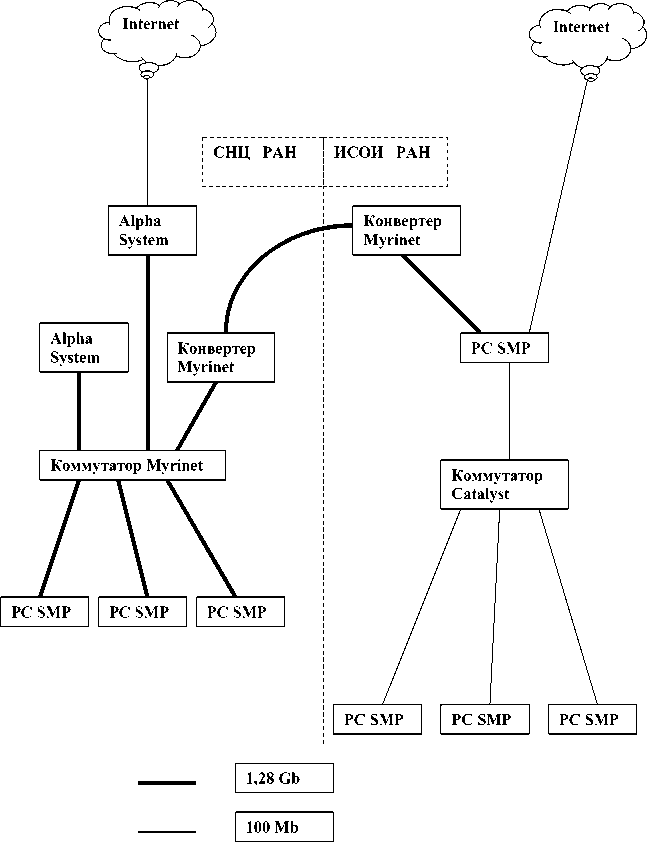

Рис. 1. Общая топологическая схема кластеров СНЦРАН и ИСОИРАН

РАН [2]. На рис. 1 приведена общая топологическая схема кластеров ИСОИ РАН и СНЦ РАН, а на рис.2 - внешний вид кластера СНЦ РАН.

Узлами кластера ИСОИ РАН являются стандартные двухпроцессорные компьютеры с процессорами Intel Pentium II и сетевыми адаптерами Fast Ethernet (100 Mb/s). Один узел снабжен дополнительным сетевым интерфейсом, через который осуществляется удаленный доступ к кластеру. Компьютеры связаны между собой через коммутатор Catalyst 2912. Общие ресурсы кластера: 8 процессоров, 2Gb оперативной памяти и 36Gb дисковой памяти.

Кластер СНЦ РАН состоит из пяти компьютеров: главного хоста и четырех узлов. Главный хост кластера представляет собой двухпроцессорный SMP компьютер на базе материнской платы UP2000 и микропроцес соров ALPHA 21264DP с тактовой частотой 667 MHz. Этот компьютер оснащен 4 MB кэш, 2 GB оперативной памяти, рейд контроллером, стриммером, флоппи дисководом 3,5". Общий объем дисковой памяти составляет 72GB, полезный объем - 54GB. В главный хост установлены три сетевых адаптера: Myrinet и два адаптера FastEthernet, через один из которых осуществляется удаленный доступ к кластеру, а второй подключен к служебной сети кластера.

Узлы кластера представлены различными типами вычислительных машин. Материнская плата и микропроцессоры первого узла кластера такие же, как у главного хоста. Он оснащен оперативной памятью объемом 1 GB, у него отсутствует рейд контроллер и стриммер, а объем дисковой памяти составляет 18GB. В нем установлены два сетевых адаптера: Myrinet и FastEthernet.

Рис. 2. Внешний вид кластера СНЦРАН

Три оставшихся узла представляют собой двухпроцессорные SMP компьютеры на базе микропроцессоров Intel Pentium III с тактовой частотой 600 MHz, в каждом из которых установлено по 512MB оперативной памяти, винчестер объемом 18GB и два сетевых адаптера: Myrinet и FastEthernet.

В качестве основной телекоммуникационной среды передачи сообщений кластера СНЦ РАН используется сеть Myrinet, обеспечивающая высокую скорость передачи данных между узлами. Узлы кластера соединены между собой по логической схеме «Звезда». Схема реализована на шестнадцатипортовом коммутаторе. Служебная сеть кластера построена на FastEthernet (100Mb/c). Установленное сетевое оборудование позволяет подключить дополнительно одиннадцать узлов. Установлены также оптический канал и конвертеры, соединяющие кластер СНЦ РАН с кластером ИСОН РАН.

На каждом компьютере кластера установлена свободно-распространяемая операционная система LINUX RedHat-6.2. На всех компьютерах работают демоны telnetd, ftpd, rshd. Служебная сеть кластера основана на стеке протоколов TCP/IP. В служебной сети используется статическая маршрутизация.

На всех компьютерах установлена коммуникационная система GM передачи сообщений для Myrinet. Эта система обеспечивает надежную доставку сообщений длиной до 231-1 байт, работает на кластерах с большим числом узлов, автоматически определяет и поддерживает топологию сети Myrinet, обеспечивает малую задержку и имеет ряд других достоинств. В качестве системы передачи сообщений используется пакет mpich-1.1.2..13, реализующий MPI через Myrinet. На кластере установлены компиляторы языков программирования C, C++ и Fortran( gcc,g++ и g77) с соответствующими библиотеками и файлами заголовков.

Характеристики производительности кластеров

Пиковая производительность кластера ИСОН РАН - 3,4 GFLOPS, кластера СНЦ РАН - 8.9 GFLOPS. Для оценки реальной производительности кластеров и сетевых средств, на основе которых эти кластеры функционируют, проводились испытания на некоторых общепризнанных тестах.

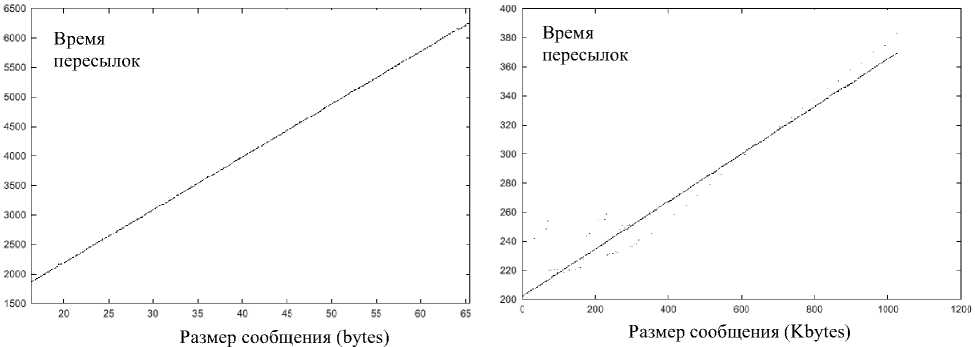

а) б)

Рис. 3. Скорость пересылок по сети FastEthernet кластера ИСОИРАН а) при малом размере сообщений, б) при большом размере сообщений

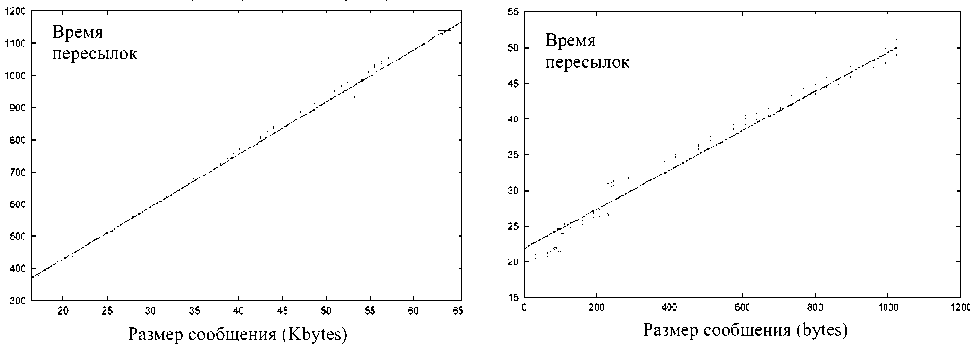

а) б)

Рис. 4. Скорость пересылок по сети Myrinet кластера СНЦРАН а) при малом размере сообщений, б) при большом размере сообщений

Вычислительная мощность кластера ИСОИ РАН проверялась на тестах NPB2.3, разработанных в исследовательской лаборатории NASA. Оценка производительности сети передачи данных обоих кластеров производилась на тестах, поставляемых с пакетом mpich. Кластер ИСОИ РАН показал также высокую производительность на тестах NAS Benchmarks.

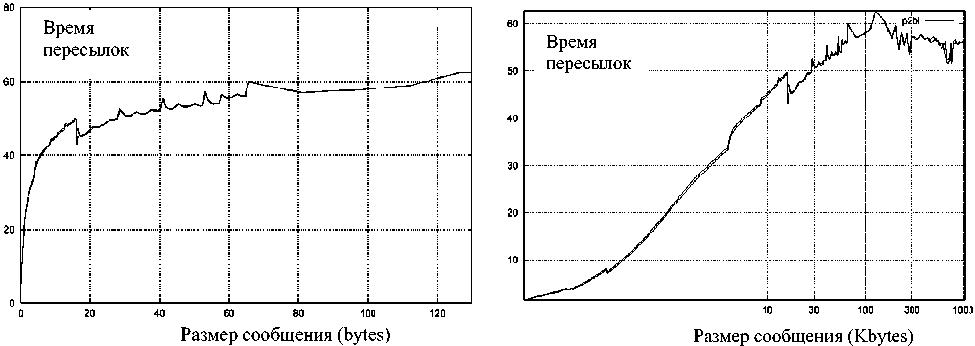

На рис.3 приведены результаты сетевых тестов, выполненных на кластере ИСОИ РАН, построенного на сетевой технологии FastEthernet, а на рис.4, 5 - для кластера СНЦ РАН, использующего среду Myrinet.

Планируется дальнейшее развитие архитектуры регионального центра высокопроизводительной обработки информации с це лью повышения производительности, заключающееся в интеграции ресурсов кластеров ИСОИ РАН и СНЦ РАН. Предпосылкой для этого является наличие оптического канала и конвертеров, соединяющих кластер СНЦ РАН с кластером ИСОИ РАН. Объединение мощностей кластеров может быть достигнуто с минимальным уровнем дополнительных затрат путем перевода кластера ИСОИ РАН на сетевую технологию Myrinet. При этом будет достигнуто повышение пиковой производительности центра до 12,3 GFLOPS.

В настоящее время кластеры являются доступными с любого компьютера, имеющего доступ в сеть Интернет, но могут использоваться для решения задач лишь раздельно. Например, сотрудниками ИСОИ РАН выпол-

а)

б)

Рис. 5. Производительность сети Myrinet кластера СНЦРАН а) при малом размере сообщений, б) при большом размере сообщений

няются научные расчеты на обоих кластерах, в частности, осуществляется моделирование прохождения электромагнитной волны через антиотражающую структуру посредством разностного решения уравнений Максвелла.

Задачи центра высокопроизводительной обработки информации

ЦВОИ открывает качественно новые возможности для развития инфраструктуры распределенной среды науки и образования, является основой для дальнейшего интегрирования имеющихся в регионе информационно-вычислительных ресурсов. Для достижения этих целей необходимо четко сформулировать основные задачи ЦВОИ. Представляется, что основные направления деятельности центра высокопроизводительной обработки информации должны состоять в следующем:

-

- предоставление пользователям высокопроизводительных вычислительных ресурсов, в т.ч. в режиме удаленного доступа через региональную академическую телекоммуникационную сеть науки и образования;

-

- проведение научных исследований по обеспечению и развитию системного и прикладного математического обеспечения и решению задач большой сложности;

-

- оказание помощи пользователям в разработке и распространении прикладного программного обеспечения для высокопроизводительных параллельных вычислений;

-

- содействие развитию дистанционного образования, предоставление пользователям информационных ресурсов (серверов, баз данных по различным областям науки и техники, образования и др.);

-

- интеграция ЦВОИ в информационно-вычислительную среду науки и образования, формируемую на основе суперкомпьютерной сети России;

-

- поддержка региональных образовательных программ, связанных с подготовкой и переподготовкой специалистов по высокопроизводительным параллельным вычислениям;

-

- научно-методическое содействие региональным проектам перевооружения новейшими информационными технологиями предприятий Поволжья.

Для решения указанных задач необходима концентрации усилий и средств на региональном уровне, в частности, формирование комплексной региональной целевой программы развития ЦВОИ и инфраструктуры удаленного доступа к его ресурсам. Реализация такой программы позволит Самарскому региону выйти на качественно новый уровень информационных технологий и научной поддержки промышленности, повысит инвестиционную привлекательность региона и создаст базу для его ускоренного экономического развития.