Технологии искусственного интеллекта в государственном управлении: разработка парадигмы разумного (само)ограничения

Автор: Федоров М.В., Репин Д.А., Игнатьев С.А.

Журнал: Известия Санкт-Петербургского государственного экономического университета @izvestia-spgeu

Рубрика: Государственное регулирование экономики

Статья в выпуске: 5 (149), 2024 года.

Бесплатный доступ

Актуальность исследования детерминирована стремительным развитием технологий искусственного интеллекта (ИИ), их активным внедрением практически во все сферы человеческой жизнедеятельности. Имплементация технологий ИИ в инструментальный базис системы государственного управления оказывает значительное влияние на трансформацию смысловой нагрузки управленческих функций в сфере государственного администрирования. С другой стороны, последствия применения таких технологий становятся все менее очевидными и станут еще менее очевидными в среднесрочной и долгосрочной перспективе. Это ставит научное сообщество перед необходимостью определить и исследовать факторы ограничения применения технологий ИИ в процессах государственного управления и разработать с учетом оценки этих факторов соответствующую парадигму разумного(само)ограничения.

Искусственный интеллект, государственное управление, правовые ограничения, риск-ориентированный подход, этика в области искусственного интеллекта

Короткий адрес: https://sciup.org/148331370

IDR: 148331370

Текст научной статьи Технологии искусственного интеллекта в государственном управлении: разработка парадигмы разумного (само)ограничения

Развитие технологий искусственного интеллекта (ИИ) занимает ведущую позицию в мировых научнотехнологических приоритетах; более того, многочисленные данные убедительно свидетельствуют о перспективах стремительного роста динамики его влияния не только на дальнейшее развитие современной техногенной цивилизации, но также об усилении технологий ИИ в качестве чрезвычайно важного и самостоятельного фактора кардинальных, трудно поддающихся прогнозу и управлению, трансформаций в социально-экономической, общественно-политической, культурной (в широком смысле) и военной сферах на национальном и глобальном уровнях.

Вследствие этого обладание преимуществами в сфере ИИ и способность оказывать воздействие на данную сферу создают для государств и разнообразных негосударственных акторов исключительные возможности влиять на развитие человечества, с одной стороны, и формируют отдельные контуры международной напряженности в борьбе за достижение этих целей, с другой. В контексте обозначенных процессов особую остроту приобретает проблема применения технологий ИИ в государственном управлении, которая отражает в себе комплекс сложившихся противоречий в развитии общества на современном этапе развития.

Иными словами, основные тренды использования ИИ как элемента системы национального управления тесно увязаны с проблематикой и рисками, свойственными сложившимся за последние тридцать лет канонам глобализации, переходящим в настоящее время в стадию своей активной конфликтной трансформации в сторону глобальной многополярности и преобразования мировой экономической модели.

В исторической ретроспективе отчетливо просматриваются многие поворотные моменты, сложившиеся под влиянием технического прогресса. Масштабные и коренные преобразования последних десятилетий в сфере государственного управления также во многом детерминированы технологическим развитием и ускоряющейся имплементацией технологий ИИ в управление социально-экономическими процессами. Одновременно с этим процессы формирования многоуровневых экосистем и форсирование внедрения ИИ-технологий в государственное управление создают не только беспрецедентные возможности, но также порождают сложно прогнозируемые риски и угрозы.

В качестве отдельного комплекса проблем, важность решения которых сообщает особую актуальность всей проблематике настоящего исследования, следует рассматривать различные направления цифровой трансформации экономики и социальной сферы на основе ИИ. Вместе с тем, именно научно-технологическое развитие Российской Федерации превращается в одно из ключевых условий обеспечения независимо сти государства и достижения прочного технологиче ского суверенитета. О масштабе протекающих процессов убедительно говорит язык цифр: согласно данным Счетной палаты Российской Федерации на декабрь 2022 г., только общая стоимость владения федеральными го сударственными инфосистемами с начала их формирования по декабрь 2021 г. превысила 296 млрд рублей [15, с. 14].

Таким образом, внедрение ИИ-технологий в многообразную и сложноорганизованную практику государственного управления входит в число наиболее актуальных проблем, решение которых во многом определяет результативность и эффективность решения важнейших государственных задач, определит степень достижения национальных целей развития [18]. В настоящей статье проведен анализ основных направлений внедрения технологий ИИ в государственное управление и ограничивающих этот процесс факторов, позволяющий наметить теоретико-методологические подходы к разработке соответствующей парадигмы (само)ограничения дальнейшей инкорпорации технологий ИИ в систему национального администрирования как на современном этапе ее развития, так и в среднесрочной перспективе.

Материалы и методы

Применение системного подхода в настоящем исследовании позволило провести комплексный анализ внедрения технологий ИИ в среду государственного управления, вывить управляющие взаимосвязи, изучить многоуровневость институционализации применения ИИ-технологий в управленческих процессах.

Наряду с системным подходом важным исследовательским инструментом стал и риск-ориентиро-ванный подход. Несмотря на то, что в современной научной литературе по проблемам риск-менедж-мента еще не сложился общепризнанный подход к определению единой методологической базы в исследовании процессов внедрения технологий ИИ в систему государственного управления, изучение данной проблематики позволяет заключить, что термин «менеджмент» тесно сопряжен с понятием «управление» (в его широкой трактовке), что, таким образом, позволяет эффективно использовать риск-ориентированный подход в настоящем исследовании.

В качестве исходных данных использованы опубликованные документы и материалы различных профильных государственных ведомств, экспертно-аналитических центров, а также научные публикации ведущих специалистов в данной области, отечественных и зарубежных. Также в качестве базовых источников послужили нормативно-правовые акты различного уровня, а также национальные и международные стандарты, Рекомендация об этических аспектах искусственного интеллекта ЮНЕСКО [20] и другие материалы по различным аспектам внедрения технологий ИИ в систему государственного управления.

Следует отметить, что в настоящее время научно-экспертным сообществом используется более ста различных дефиниций для определения понятия «искусственный интеллект», при этом в общественном восприятии ИИ воспринимается еще более гибко [9]. Вместе с тем, следуя укоренившемуся в литературе подходу, основанному на идеях специалиста в области ИИ и технооптимиста Рэя Курцвейла, в настоящей работе дифференцируя технологии соответствующие на «слабый» («узкий») и «сильный» ИИ [7], подразумевая в первом случае технологии, ограниченные решением конкретной задачи, на основе некоторой имитации отдельных характеристик модели человеческого поведения и автоматизации ряда процессов; и технологии, уровень развития которых позволяет имитировать человеческий разум, радикально выходя за рамки мыслительных возможностей человека в решении отдельных задач, скорости обработки информации и числу одновременных операций – во втором.

Таким образом, контекстуально в статье анализируются проблемы и перспективы внедрения ИИ в процесс государственного управления, основанные как на слабом (узком) ИИ, так и на «сильном» ИИ. Такой подход представляется соответствующим закрепленному в Указе Президента Российской Федерации от 10 октября 2019 г. № 490 «О развитии искусственного интеллекта в Российской Федерации» определению ИИ в качестве комплекса технологических решений, создающих возможности имитировать когнитивные функции человека (включая поиск решений без заранее заданного алгоритма) и достигать при выполнении конкретных задач результаты, сопоставимые с результатами интеллектуальной деятельности человека или превосходящие их [17].

Основные результаты и их обсуждение

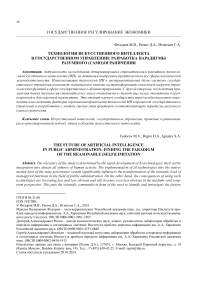

Отправной точкой исследования послужил анализ существующих лимитаций внедрения технологий ИИ в систему государственного управления в целях их последующей дифференциации (классификации). По результатам проведенного анализа существующие барьеры внедрения ИИ-технологий в систему государственного управления (рис. 1) можно объединить в несколько групп: ограничения, связанные с безопасностью; инфраструктурно-технологические; административно-регуляторные; кадровые; инвестиционные.

В качестве отдельного ограничителя следует выделить этику в области ИИ, поскольку она в той или иной мере влияет на роль и потенциал каждого из вышеуказанных барьеров, при этом этика в области ИИ – разработки и внедрения ИИ-технологий в государственном управлении – выступает в этом процессе как философская, идейно-ценностная или даже идеологическая платформа реализации соответствующей технологической политики, а также в качестве специфического инструментария конкурентной борьбы, разворачивающейся на межгосударственном уровне и на уровне технологических корпораций в региональных и глобальных масштабах.

эт

и

ИНФРАСТРУКТУРА И ТЕХНОЛОГИИ

АДМИНИСТРИРОВАНИЕ ПРОЦЕССОВ

Рис. 1 . Ограничения внедрения ИИ-технологий в государственное управление

Для выработки разумной (научно-обоснованной) парадигмы (само)ограничения в применения методов ИИ в государственном управлении представляется целесообразным оценивать потенциал и эффективность внедрения технологий ИИ в инструментарий государственного управления через выявление, осознание и научную разработку всех факторов лимитации, с особенным учетом безопасности и этического фактора. Рассмотрим подробнее данные аспекты.

Ограничения внедрения ИИ-технологий в систему государственного управления, связанные с администрированием данного процесса, наряду с комплексом проблем безопасности, являются ключевым набором различных препятствий не только для эффективной и результативной имплементации ИИ в государственное управление, но и для определения лимитов его внедрения в целом. Как и в случае с блоком этических проблем, тематика обеспечения безопасности пронизывает все направления внедрения ИИ-технологий в управленческие процессы, находясь, вместе с тем, на гораздо более приоритетном положении как относительно этической проблематики, так и в соотношении с остальными перечисленными барьерами внедрения ИИ-технологий в государственное управление.

Препятствия внедрения ИИ, связанные с проблемами безопасности, многоуровневые. В этом блоке можно выделить государственный уровень и уровень индивидуума. Угрозы безопасности государственного масштаба, связанные с использованием ИИ в госуправлении, например, кибертерроризм, использование уязвимостей облачных технологий, несанкционированное использование национальных и международных баз данных и т.д.

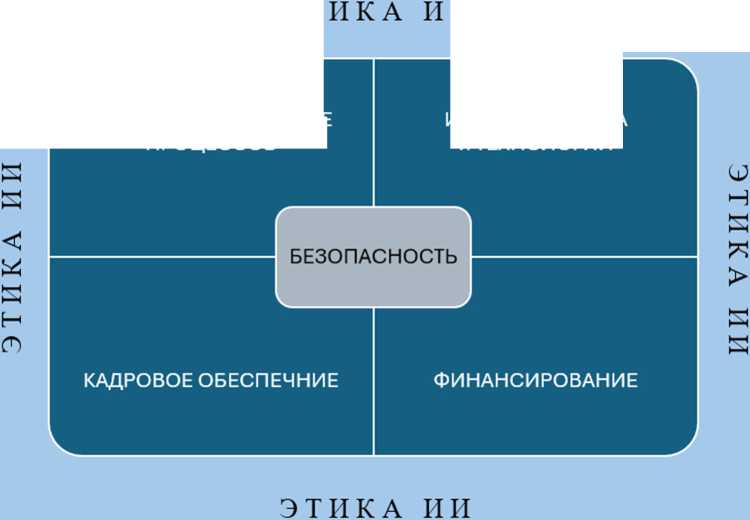

На индивидуальном уровне, например, выделяется проблема «цифрового доверия», когда в фокусе анализа оказывается отношение граждан к различным аспектам цифровой трансформации – сохранность персональных данных, отсутствие финансовых рисков, угроз криминального характера и т.д. (рис. 2). Так, согласно данным опроса, организованного Edelman Trust Barometer, наибольшая часть респондентов доверяет blockchain-технологиям (57%), а непосредственно технологиям ИИ – 62% опрошенных [1, с. 17]. Однако следует принимать во внимание условность такого деления, поскольку риски и угрозы, реализованные на уровне отдельного гражданина, с учетом потенциала возможностей ИИ могут быть чрезвычайно быстро масштабированы, следовательно, перейти на уровень проблемы государственного или даже глобального масштаба, например, дипфейки.

Дипфейки можно охарактеризовать как синтетические слуховые или визуальные медиа, созданные с применением методов глубокого машинного обучения, создающими исключительно убедительные информационные объекты, вводящие в заблуждение целевую аудиторию, на которую тот или иной ди-пфейк был рассчитан [3, 8, 10, 13]. Такая манипуляция человеческим восприятием источников информации позволяет достигать своей главной цели разработчикам дипфейков, их заказчикам.

Синтетически сконструированные массмедиа значительно варьируются по степени технической базы организации и по особенностям их использования. Так, специалисты выделяют примитивные (низкого качества) «дешевые дипфейки» в качестве наиболее простых моделей. Вершиной в разработке и внедрении такого инструментария являются дипфейки такого свойства, которые могут оказывать чрезвычайно значимое влияние на само «восприятие реальности» тем или иным лицом, в том числе принимающим критически важные решения [11].

Конечно, генеративная идея разработки синтетического аудиовизуального контента имеет свою предысторию и не нова для современного этапа развития ИИ-технологий. Например, кинематографисты применяют подобного рода изображения, изготовленные с применением электронных технологий (CGI), уже более полувека. Вместе с тем, в наши дни эти методы перестали быть столь экономически и финансово затратными, и миллионы людей создают подобные материалы на ежедневной основе, для чего достаточными инструментами являются персональный компьютер или даже мобильный телефон [6].

Наличие цифрового доверия как составляющей репрезентации ощущения защищенности, безопасности социума, имеет большое значение для установления и поддержания общественного консенсуса по вопросам, инициированным в том числе со стороны государства (аппарата национального управления). Как отмечают зарубежные исследователи в области внедрения ИИ-технологий в государственное управление М. Узун и М. Юлдис, отсутствие консенсуса по основным вопросам государственного управления является причиной того, что парадигматический прогресс в этой в этой области знания и управления стагнирует [14, p. 436], при этом в самой сфере государственного управления необходимо четко определить некоторые из «больших вопросов», а затем начать отвечать на них [12, p. 485-487].

Рис. 2 . Ключевые компоненты цифрового доверия [1, с. 18]

Наряду с узким пониманием безопасности, в свете экспоненциального роста возможностей технологий ИИ существует расширенный подход к восприятию угроз дальнейшего интегрирования ИИ-технологий в цепочку принятия государственных решений, в первую очередь со стороны профильных ведомств (в зависимости от сферы и характера вызовов). Не удивительно, что в этом отношении фактор внедрения и использования ИИ-технологий при оценке угроз и принятии государственных и государственно-ориентированных решений связывает такие, казалось бы, далекие и напрямую не связанные области, как, скажем, государственное регулирование фармацевтической деятельности или санитарноэпидемиологический контроль.

На самом деле, в наше время именно технологии ИИ становятся драйвером и стержнем «новой глобализации» на микроуровне (мегаполисы, административно-территориальные единицы, экономико-географические регионы, внутригосударственная юрисдикция) и макроуровне (государства, группы государств, международные организации, мировое сообщество) управления различными социально-экономическими и политическими процессами. Показателен пример из области цифровой фармакологии.

Ежегодно фармакологические корпорации инвестируют сотни миллиардов долларов США на разработку и дизайн различных лекарственных средств. С другой стороны, для того чтобы справиться с кризисом, связанным с экспоненциальным ростом затрат на исследования и разработки в этих областях, необходимо разработать новые подходы, и для этого большие перспективы имеют молекулярные технологии с интенсивным использованием данных [11].

Даже само по себе химическое пространство в силу своих астрономических масштабов, не поддающихся даже примерному осмыслению с позиций современного знания, лишь порождая все новые и новые вопросы, свидетельствует о том, что на нынешнем этапе экспоненциального роста технологических возможностей применение определенной информации об этом химическом пространстве в качестве основания для принятия того или иного решения (в том числе государственного регулятора или законодателя) весьма затруднительно. Кроме того, даже регистрация одного пестицида, как показывает опыт США, может потребовать проведения 300 и более исследований, причем четверть из них связана с определением токсичности и оценивается десятками миллионов долларов США (U.S. Environment Protection Agency; Code of Federal Regulations (40 CFR Part 158)). Также вызывают серьезные опасения и гибридные технологии использования ИИ для редактирования генома и создания новых биологических объектов.

Все это подводит к формулированию важного сущностного противоречия внедрения технологий ИИ в государственное управление: существует огромный дисбаланс между стремительно возрастающими возможностями технологий, создаваемых на основе ИИ, и темпами роста человеческого мыслительного потенциала, используемого при решении управленческих задач на государственной службе и при принятии решений, способности государства вырабатывать целевые установки и формулировать программы их достижения. Именно формулируемая на основе общепринятых норм этика в области ИИ призвана отчасти сгладить эту диспропорцию.

Вместе с тем, придание этике в области ИИ универсального (межгосударственного, наднационального) характера все больше превращает ее не в средство преодоления важнейших противоречий в развитии человечества, а, наоборот, повышает ее конфликтогенность и потенциал средства глобальной конкурентной борьбы. Показателен пример Рекомендации об этике искусственного интеллекта, одобренной ЮНЕСКО 23 ноября 2021 г. ЮНЕСКО отмечает, что аккумуляция данных о поведенческих аспектах человека и использование вычислительных технологий для их обработки ставит перед человечеством новые вопросы, затрагивающие обеспечение прав человека, свободы обмена информацией и образования. В качестве цели политики ЮНЕСКО в области ИИ обозначено использование возможностей новых ИТ-технологий для построения «общества знаний» и достижения целей устойчивого развития [4, 5].

В настоящее время на площадке ООН по вопросам образования, науки и культуры осуществляется проработка подходов, нацеленных на решение ряда важнейших задач, стоящих перед международной организацией в части глобального измерения и изучения ситуации с ИИ, выработки управленческих подходов в этой области. В числе таких проблем можно назвать деятельность глобальных технологических корпораций, де-факто монополий. Кроме того, является актуальным вопрос о том, какими должны быть инструменты противодействия международного сообщества для защиты глобального рынка, глобальной технологической среды от монополизации сферы ИИ.

Позиция представителей Российской Федерации при ЮНЕСКО по указанной проблематике исходит из признания принципов безусловного приоритета интересов человека, его безопасности и свободы выбора. На таком подходе основывается убежденность в том, что не должно быть единого правообладателя технологий ИИ. Наряду с этим в данной области сохраняется много сложностей, например, обеспечение контрольно-надзорных функций, их обоснованности и потенциала последующей концентрации данных полномочий. Какими должны и какими будут критерии такого надзора и агрегации полномочий?

Наряду с этим, ЮНЕСКО разрабатываются подходы к обеспечению развития технологий ИИ и влияния этого процесса на экологию с учетом возрастающих энергозатрат и объемов компонентов инфраструктуры. Также не исключена вероятность подписания в будущем аналога Киотского протокола в сфере ИИ на площадке ЮНЕСКО, который бы ограничивал вызываемые использованием технологий на основе ИИ и суперкомпьютеров негативные воздействия на окружающую среду [5].

Заключение

На основании результатов произведенного анализа основных рисков и трудностей внедрения технологий ИИ в систему государственного управления возможно определить ряд контуров нового парадиг-мального подхода к преодолению существующих противоречий в этих многоаспектных процессах на современном этапе.

Полученные результаты позволяют дифференцировать элементы применимой на практике парадигмы разумной (научно обоснованной) лимитации пределов внедрения технологий ИИ в государственном управлении на основе двух теоретических платформ: парадигмы самоограничения, при оценке ограничений технологического (физического) характера, например, соответствия информационно-технологической инфраструктуры планируемым к внедрению технологиям ИИ; при оценке рисков, связанных с процессами в физическом, химическом и биологическим пространствах; парадигмы самоограничения, когда в фокусе концептуально-теоретического прогнозирования находятся гуманитарные (субъективные) аспекты – правовые, этические, социально-экономические, идеологические и иные ограничители.